隨著生成式 AI 不斷發展,顯然需要一套對廠商中立的性能基準。由產業人士和學術界組成的開放工程聯盟(MLCommons)自 2018 年推出 MLPerf 基準測試,是衡量機器學習性能、提高科技透明度的常見指標,現在 MLPerf 4.0 版本正式頒布。

最新 MLPerf Inference v4.0 是自 2023 年 9 月發表 MLPerf Inference v3.1 以來,針對推論性能再度更新基準測試,在不同硬體和軟體上使用相似資料集和參數進行測試,產生超過 8,500 個性能結果。

這次套件中包含兩個新基準測試,其中 Llama 2 70B 模型具 700 億參數,比 MLPerf Inference v3.1 引進的 GPT-J 大一個量級,被用來代表更大的大型語言模型。還選擇 Stable Diffusion XL 代表文字生成圖像模型,進行基準測試能夠計算延遲、生成量等指標,了解整體性能。

「MLPerf 有助於向買家提供資訊,幫助他們做出決策並了解系統(無論地端系統、雲端系統還是嵌入式系統)如何執行相關工作負載。」MLCommons 創辦人暨執行董事 David Kanter 表示,「如果想要採購一套系統執行大型語言模型推論,可以使用 MLPerf 幫助你了解這些系統應是什麼樣子。」

過去一年科技產業發生許多變化,包括 NVIDIA、英特爾在內大型廠商忙於改進硬體和軟體,進一步使推論最佳化。透過 MLPerf Inference v4.0,顯示 NVIDIA 和英特爾技術皆有顯著進步。

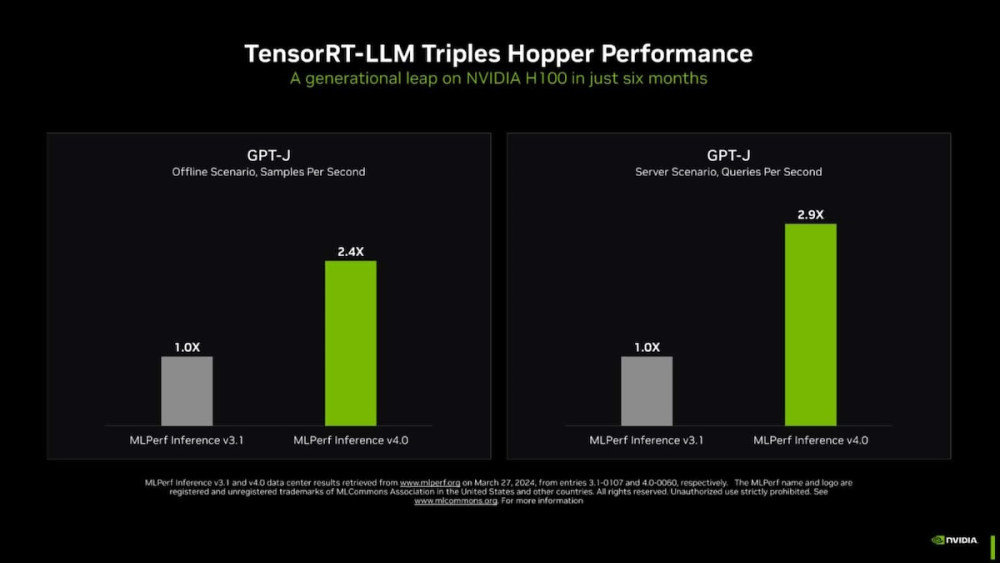

使用 NVIDIA 的 TensorRT-LLM 開源推論技術下,能夠在 Hopper 架構的 H100 GPU 上使用 GPT-J 大型語言模型,使文字摘要的推論性能比 6 個月前提升近 3 倍。H200 GPU 基準測試首次亮相,使用 Llama 2 進行推論評估時,H200 比 H100 快 45%。至於 NVIDIA 上週在 GTC AI 大會發表新一代 Blackwell GPU,尚未進行基準測試。

(Source:)

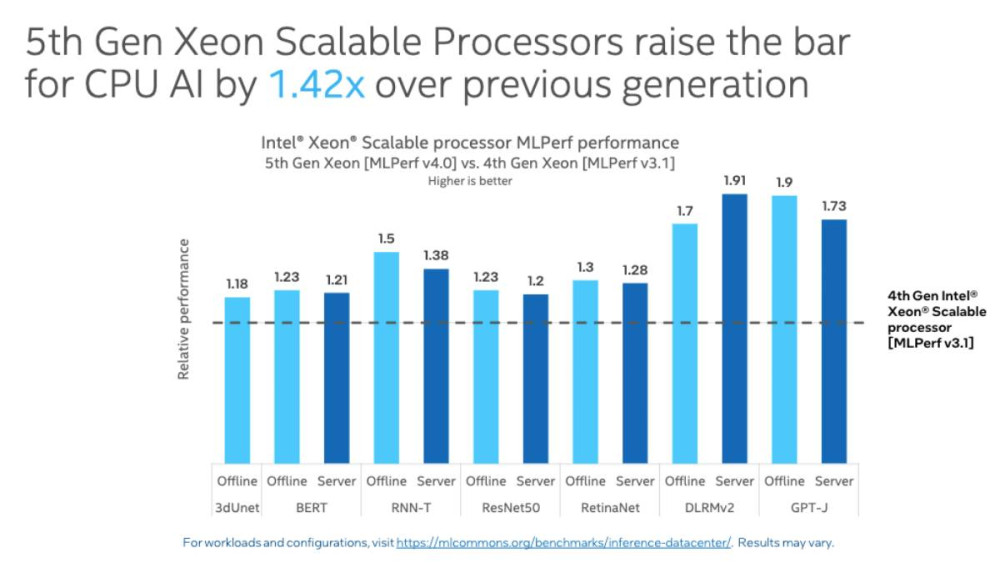

英特爾在第二代 Gaudi 深度學習加速器 Gaudi 2 和第五代 Xeon 可擴充處理器也取得最新基準測試成果。Gaudi 2 性能結果雖落後 H100 GPU,但稱它提供更好的成本效益。此外,英特爾是唯一提交基準測試的伺服器處理器供應商,第五代 Xeon 可擴充處理器的性能結果比第四代平均增加 1.42 倍。

(Source:)

(首圖來源:)

標題:MLPerf 4.0 基準測試發表,NVIDIA、英特爾 AI 硬體性能顯著進步

地址:https://www.utechfun.com/post/351039.html