Meta 在其工程部落格公開兩座 AI 資料中心部署細節,包含超過 24,000 個 NVIDIA H100 GPU 等運算硬體以及網路、儲存、設計、性能、軟體等,Meta 正使用這些 GPU 叢集訓練下一代大型語言模型 Llama 3。

新公開的 GPU 叢集是為 Meta 在支援自然語言處理、語音辨識、影像生成等領域的 AI 研究和開發,整個叢集內含 24,576 個 NVIDIA H100 GPU,這與內含 16,000 個 NVIDIA A100 GPU 的原有叢集相比,算力明顯成長。

新的 AI 訓練叢集以 Meta 研發的 AI Research SuperCluster(RSC)為基礎,這在 2022 年已經發表。Meta 指出,新的叢集能夠支援比 RSC 更大、更複雜的模型運算,為開發生成式 AI 產品鋪路。

Meta 執行長祖克柏(Mark Zuckerberg)年初談道,Meta 正以擴大運算基礎設施為目標,2024 年底前將 35 萬個 NVIDIA H100 GPU 納入 AI 資料中心的產品組合中,並使整體運算能力接近 60 萬個 H100 規模。

▲ Meta 打造生成式 AI 運算基礎設施。(Source:)

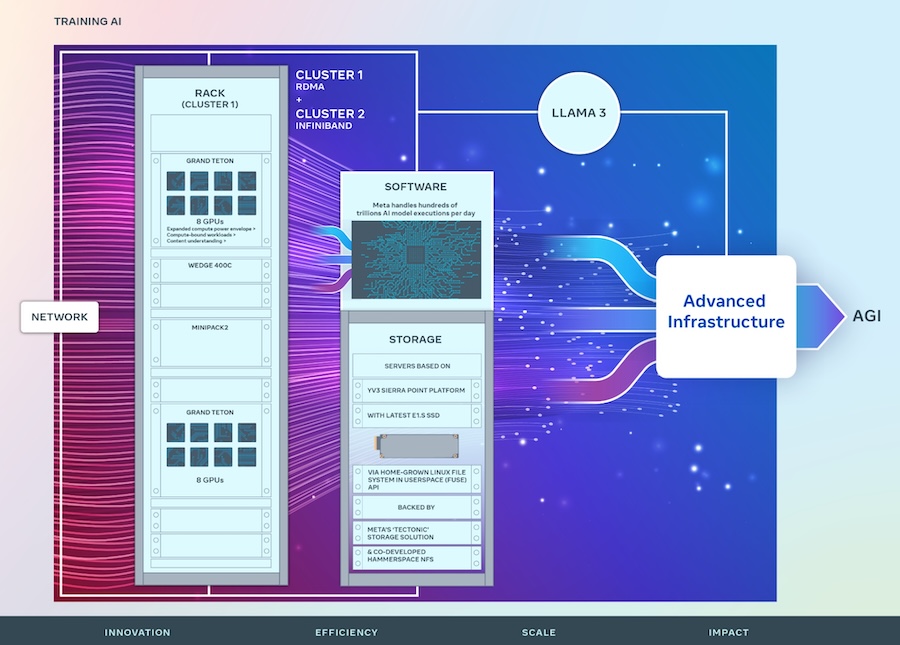

兩種 GPU 叢集的網路基礎設施有所不同,這兩種解決方案都能互連 400 Gbps 端點,但 Meta 建構了一種以 Arista 7800、Wedge400、Minipack2 OCP 機架交換器的 RoCE(RDMA over Converged Ethernet)解決方案,另一叢集則採 NVIDIA Quantum-2 InfiniBand 結構。

此外,兩種 GPU 叢集皆使用 Meta 內部開放 GPU 硬體平台 Grand Teton 所建構,可支援大型 AI 工作負載。做為 Zion-EX 平台後續產品,它包含 4 倍的主機到 GPU 頻寬、2 倍的運算和資料網路頻寬等。

這些叢集還使用 Meta 的 Open Rack 電源和機架架構進行開發,這套專門為支援 Grand Teton 等解決方案所設計,在資料中心環境提供更多彈性。針對新的叢集,每個機架的伺服器數量經過定製,以便能在每個伺服器的吞吐量、減少機架數量即在耗電效率之間達成平衡。

儲存方面,叢集在 Userspace API 中使用支援 Linux 檔案系統的 Tectonic 分散式儲存解決方案。Meta 也與開發商 Hammerspace 合作,共同開發平行網路檔案系統。

兩個叢集均以 YV3 Sierra Point 伺服器平台為基礎,配備最新的大容量 E1.S SSD。透過更改網路拓撲、網路路由以及部署 NCCL(Nvidia Collective Communications Library),達到最佳網路使用率。

Meta 也表示,會持續發展以 PyTorch 為基礎的 AI 框架,為數十萬次 GPU 訓練做好準備。

(首圖來源:)

標題:2.4 萬個 H100 GPU 訓練 Llama 3 新模型,Meta 展示 AI 運算火力

地址:https://www.utechfun.com/post/345339.html