過去十年,人工智能系統飛速發展。從2016年Alpha Go在復雜的圍棋遊戲中擊敗李世石开始,人工智能現在能夠比人類更好地識別圖像和語音,並通過包括商學院考試等在內的測試。

近期,在美國參議院司法委員會關於監管人工智能的聽證會上,康涅狄格州參議員理查德·布盧門撒爾(Richard Blumenthal)描述了其人們對人工智能最新進展的反應。“這個被反復使用的詞很可怕。”

負責監督會議的隱私、技術和法律小組委員會聽取了三名專家證人的證詞,他們強調了人工智能的進展速度。證人之一、著名人工智能公司Anthropic的首席執行官達裏奧·阿莫代伊(Dario Amodei)表示:“了解人工智能最重要的一點是它的發展速度有多快。”

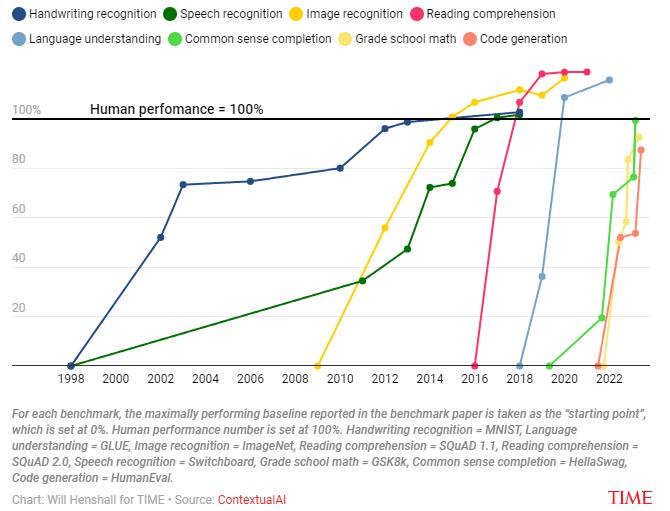

人工智能已經在許多任務上超越了人類,而且人類在新任務上被超越的速度正在增加。相對於人類的表現,最先進的人工智能表現都在人類基准之上。

如上圖所示,人工智能在手寫識別(Handwriting recognition),語音理解(Speech recognition),圖像識別(Image recognition),閱讀理解(Reading comprehension ),語言理解(Language understanding)等方面已經超越人類,而在常識補全(Common sense completion),小學數學(Grade school math),代碼生成(Code generation )方面也與人類水平非常接近。因此,按照這個發展趨勢,未來幾年人工智能將在更多的領域實現對人類的超越。

過去,人們通常認爲科學技術進步從根本上來說是不可預測的,並且是由事後更清晰的洞察力所驅動的。但可以預見的是,人工智能系統能力的進步是由計算、數據和算法這三種輸入的進步推動的。過去70年的大部分進步都是研究人員使用更強的計算處理能力(通常稱爲“計算”)來訓練人工智能系統的結果,爲系統提供更多數據,或者提出有效減少獲得相同結果所需的計算或數據量的算法技巧。

因此,了解了過去這三個因素如何推動人工智能進步,是理解爲什么大多數從事人工智能工作的人預計AI的進展不會很快放緩的關鍵。

計算

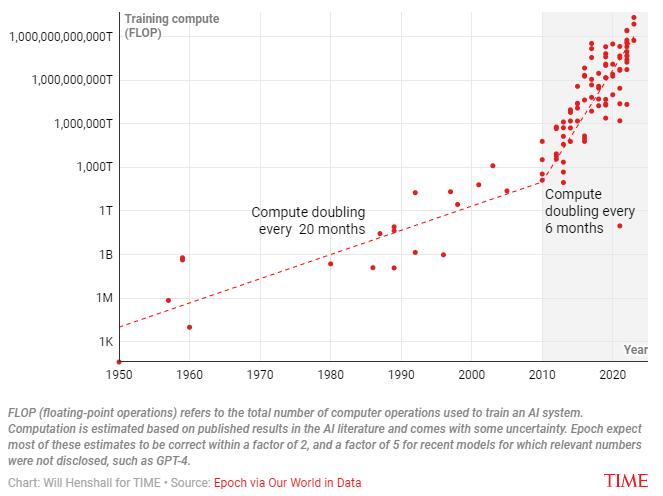

世界上第一個人工神經網絡Perceptron Mark I於1957年开發出來,當時它可以學習辨別卡片是標記在左側還是右側。它有1000個人工神經元,訓練它需要大約700000次操作。70多年後,OpenAI發布了大型語言模型GPT-4。訓練 GPT-4 估計需要 21*10²⁴次運算。

計算量的增加使人工智能系統能夠攝取更多的數據,這意味着系統有更多的例子可供學習。更多的計算還允許系統更詳細地對數據中變量之間的關系進行建模,這意味着它可以從顯示的示例中得出更准確和細致的結論。

自 1965 年以來,摩爾定律(即集成電路中晶體管的數量大約每兩年增加一倍)意味着計算的價格一直在穩步下降。研究機構Epoch的主管傑米·塞維利亞(Jaime Sevilla)表示,雖然這確實意味着用於訓練人工智能系統的計算量增加了,但研究人員更專注於开發構建人工智能系統的新技術,而不是關注用於訓練這些系統的計算量。

傑米·塞維利亞(Jaime Sevilla)說,這種情況在2010年左右發生了變化。“人們意識到,如果要訓練更大的模型,實際上不會得到收益遞減的結果,”這是當時普遍持有的觀點。

從那時起,开發人員花費越來越多的資金來訓練更大規模的模型。訓練人工智能系統需要昂貴的專用芯片。人工智能开發人員要么構建自己的計算基礎設施,要么向雲計算提供商付費以訪問他們的計算基礎設施。OpenAI首席執行官Sam Altman表示,GPT-4 的訓練成本超過1億美元。這種支出的增加,加上摩爾定律導致的計算成本的持續下降,導致人工智能模型需要接受大量計算的訓練。

OpenAI和Anthropic兩家領先的人工智能公司各自從投資者那裏籌集了數十億美元,用於支付他們用於訓練人工智能系統的計算費用,並且每家都與財力雄厚的科技巨頭建立了合作夥伴關系——OpenAI與微軟、Anthropic與谷歌。

從上圖可以看出,自1950年以來,用於訓練人工智能系統的計算量一直在增加,增長率在2010年开始明顯增加。

數據

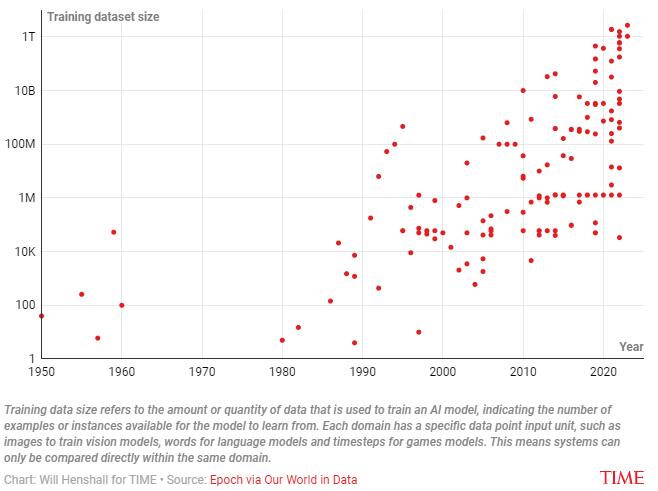

人工智能系統的工作原理是建立訓練數據中變量之間關系的模型。一般來說,更多的數據點意味着人工智能系統擁有更多的信息來建立數據中變量之間關系的准確模型,從而提高性能。

關於Perceptron Mark I 的最初研究論文稱,它僅根據六個數據點進行訓練。相比之下,LlaMa是由Meta 研究人員开發並於2023年發布的大型語言模型,接受了約10億個數據點的訓練,比Perceptron Mark 1增加了1.6億多倍。就LlaMa而言,數據點是從以下多種來源位置收集的文本:其中67%來自Common Crawl數據(Common Crawl 是一個非營利組織,負責抓取互聯網並免費提供收集到的數據),4.5%來自GitHub(軟件开發人員使用的互聯網服務),以及 4.5%來自維基百科。

上圖反映了在過去的70年裏,用於訓練人工智能模型的數據點數量急劇增加。

算法

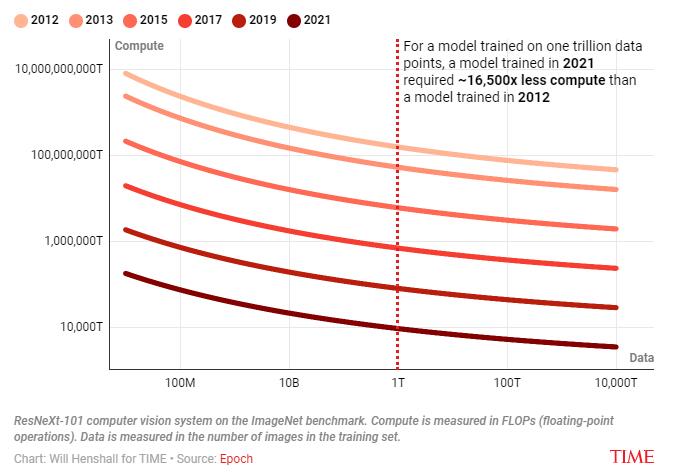

算法(定義要執行的操作序列的規則或指令集)決定人工智能系統如何准確地使用計算能力來對給定數據中的變量之間的關系進行建模。除了使用越來越多的計算量來簡單地訓練人工智能系統以獲取更多數據外,人工智能开發人員還一直在尋找從更少的資源中獲得更多收益的方法。Epoch 的研究發現,“每九個月,更好的算法的引入就相當於計算預算增加了一倍。”

算法的進步意味着需要更少的計算和數據來達到給定的性能水平,上圖在圖像識別測試中達到80.9%准確率所需的計算量和數據點數。對於在一萬億個數據點上訓練的模型,2021年訓練的模型所需的計算量比2012年訓練的模型少16500倍。

人工智能的下一階段進展

根據Epoch的主管傑米·塞維利亞(Jaime Sevilla) 的說法,人工智能开發人員用於訓練其系統的計算量可能會在一段時間內繼續以目前的加速速度增加,因爲企業會增加在訓練每個人工智能系統上花費的資金,並且隨着計算價格持續穩定下降效率也會提高。Sevilla預測這種情況將持續下去,直到某個時候不再值得繼續花更多的錢,因爲增加計算量只能略微提高性能。此後,所使用的計算量將繼續增加,但速度會減慢,這完全是由於摩爾定律導致計算成本下降。

輸入現代人工智能系統(例如 LlaMa)的數據是從互聯網上抓取的。從歷史上看,限制輸入人工智能系統的數據量的因素一直是擁有足夠的計算來處理這些數據。但是,最近用於訓練人工智能系統的數據量激增,已經超過了互聯網上新文本數據的產生速度, Epoch的研究人員預測,到2026年,人工智能开發人員將耗盡高質量的語言數據。

那些开發人工智能系統的人往往不太關心這個問題。OpenAI首席科學家 Ilya Sutskever表示,“數據情況仍然相當不錯。還有很多事情要做。” 而人工智能公司Anthropic的首席執行官達裏奧·阿莫代伊(Dario Amodei) 則估計,“這種擴展可能有10%的可能性會因無法收集足夠的數據而中斷。”

塞維利亞還相信,數據缺乏不會阻礙人工智能的進一步改進——例如找到使用低質量語言數據的方法——因爲與計算不同,數據缺乏以前並不是人工智能進步的瓶頸。他預計人工智能开發人員可能會發現許多容易實現的創新成果來解決這個問題。

傑米·塞維利亞(Jaime Sevilla)表示,算法的進步可能會繼續增強用於訓練人工智能系統的計算和數據量。到目前爲止,大多數改進都來自於更有效地使用計算。Epoch發現過去超過四分之三的算法進步都被用來彌補計算方面的不足。如果未來,隨着數據成爲人工智能訓練進展的瓶頸,更多的算法進展可能會集中在彌補數據的不足上。

將這三部分放在一起,包括傑米·塞維利亞(Jaime Sevilla) 在內的專家預計人工智能至少在未來幾年將繼續以驚人的速度取得進展。隨着企業花費更多的錢並且底層技術變得更便宜,計算將繼續增加。互聯網上剩余的有用數據將用於訓練人工智能模型,研究人員將繼續尋找訓練和運行人工智能系統的方法,以更有效地利用計算和數據。

這些十年趨勢的延續是專家認爲人工智能將繼續變得更加強大的原因。這讓很多專家感到擔憂。

達裏奧·阿莫代伊(Dario Amodei) 在美國參議院委員會聽證會上發言時表示,如果繼續以同樣的速度取得進展,在未來兩到三年內,很多人都能夠獲得即使是今天的專家也無法掌握的科學知識。他表示,這可能會增加“造成嚴重破壞”的人數。“我特別擔心人工智能系統可能會在網絡安全、核技術、化學,尤其是生物學領域被大規模濫用。”

本文作者:Will Henshall 資料來源:TIME

標題:爲何AI發展速度不大可能放緩?4張圖表告訴你

地址:https://www.utechfun.com/post/247219.html