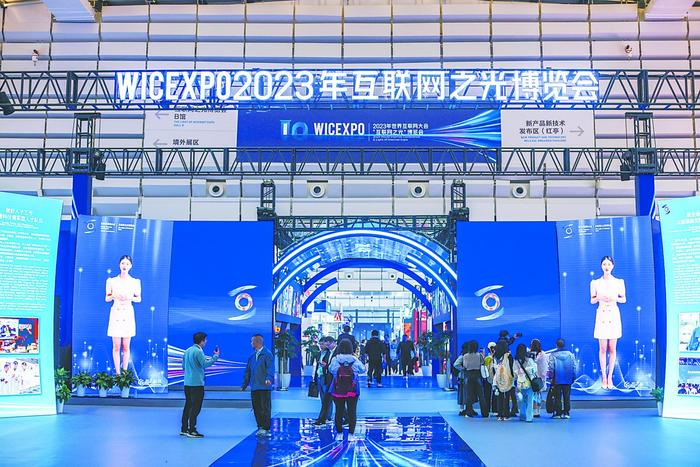

[環球時報赴烏鎮特派記者 劉揚 李炫旻]隨着以ChatGPT爲代表的生成式人工智能大模型持續火爆,全球科技公司、科研機構紛紛布局自己的大模型。生成式人工智能與大模型的快速發展,也給網絡安全帶來全新挑战。在8日开幕的2023年世界互聯網大會烏鎮峰會上,國內外安全專家紛紛從各自角度闡釋對人工智能大模型時代網絡安全新挑战的理解,《環球時報》記者在“互聯網之光”博覽會上看到大部分展台都有大模型相關展品,其中不乏“以魔法打敗魔法”的大模型安全整體解決方案。

人工智能大模型帶來哪些挑战

在9日舉行的世界互聯網大會烏鎮峰會“人工智能賦能產業發展論壇”上,中外專家共同發布了《發展負責任的生成式人工智能研究報告及共識文件》(以下稱報告)。報告提到,近年來,生成式人工智能在文本、代碼、圖像、音視頻等方面的理解與生成取得突破性進展,有望大幅提升社會生產力。與此同時,報告也用專門的一章解讀了生成式人工智能帶來的風險。

報告稱,生成式人工智能技術在迭代升級的同時也放大了技術安全風險。數據方面,數據投喂帶來價值偏見、隱私泄露、數據污染等問題:訓練數據固有偏見導致模型產生偏見內容;海量訓練數據擴大了數據安全和隱私保護風險。算法方面,算法模型生成特性及安全漏洞會引發“幻覺”或虛假信息、模型遭受攻擊等風險。報告還提到兩大更深層次的風險:生成式人工智能重構人機關系可能帶來科技倫理失範;強大的任務處理能力,容易導致人的思維依賴;生成式人工智能凸顯發展的不均衡引發人類社會發展差距進一步拉大。

《環球時報》記者在“互聯網之光”博覽會上也感受了生成式人工智能可能帶給普通人的安全風險。在一個聚焦青少年編程的公司展台,記者體驗“看到的也未必是真實的”換臉揭祕實驗。在機器前站幾秒鐘之後,AI就根據記者的外貌特徵提供了兩個換臉模型,一個是秒變“憨豆先生”,另一個是滿臉大胡子。據展台工作人員介紹,這就是對青少年進行“換臉”風險的科普。

一名已經第十次參加世界互聯網大會的中國網絡安全專家對《環球時報》記者表示,前幾年我們關注雲安全、大數據安全、物聯網安全,但今天大模型安全是一個必須重視的話題。

大模型如何保障重大活動安保

公开報道顯示,2012年倫敦奧運會,多家媒體遭遇網絡攻擊;2016年裏約奧運會遭到大規模APT襲擊、DDoS攻擊;2018年平昌冬奧會更是遭遇了奧運史上最大的網絡安全事故。《環球時報》記者在“互聯網之光”博覽會上了解到,前不久成功舉辦的杭州亞運會,不僅是一場體育成績、大型活動組織的比拼,更是一場網絡安全攻防對抗的較量。

《環球時報》記者在“互聯網之光”博覽會現場看到一個巨大的顯示屏,以動態形式直觀地演示杭州亞運會網絡安保過程中的態勢感知與快速應對能力。據安恆信息副總裁梁浩介紹,現場展示的MSS亞運天穹——新一代主動防御運營中心是服務於杭州亞運安保防護體系的綜合運營中心,它實際上是結合本次亞運會的建設範圍來進行定義的,涉及整個亞運會88個競賽和非競賽場館,相關安全細節、措施、問題都可以通過這個運營中心的視角及時掌握。如果有需要隨時能夠查看到具體場館裏相關的IT機房,檢查安全防護設備在哪個槽位,如有異常、中斷、告警,都能夠及時反饋處置。

據介紹,杭州亞運會的運動員人數、賽事項目規模和場館數量大概4倍於北京冬奧會,如果按照傳統方式可能需要數千人才能完成安保,但實際上本次亞運會現場安保只有400多人,如何在這么大範圍內用較少的人員去滿足安保需求,其實就是用了大模型技術。“我們將大模型在安全領域進行了結合,幫助現場分析人員快速輔助進行研判,並提供處置方案。特別是在重點活動保障方面,對時效性要求特別高,比如在杭州亞運會期間觀測到有超過2600萬次的網絡攻擊,在整個攔截過程中更多是用了自動化的關聯和阻斷技術,其中也用到了人工智能和大模型的能力。”

如何“用魔法打敗魔法”

爲了應對生成式人工智能與大模型帶來的挑战,國內網絡安全領域的頭部公司也紛紛在“互聯網之光”博覽會上展出解決方案。《環球時報》記者印象最深的就是用AI對付AI、“用魔法打敗魔法”。比如在奇安信展台,記者看到“大模型衛士”提供的一系列強大防護能力。阿裏巴巴展台也提出“大模型安全全鏈路解決方案”。

參加本次世界互聯網大會的360集團創始人周鴻禕在接受《環球時報》採訪時表示,所有數字化技術必然都是雙刃劍,有軟件就會有漏洞,有漏洞就會被攻擊,人工智能大模型也不可避免。周鴻禕認爲,人工智能面臨的安全問題可分爲三級:初級/近期問題、中級/中期問題和高級/長期問題。初級/近期問題是技術攻擊問題,也就是網絡攻擊、漏洞攻擊、數據攻擊問題,特別是提供給大模型不好的數據或污染它的訓練數據,可能會導致結果出錯。這類問題相對比較好解決。比較難解決的是中級/中期問題,主要涉及內容安全。例如大模型可以成爲人們很好的幫手,也能成爲壞人的工具。它可以幫一個水平不怎么樣的黑客寫更好的攻擊代碼、詐騙郵件。如何讓它的內容更加可控?如何防止人工智能大模型不作惡?這已經超越技術範疇了。盡管現在有人爲大模型做了內置的所謂“安全護欄”,但它很容易遭到注入攻擊或算法攻擊。這類問題的解決思路之一是开發小規模模型,專門針對不懷好意的提問,讓大模型在回答用戶問題前先用小模型過濾。

周鴻禕認爲,從高級/長期的問題來看,大模型可以把人類所有知識融會貫通,再來和人類做交流、做提示。但對於未來萬一大模型能力超越人類後,還能不能甘於做人類的工具,周鴻禕表示,“我的一個觀點是,這些技術帶來的挑战最終還得靠技術來解決,技術自身會不斷進化。不能因爲未來還沒有發生的問題就不發展相關技術”。

在8日舉行的2023年世界互聯網大會藍皮書新聞發布會上,中國網絡空間研究院網信理論與战略研究所副所長姜淑麗介紹說,中國堅持安全與發展並重的原則,爲生成式人工智能發展營造創新生態,同時重視防範風險,制定人工智能監管規則。2023年7月,中國發布《生成式人工智能服務管理暫行辦法》,是全球範圍內首部針對生成式人工智能的管理辦法。同時,中國發起“全球人工智能治理倡議”,明確提出發展人工智能堅持相互尊重、平等互利的原則。

責任編輯:劉德賓

標題:數據投喂泄露隱私,算法生成虛假信息,大模型時代怎么防範安全風險?

地址:https://www.utechfun.com/post/289051.html