研調機構 TrendForce 17 日舉辦 AI 伺服器論壇,美光透露目前 DDR5 醞釀許久,而 HBM 產能在 2025 年前已滿載,美光在各種記憶體產品有多種佈局,也為 AI 資料中心提供強大支持。

美光在全球布局超過 54,000 項專利,記憶體和存儲技術領先業界,目前已經醞釀很久 DDR5,下一代會做到 1γ 製程,採用 EUV 製程技術,計畫 2025 年率先在台灣量產。

美光表示,公司擁有廣泛的產品群組、長週期生命產品,以及完整的系統規劃。隨著 AI 改變資料中心生態,讀取方式已經不同,必須跟著 AI 神經網路模式運作,因此深度學習的讀寫比率已經到 5000:1,意味著讀取速度遠超過寫入速度,因此選擇合適的儲存設備相當重要。

對此,美光也進行伺服器架構優化,當 GPU 伺服器和 SSD 以 1:1 方式進行訓練,效能會做到最好。另外,隨著 AI 時代來臨,在 AI 效能和成本間的平衡也越發重要,美光推出能最佳化現有系統並延長設備壽命的DDR4,速度高達 3,200MT/s。在多核心 CPU 架構下,美光 DDR5 以 6,400MT/s 速度,使頻寬增至 DDR4 的2 倍、深度學習效能為 DDR4 的 5 倍、AI 性能提升 7 倍,支持 AI、HPC 和企業負載。

NAND 部分,美光目前推出 232 層 NAND,以穩定在產品上應用為主,並同步發展 HBM3e 甚至 HBM4。美光表示,CXL 也是未來相當重要的發展方向,目前推出的 CZ120 為記憶體擴充模組,可提供更多容量、頻寬和靈活配置,是較為前端的應用,目前台灣樣品已經分享給合作夥伴。

晶心科提供客製化指令集工具 ACE,增加設計彈性

晶心科技資深技術經理胡鴻光指出,RISC-V 具有模組化優勢;開源架構、沒有法律問題;可最少指令集進行設計,因此能做到非常精簡、有效率的狀態;具有客製化優點,每個客戶能自己增加指令和自己的功能。RISC-V 架構可以用於資料中心、車用、行動裝置等任何 AI 需求產品。

晶心科成立已經有 19 年,在今年 1 月的 SHD 報告中,該公司在 RISC-V IP 供應商中市佔率高達 30%,聯發科、聯詠、瑞薩、群聯等都有長期合作,另外一個主要大客戶是 Meta。

胡鴻光認為 Meta 之所以選擇 RISC-V,優勢在於容易客製化、有極大彈性,而 RISC-V 新出的矢量指令集在做 AI 運算極具影響力,另外晶心科提供客製化指令集工具 Andes Custom Extension(ACE),提供 Meta 增加私有客製指令介面與暫存器,可達成其需求。

TrendForce:AI 伺服器需求暢旺,出貨量年增近 41%

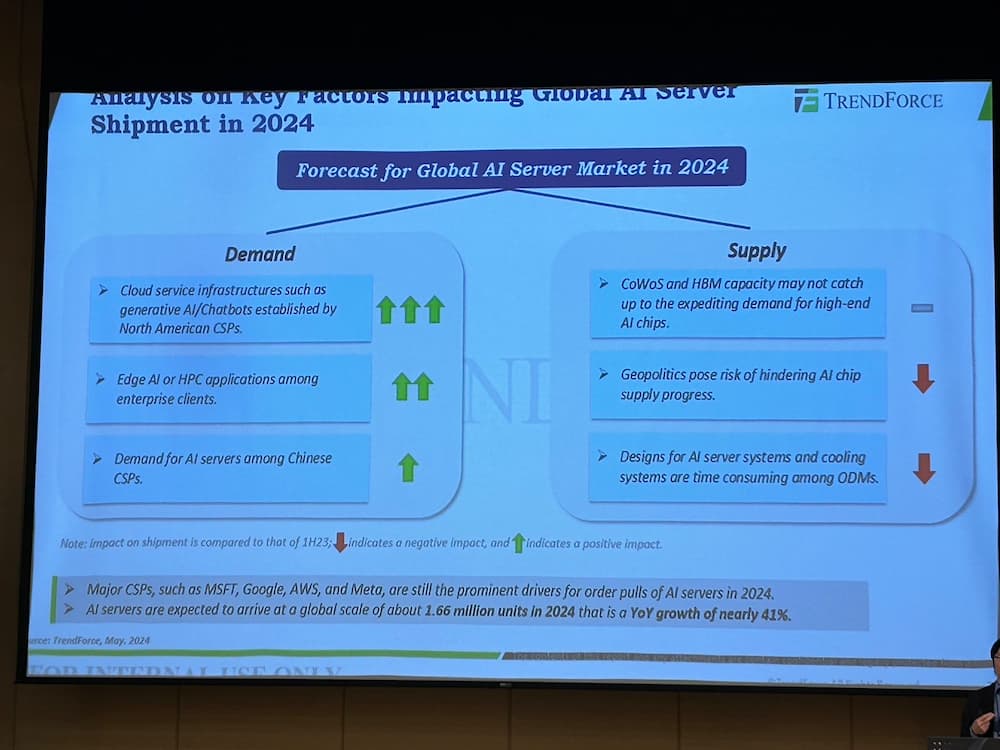

最後針對 AI 伺服器市況,TrendForce 資深分析師龔明德指出,有幾大重點領域,主要拉貨領域包括北美 CSP(雲端服務供應商),包括公有雲、搜尋引擎、廣告推薦系統等。

AI 伺服器供需部分,需求面仍以北美四大 CSP 主要帶動成長,整體需求強勁,因為品牌商獲得去年較難拿到短缺 GPU,加上中國市場也建置本地 AI 需求;至於供給面,去年的 CoWoS、HBM 短缺問題已經緩解,但仍有兩點恐造成供給端風險,首先是地緣政治,即中國市場因為美國禁令而難以取得高階 AI GPU,再來是 AI 伺服器設計上較為複雜,恐致延後風險。

今年伺服器僅成長近2%,因為受到 AI 預算排擠,而 AI 伺服器需求暢旺,出貨量可望達 166 萬台,年增近 41%。龔明德預期,今年第二季成長較明顯,因為 Nvidia H100 前導時間(leading time)縮短,逐季看好。

龔明德預期,Nvidia 今年高階 GPU 出貨量將年增超過 110%,到下半年產品品將過渡到 H200,而 B100 將進入早期量產階段。至於 AMD 高階 AI 解決方案會主要面向 CSP,搭載 M1300X Al 晶片的 Al 伺服器預計下半年將成主流,而第二供應商的身份有望帶來 AMD 成長。

同時,CSP 內部開發的 ASIC 也將發揮關鍵作用。到了 2024 年,AWS 將在下一代 ASIC 投入大量資源,Meta 和中國 CSP 亦是如此。CSP 今年仍將是 AI 伺服器主要成長動能,尤其北美四大 CSP 已經佔六成採購量,中國自主晶片需求也會強勁。

最後針對 Nvidia Blackwell 平台,龔明德認為這款產品主要面向 CSP,並推動 CoWoS 和 HBM 出貨量在 2025 年實現雙高個位數成長。

(首圖來源:科技新報)

延伸閱讀:

標題:美光曝記憶體新進度:CZ120 記憶體擴充模組已送樣合作夥伴

地址:https://www.utechfun.com/post/372271.html