不論何種 AI 應用,速度非常重要。當我們要求熱門 AI 聊天機器人撰寫文章、電子郵件或翻譯文稿時,我們會希望輸出結果愈快愈好。如今一家專為運行 AI 語言模型設計客製化硬體,並致力提供更快 AI 的 Groq 公司,能以比普通人打字速度快 75 倍的速度呈現結果。

Groq 專為 AI、機器學習和高效能運算應用程式開發高效能處理器和軟體解決方案,千萬不要和馬斯克(Elon Musk)的 Grok 聊天機器人混淆,它並非聊天機器人,而且這家總部位於加州山景城(Mountain View)的公司目前沒有打算要訓練自己的 AI 語言模型,而會致力讓其他公司開發的模型高速運行。

當前幾乎所有 AI 工具都使用 GPU,但 Gorq 卻使用截然不同的硬體,亦即專為處理大型語言模型(LLM)而設計的 LPU(Language Processing Unit,語言處理單元)。

由於 Groq 的 LPU 專門設計用於處理像是 DNA、音樂、程式碼及自然語言之類的資料序列,因此在這類應用方面的處理效能遠勝 GPU。該公司宣稱,其用戶已經使用其引擎和 API 運行 LLM 模型,其運行速度比基於 GPU 的替代方案快 10 倍。

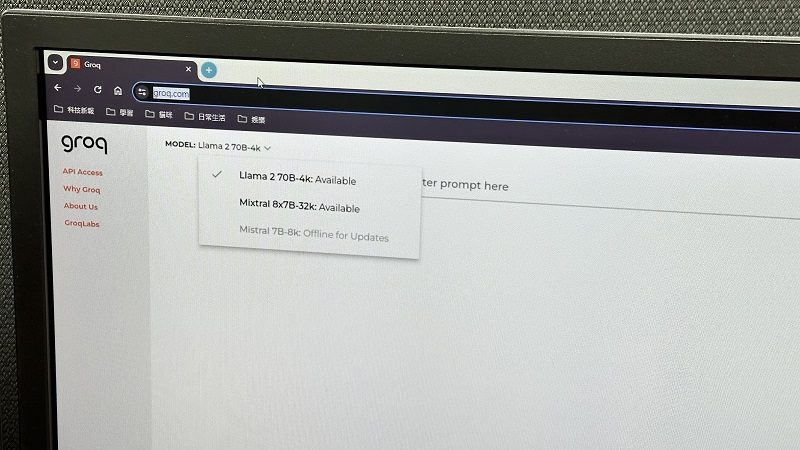

目前 Grog 在自家上提供基於三種不同 LLM 模型(目前提供的模型包括 Meta 旗下 Llama 2、法國新創 Mistal AI 旗下的 Mixtral-8x7B 和 Mistral 7B)的聊天機器人,使用者可以免費嘗試在 LPU 加持下的聊天機器人和一般 GPU 支援的效能有何不同。

(首圖來源:科技新報)

標題:Nvidia 最大夢魘來臨!AI 聊天機器人執行 Groq LPU 比 GPU 快十倍

地址:https://www.utechfun.com/post/336060.html