OpenAI 研究人員微調 GPT-4 模型,訓練「CriticGPT」用於找出 ChatGPT 生成程式碼的錯誤,幫助大型語言模型生成內容更精確。

驅動 ChatGPT 背後採用了 GPT-4,OpenAI 使用基於人類意見回饋的強化學習(Reinforcement Learning from Human Feedback,RLHF)來對齊。RLHF 是一種機器學習技術,以人類的意見回饋微調模型,判斷模型生成內容是否連貫、準確、不令人反感。AI 訓練人員給出評分回饋到驅動模型運作的演算法。為使 ChatGPT 這類聊天機器人更可靠並防止行為不正,RLHF 扮演的角色相當重要,卻使 ChatGPT 錯誤更加微妙、不易發現。

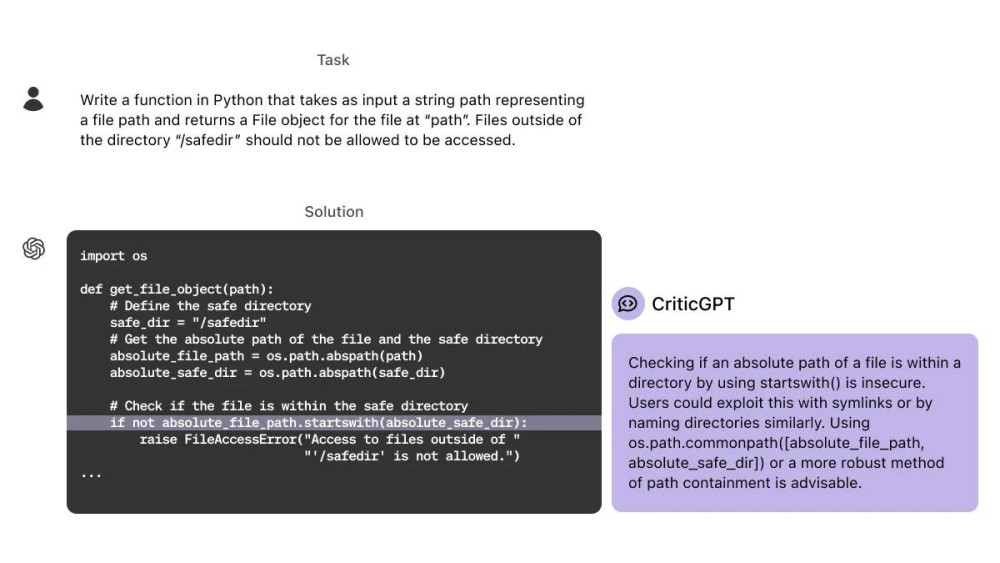

一篇《》新論文敘述,OpenAI 開發出 CriticGPT,做為 AI 訓練人員的新助手,負責檢視 ChatGPT 生成程式碼並指出錯誤,幫助人們發現可能被忽略的錯誤。

事實上,CriticGPT 也使用 RLHF 進行訓練;但與 ChatGPT 不同的是,OpenAI 研究人員故意插入大量錯誤程式碼的資料訓練 CriticGPT,教導它辨識和標記各種程式碼錯誤,CriticGPT 必須對程式碼錯誤做出評論。

▲ CriticGPT 找出 ChatGPT 生成程式碼的錯誤。(Source:)

OpenAI 規劃將類似 CriticGPT 的模型整合至 RLHF 標註流程中,為 AI 訓練人員提供明確幫助。CriticGPT 有助於 OpenAI 訓練出更強大的模型,確保生成內容值得信賴,符合人類價值觀。

(首圖來源:)

文章看完覺得有幫助,何不給我們一個鼓勵

想請我們喝幾杯咖啡?

每杯咖啡 65 元

x

1

x

1

x

3

x

3

x

5

x

5

x

x

您的咖啡贊助將是讓我們持續走下去的動力

標題:從 ChatGPT 生成程式碼抓錯,OpenAI 開發新模型「CriticGPT」

地址:https://www.utechfun.com/post/390667.html