生成式 AI 絕對是 2023 年科技產業最熱門的單字。

OpenAI 年初發表生成式應用程式 ChatGPT 造成市場大熱,引發各家科技大廠競相投入。現階段提供算力的主要來源,以輝達 (NVIDIA) 提供的 AI 加速器為大宗,但同時造成其 AI 加速器在市場上的供不應求,就連 OpenAI 也因為不想再被緊缺的供應鏈牽制,而打算自行開發晶片。

多家科技大廠決心自研 AI 加速器以滿足需求之外,另一方面,受美中科技戰限制,雖然輝達提供中國客戶減規版產品,但近期又有消息,減規版產品不受中國客戶青睞,中國廠商轉向華為求助,或自研晶片,不落人後繼續發展大型語言模型。

這波 AI 浪潮發展下,輝達無疑是 AI 算力領先者,A100 / H100 系列晶片拿下全球 AI 市場頂尖客戶訂單,研究公司 Gartner 和 Moor Insights & Strategy 表示,輝達的全球人工智慧晶片市佔率最高可能達 90% 創新高,但輝達寡佔市場使客戶須有成本高漲認知,還要面對可能搶不到貨,或購買數量太少不知道何時能到貨的壓力。

華爾街投資銀行 Bernstein Research 資深分析師 Stacy Rasgon 分析,ChatGPT 每次查詢的成本約為 0.04 美元,如果 ChatGPT 查詢量成長至 Google 搜尋規模的十分之一,最初需要部署價值約 481 億美元的 GPU 進行運算,每年還需要價值約 160 億美元的晶片才能維持運作。還有相當於 160 億美元的相關晶片來執行工作。所以,無論是為了減少成本,還是降低對輝達的過度依賴、甚至是進一步提高議價能力,全球科技大廠都已開始其自研 AI 加速器的計畫。

根據科技媒體 The Information 引述知情人士的說法報導指出,全球科技大廠包括微軟、OpenAI、特斯拉、Google、亞馬遜、Meta 等六家科技公司,都正投入研發自家 AI 加速器晶片,預計將會與輝達的旗艦級 H100 AI 加速器晶片競爭。

全球大廠自研晶片進度

微軟自研 AI 晶片傳聞未曾停過。

一年一度 Microsoft Ignite 2023 大會,終於發表資料中心 AI 晶片 Azure Maia 100 和雲端運算處理器 Azure Cobalt 100。微軟 2019 年後就傳出開發 AI 專用晶片,為大型語言模型提供動力。大會推出的 Azure Maia 100 是 AI 加速器晶片,能用於 OpenAI 模型、ChatGPT、Bing、GitHub Copilot 等 AI 工作執行。

微軟介紹,Azure Maia 100 是系列第一代產品,5 奈米製程生產。Azure Cobalt 為 Arm 架構的雲端運算處理器,配備 128 個運算核心,與目前幾代 Azure Arm 晶片相比,效能提升 40%,支援 Microsoft Teams、Azure SQL 等服務。

兩款晶片均由台積電生產,微軟已在設計第二代。有分析師表示,以 ChatGPT 每天營運成本約 70 萬美元,且大部分算力源於昂貴服務器計算,Azure Maia 100 與輝達產品有同等競爭力,每晶片成本可降低三分之一。

Open AI 也正在探索製造自研 AI 加速器晶片,並已開始評估潛在的收購目標。

先前《路透社》引述知情人士的消息指出,至少從 2022 年開始,OpenAI 就已討論各種方案,以解決 AI 晶片短缺問題。儘管 OpenAI 尚未做最終決定,但希望解決 AI 晶片短缺的選項包括打造自家 AI 晶片、與輝達等晶片製造商合作研發,OpenAI 並未正式評論。

電動車大廠特斯拉也是積極投入AI 加速器晶片的科技大廠。

特斯拉以自動駕駛需求為主,至今推出兩種 AI 晶片,分別是全自動駕駛的 FSD 晶片和 Dojo D1 晶片。FSD 晶片用於特斯拉車自動駕駛系統,Dojo D1 晶片用於特斯拉超級電腦,為通用 CPU,建構 AI 訓練晶片,為 Dojo 系統提供驅動力。

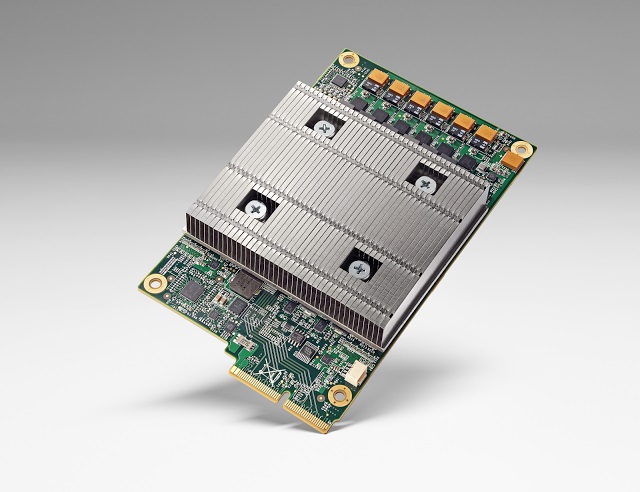

Google 也早在 2013 年就祕密研發專注 AI 機器學習演算法晶片,並用於雲端運算資料中心,取代輝達 GPU。

這款 TPU 自研晶片 2016 年公開,為深度學習模型執行大規模矩陣運算,如自然語言處理、計算機視覺和推薦系統模型。Google 其實 2020 年資料中心便建構 AI 晶片 TPU v4,直到 2023 年 4 月才首次公開細節。

亞馬遜旗下雲端運算服務提供商 AWS,從 2013 年推出首顆 Nitro1 晶片至今,為最先自研晶片的雲端廠商,擁有網路晶片、伺服器晶片、人工智慧機器學習自研晶片三條產品線。

AWS 自研 AI 晶片版圖包括推理晶片 Inferentia 和訓練晶片 Trainium。

另一方面,AWS 專為人工智慧打造的 Inferentia 2(Inf2)2023 年初發表,計算性能提高三倍,加速器總記憶體提高 25%,可透過晶片直接超高速連接支援分布式推理,最多支援 1,750 億個參數,為 AI 晶片市場最強自研廠商。

Meta 則到 2022 年仍使用 CPU 和專為加速 AI 演算法設計的客製化晶片組合執行 AI 工作,但因 CPU 的 AI 工作效率不如 GPU,Meta 取消 2022 年大規模客製晶片計畫,轉而訂購數十億美元的輝達 GPU。

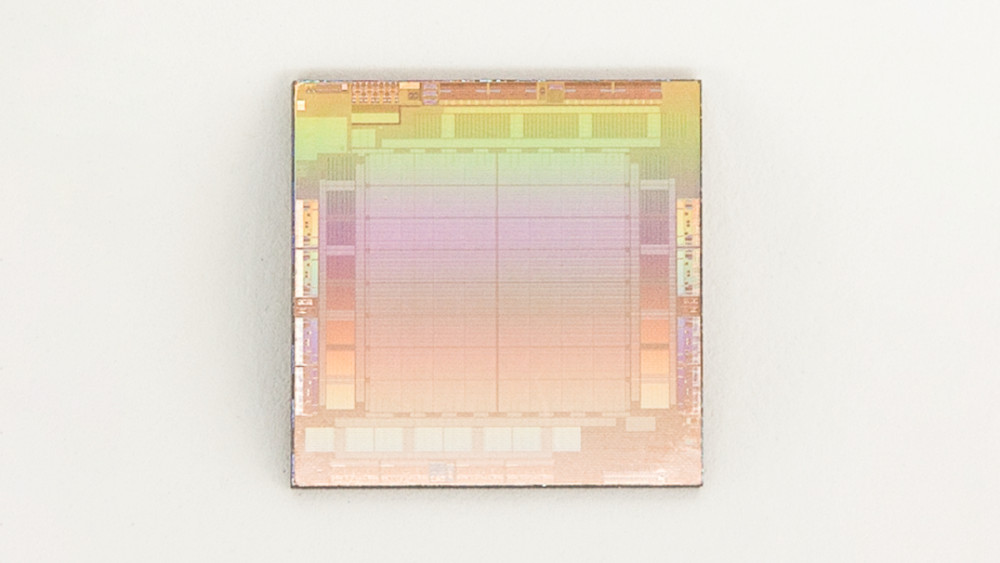

就在其他各家大廠紛紛投入自研 AI 加速器晶片, Meta 也發晶片,並 2023 年 5 月 19 日公布 AI 訓練與推理晶片。晶片功耗僅 25 瓦,為輝達相同產品功耗的 0.05%,並採 RISC-V 開源架構。市場消息指出,晶片為台積電 7 奈米生產。

中國大廠的自研晶片之路,又是另一種光景。

美國去年 10 月擴大禁止向中國出售先進人工智慧(AI)晶片,輝達雖然迅速為中國市場量身訂造新晶片,以符合美國出口規定。但近日有消息指出,阿裏巴巴、騰訊等中國雲端運算大客戶,並不熱中買功能降低的減規版 H20 晶片,轉成國內採購,如向華為買。策略轉變顯示透過部分先進半導體訂單轉給中國公司,將更依賴中國本土廠商晶片。

TrendForce 表示,中國雲端業者約八成高階 AI 晶片購自輝達,五年內可能降至 50%~60%。若美國繼續加強晶片管制,可能對輝達中國地區銷售造成額外壓力。

(首圖來源:)

標題:AI 新盛世》人工智慧市場兵家必爭,六大科技廠自研 AI 晶片爭龍頭

地址:https://www.utechfun.com/post/333710.html