OpenAI 終於從「彈藥庫」掏出 AI 影片產生工具 Sora,瞬間佔據各大新聞頭條,就連常唱衰 OpenAI 的馬斯克也承認 Sora 很強大,並盛讚「幾年內人類藉助 AI 的力量,將創造出卓越的作品」。

Sora 的強大之處在根據文本描述,產生長達 60 秒連貫流暢的影片,有細膩複雜的場景、生動角色表情及複雜鏡頭運動。與只能產生短至個位數長度的影片,Sora 一分鐘長度無疑等於掀桌。

更重要的是,無論真實性、長度、穩定性、一致性、解析度還是文本理解,Sora 均展現出最佳水準。先來欣賞官方公開的宣傳影片。

Prompt: Beautiful, snowy Tokyo city is bustling. The camera moves through the bustling city street, following several people enjoying the beautiful snowy weather and shopping at nearby stalls. Gorgeous sakura petals are flying through the wind along with snowflakes.

Introducing Sora, our text-to-video model.

Sora can create videos of up to 60 seconds featuring highly detailed scenes, complex camera motion, and multiple characters with vibrant emotions.

Prompt: “Beautiful, snowy…

— OpenAI (@OpenAI)

無人機視角的一對情侶於繁華城市街道穿梭,美麗櫻花花瓣隨著雪花在空中翩翩起舞。當其他工具還在努力保持單鏡頭穩定,Sora 已絲滑無縫切換多鏡頭,且連貫性和對象一致性都遙遙領先,真是降級打怪。過去要拍攝這類影片可能需耗費大量時間和精力先寫劇本、設計分鏡等繁瑣工作,現在僅要一段簡單文字描述,Sora 就能生出大場面,從業者或許已在瑟瑟發抖。

網友 @debarghya_das 用 Sora 剪輯、David Attenborough 在 Eleven Labs 的聲音及 iMovie YouTube 自然音樂樣本,15 分內就做出 20 多秒的預告。

Sora 是怎麼做到的?

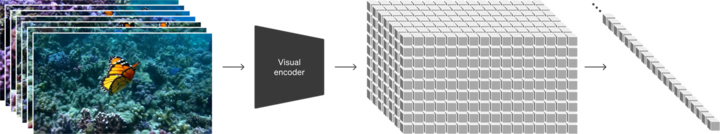

OpenAI 也公開 Sora 詳細報告,介紹技術原理和應用。受 LLM 成功經驗啟發,OpenAI 引入視覺塊嵌入代碼(patches),這是種高度可擴展且有效的視覺數據表現形式,大大提升生成模型處理多樣化影片和圖片資料的能力。

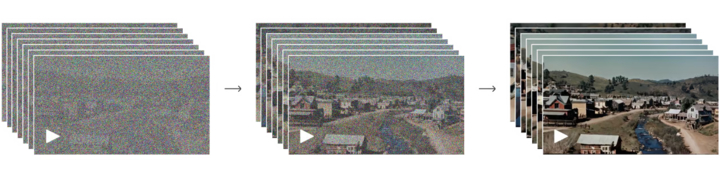

高維度空間,OpenAI 先將影片數據壓縮至低維潛在空間,然後再分解為時空嵌入,轉成一系列編碼塊,之後訓練專門降低視覺數據維度的網路,以原始影片輸入,輸出潛在表示時間和空間都經過壓縮,Sora 正是在這個壓縮後潛在空間訓練,並在這空間產生影片。

OpenAI 還訓練一解碼器模型,能將潛在表徵還原成圖元級影像。處理壓縮後影像輸入,研究員能提取出一系列時空 patchs,在模型扮演類似 Transformer Tokens 的角色。因基於 patchs 的表現形式,Sora 能適應不同解析度、持續時間及寬高比影像,產生新內容時,可將隨機初始化 patchs 照需要大小排成網格,控制最終影片大小和形式。

儘管原理聽起來很複雜,但其實 OpenAI 新技術:視覺塊嵌入代碼(簡稱視覺塊)就像將一堆雜亂無章的積木整理好放入小盒子,如此即便面對再多積木,只要找到所屬小盒子,就能輕鬆找到所需積木。影片數據轉化成一個個小方塊,當 OpenAI 給 Sora 新任務時,先從影片提取含時間和空間資訊的小方塊,之後將小方塊交給 Sora 根據資訊產生新影片,就像拼拼圖將影片重新組合。這樣做的好處是,計算機可更快學習和處理各種類型圖片和影片。

Sora 訓練越來越深入後,OpenAI 研究員還發現訓練計算量增加,樣本品質明顯提高,OpenAI 發現直接在數據原始尺寸訓練有許多優勢:

- Sora 訓練時沒有裁切素材,故能直接照不同設備的原生寬高比創建內容。

- 以影片原生寬高比訓練,明顯提升構圖與布局品質。

Sora 還有以下特性:

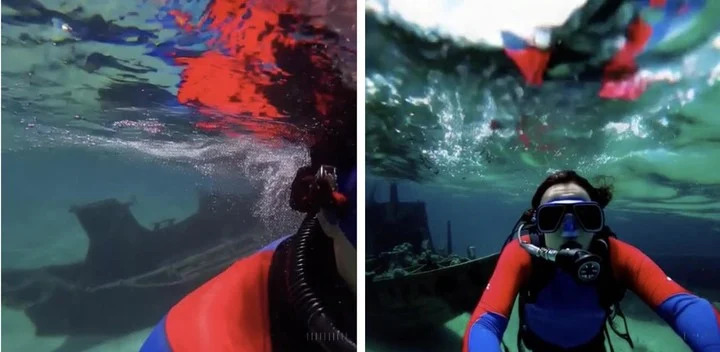

訓練文本到影片產生系統需大量有文字標題的影片,OpenAI 將 DALL‧E 3 引入的重新標註技術用於影片模型。類似 DALL‧E 3,OpenAI 使用 GPT 將使用者短提示詞轉成更長說明,發給影片模型,使 Sora 產生高品質影片。除了可從文字轉化,Sora 還能接受圖片或其他影片輸入,讓 Sora 編輯各種圖片和影片,如製作無縫循環影片、幫靜態圖片加上動畫效果、延長影片播放時間等。

如下方有「SORA」字樣的逼真雲朵圖片轉成動畫。

裝飾華麗的大廳,巨大海浪衝來,兩位衝浪者抓住機會,巧妙駕馭海浪。

無需任何示範,Sora 就能改變影片風格和環境,甚至兩個風格迥異的影片也能平滑連接。

Sora 還能文生圖,團隊可在時間範圍為一幀空間網格排列高斯雜訊塊創造出各種尺寸的圖片,最大解析度達 2,048×2,048。OpenAI 也坦率承認 Sora 目前的局限,如無法類比複雜場景的物理規則,以及理解某些特定因果關係,舉例無法精確類比玻璃破碎等基本物理互動。

▲ 反向的跑步機。

不過 OpenAI 堅信,Sora 目前能力顯示,持續擴展影片模型是朝開發類比物理和數位世界的物體、動物和人類模擬器充滿希望的途徑。

世界模型是 AI 下個方向?

OpenAI 發現大規模訓練,Sora 展示出引人注目的能力,一定程度模擬真實世界人、動物和環境,並非基於 3D 空間或物體預設,而是由大規模數據驅動產生。

- 3D 空間連貫性:Sora 能產生有動態視角變化的影片。攝影機位置和角度變動時,影片人物和場景元素能 3D 空間連貫移動。

- 遠距離連續性與物體持久性:即使人物、動物或物體被擋住或移出畫面,Sora 也能保持長時間連續性,同樣能在同影片樣本多次展示同角色,並確保外觀一致。

- 類比數位世界:Sora 還能模擬數位化過程,如遊戲,只需提及〈Minecraft〉等字,就能激發能力。

OpenAI 將 Sora 視為「理解和模擬現實世界模型的基礎」,相信能力「是實現 AGI 的重要裏程碑」,輝達高級科學家 Jim Fan 更:

如果你認為 OpenAI Sora 就像 DALL·E,只是創意實驗工具,那你可能要重新考慮了。

Sora 其實是基於資訊的物理模擬引擎,能類比真實或虛擬世界。模擬器經降噪、計算梯度,學會複雜圖像渲染、「直覺」物理行為、長遠規劃能力及語義層面理解等。

這種模型能力基礎正是通用世界模型就是人工智慧系統,目標是建立更新狀態的神經網路模組,記憶和建模環境。模型能根據觀測(圖片狀態等)和即將採取的動作,預測下個可能,學習世界規律和常識,模擬環境可能發生的事件。

世界模型並不是新概念,去年 12 月 AI 影片產生領頭羊 Runway 就宣布下場打造世界模型,目的是創建與現有 LLM 不同,能更真實模擬現實世界的人工智慧系統。世界模型的核心是透過記憶歷史經驗學習世界運作,預測可能發生的事,如從一段物體下落影片,模型可據畫面預測下一幀,學到物體運動的物理規則。圖靈獎得主 Yann LeCun 也提出過類似概念,並批評基於機率產生自回歸的大模型如 GPT 會無法破解幻覺難題。LeCun 和團隊甚至預言,GPT 等模型五年內就會淘汰。

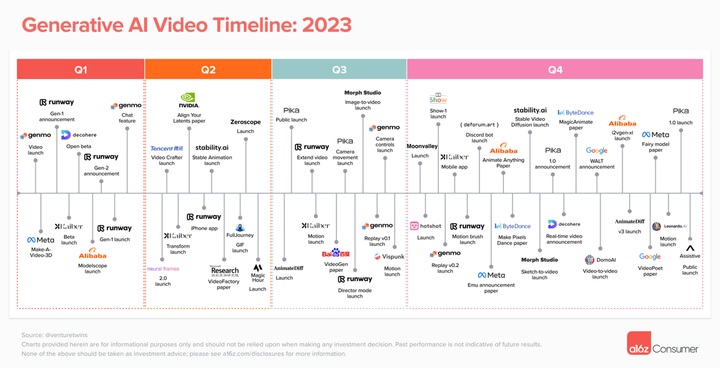

世界模型可看成人工智慧領域,試圖創建更接近人類智慧 AI 的方向。模擬和學習真實世界環境和事件,就有潛力推動 AI 向更高層次模擬和預測發展。2 月知名風險投資公司 a16z 合夥人 Justine Moore 深入分析 AI 影片產生領域的現狀,生成式 AI 逐漸步入大眾視野的兩年間,AI 影片模型百花齊放,百家爭鳴,OpenAI Sora 加入後,更將掀起滔天巨浪,主流平台 Runway、Pika 和 Stable Video Diffusion 等都可能會被波及,獨立創作者遊戲規則會徹底改變,任何人只要有創意和想法,就能用 Sora 產生影片。

創作門檻降低,代表獨立創作者黃金時代即將到來。無論競爭狀態如何,AI 影片產生領域都可能又被新技術和創新顛覆,Sora 只是開始,還不是終點。

(本文由 授權轉載;首圖來源:)

延伸閱讀:

標題:揭密最強影片模型 Sora,OpenAI 如何 1 分鐘一鏡到底?

地址:https://www.utechfun.com/post/333043.html