越來越多的公司正試圖避免自己家的資料被網路爬蟲抓取和保存,以前是像 Google 這樣的大型搜尋引擎爬蟲,現在則是 AI 資料庫的爬蟲。包括彭博、紐約時報等大型媒體,正在阻止 OpenAI 與其他相關 AI 資料庫的網路爬蟲訪問他們的網站,以保護他們的內容不會被用來餵養人工智慧技術的語言模型。

這可能是一場完全不平等的抗爭。

訓練 LLM 用的爬蟲、與搜尋引擎爬蟲的本質是不同的,搜尋引擎的爬蟲本質上會為內容網站帶來流量、雖然在競爭與搜尋引擎的規則下,透過流量獲得收益越來越困難,但這至少還是屬於有互利的模式,不過 OpenAI 爬取網路內容則單純用來訓練並內化為自己的知識,這點讓彼此之間的地位處於完全性不對等。

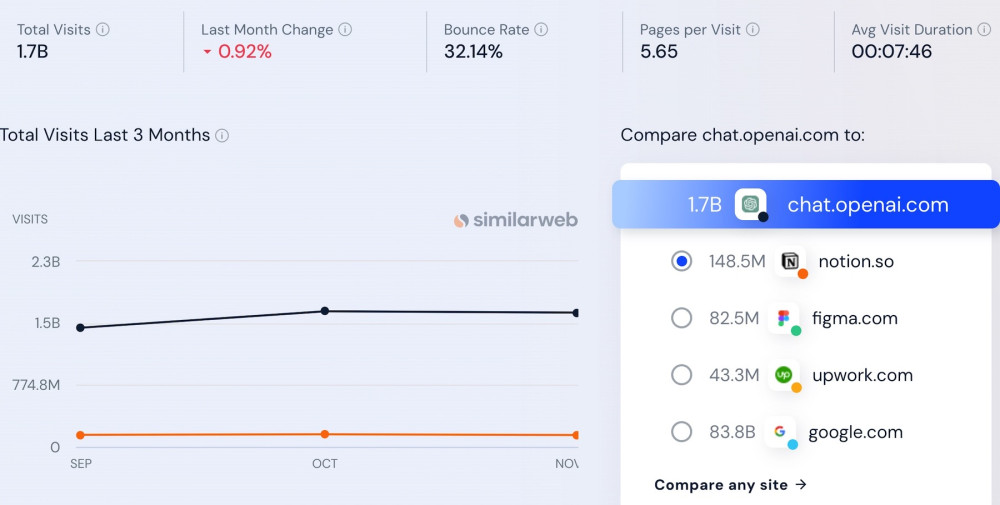

▲ Similarweb 數據,Open AI 網站 10 月達 17 億訪客量,同月亞馬遜訪客量為 24 億。(Source:)

前些時間,OpenAI 公布了自己的網路爬蟲 GPTBot,並聲稱只要你在 robots.txt 註明清楚,就可以阻止 GPTBot 瀏覽網站。這是一個古老的做法,Google 搜尋引擎的爬蟲也遵循類似的原則,網站可以透過 robots.txt 告訴爬蟲忽略他們。包括亞馬遜、Tumblr、Pinterest、Vimeo、People、New Yorker 等,還包括康泰納仕、赫斯特等媒體集團的網站也都採取了這個做法。9 月底 Insider 曾從調研 Originality.ai 再次獲得新的數據。它顯示,在大約三週的時間裡,封鎖 GPTbot 的前 1,000 大網站,從一開始 70 個網站變成 250 多個網站,超過四分之一封鎖了 GPTBot 的瀏覽。

但靠 robots.txt 阻止真的有用嗎?有不少公司透過合作、或是被其他人無斷轉載的模式,導致自己的內容在網路上擴散與傳播,許多人甚至在閱讀的時候不知道這篇文章原始來自於何處,在這種現有的網路發展下,即使自己的網站阻止了 OpenAI 的爬蟲,也不等於能阻止自己的資訊被竊取。

餵養獨特且準確的資訊加上流暢的文筆,對於像 GPT-4 這樣的生成式人工智慧模型的性能至關重要,GPT-4 透過記錄大量文本資料以巧妙地回答用戶問題。這些模型訓練時所用的大部分資訊都是從網際網路上獲取的──儘管其中大部分受版權保護,媒體或出版商對這種做法越來越牴觸、也開始有了幾起類似的訴訟,而也有政府與立法機構開始關注這個問題。

媒體一直難以防止生成式 AI 工具的爬蟲繞過他們的付費牆、並爬取他們的內容來訓練他們的語言模型。盡管內容生產者可以透過 robots.txt 的註記阻止 OpenAI 的爬蟲,但這並不讓人相信足以保護他們的智慧財產權。

媒體的拒絕根本應付接不暇

DIGIday 引述衛報媒體集團的公共政策總監馬特·羅格森的說法,表示這是一個長期問題,沒有短期解決方案。他認為不願讓 AI 爬蟲獲取內容,表明內容營運商正在收回更多控制權,並開始要求對出於不同目爬取網站內容的人進行更多阻擋手段。Google 和 Bing的搜尋結果對媒體至關重要──但這些爬蟲也能用於訓練這些科技公司的LLM和AI聊天機器人。

Google 和微軟的網路爬蟲不但使用在他們的搜尋引擎中,同時也用於訓練他們的 LLM 與機器人,這些爬蟲對於產權內容出現在 Google 和 Bing 的搜尋結果很重要。Google 發表了一個 Google Extended 的新工具,讓網站可以選擇自己要不要被使用於 Google 的 LLM 與 Bard 的資料。微軟則是需要在,讓網站所有者能選擇「只給標題、摘要、網址」或者是「完全不給資料」,如果沒有加上程式碼就代表全部的授權。

另外也有一個台灣比較不熟悉的 CCBot,這是 Common Crawl 用於抓取網頁的網路爬蟲。總部位於歐洲的 Common Crawl 花費多年時間從網路上抓取了大量資料──其中也包括受版權保護的內容,他們專門提供這些資料給大公司的 LLM 訓練(例如 Meta 的 Llama 就有使用這些資料),而根據Originality.ai 的資料,截至 9 月下旬,全球前 1,000 大網站有近 14% 封鎖了 CCBot。

但事實上 CCBot 的活躍時間可能比 ChatGPT 還長,不過封鎖 ChatGPT 的人卻遠比 CCBot 的人還多,一旦越來越多公司開始布局語言模型的資料,要網站一個個自主告知爬蟲不能使用的狀況、就像「你如果不拒絕我,就代表你同意我使用你的版權」,這種完全忽視版權法的概念是可笑的,但目前卻沒有任何方式可以阻止這件事情──即使你靠立法阻止了大公司,你也不能避免躲在暗處偷偷挖取的 AI 爬蟲。

有媒體認為抵抗是杯水車薪

其實媒體也知道網路爬蟲很難全面防堵,所以媒體阻擋網路爬蟲並非單純阻止 LLM 使用他們的資料,而是打算靠防堵爬蟲成為往後與這些大公司談判的籌碼。既然 LLM 需要大量的資料,那往後媒體可以藉由像掛 Google 廣告那樣,藉由這些資料授權獲取費用。像紐約時報現在就更新了自己的網站服務條款,直接說明禁止使用該網站的內容做機械學習或是 AI 的訓練,藉此能在往後採取法律行動。

既然 LLM 往後可能藉由開放 API 獲益,那讓提供資料者分潤似乎也理所當然,但「提供資料」不像是流量那樣有很多資料能佐證,以 AI 資料庫的狀況而言,要舉證他們是否有使用單一媒體的資料就有一定難度。

另一方面,也不是所有的媒體都覺得自己能有足夠的實力與大公司談判,到一位匿名的媒體高層,認為他們公司的規模不足以阻擋 AI 公司的爬蟲行為,他也不確定阻擋爬蟲的行為是否會影響到他們使用 ChatGPT 與其相關的 AI 技術──換句話說,一旦他們對 AI 工具構成依賴,是否會遭到這些大型 AI 公司刻意停權?

雖然看來被「停權」這問題看來有些杞人憂天,但也表達了這些媒體公司在面臨大規模「入侵」時的無力感。就像這些網路公司也開始調整自己的使用者條款,好讓用戶在使用自己的服務所產生的資料也能被用於訓練 LLM,當用戶已經習慣於使用這些服務時,他們也只能被動接受這類條約,並安慰自己,反正自己的隱私與資料不如公眾人物重要。

(首圖來源:)

標題:AI 公司用網路爬蟲挖資料餵養 LLM,使「被挖」媒體醞釀不對等抗爭

地址:https://www.utechfun.com/post/307215.html