隨着AI大模型的興起和各類應用的層出不窮,以GPU爲代表的算力芯片供不應求、交期拉長,英偉達也當仁不讓地被推向了“算力霸主”的王座。今年以來,其股價已上漲160%,市值一度突破萬億美元,相當於四個AMD、七個英特爾。

然而,作爲AI的基礎設施,算力芯片環節的“一家獨大”顯然不是有利於行業長遠發展的生態。因此,市場不免將更多的期待寄托於GPU“二號玩家”AMD身上,而AMD也早早將目標瞄向英偉達的AI王座。AMD究竟有幾分勝算?想窺得這個問題的答案,讓我們將目光移向它的發布會上一探究竟。

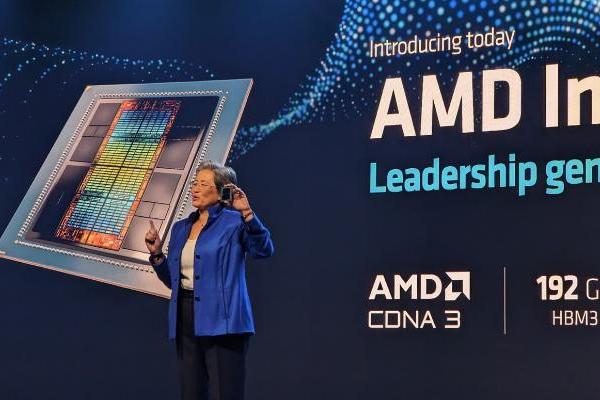

當地時間12月6日消息,AMD在美國聖何塞舉辦的“Advancing AI”活動中宣布,將推出全新的AI芯片系列Instinct MI300,包括MI300A和MI300X等型號,以及相應的軟件和服務。MI300A已經开始量產,而MI300X則已經开始發貨。英偉達在AI這一新興市場的主導地位或將受到嚴重挑战!

MI 300X芯片是適用於各種各樣生成式AI應用場景的芯片;MI 300A則更適用於用在HPC 應用和數據中心上。

在硬件參數配置上,兩顆芯片有共性也有差異。

MI300A 與 MI300X 採用相同的基本設計和方法,兩顆芯片都採用採用了一種名爲“3.5D封裝“的技術來生產,並且也都是基於 AMD第四代的Infinity架構打造。

在內存方面,兩顆芯片都採用了現下大熱的HBM 3設計,但是MI 300A用的是 128GB的 HBM 3設計,MI 300X 用的是內存更大的 192GB HBM 3設計;

在計算單元方面,MI 300X 搭載了304個CDNA 3 計算單元,每個計算單元中還有34個計算單位。而MI 300A的計算單元更少,只有228個。

在發布會上,AMD幾乎全程硬剛英偉達,MI300x 全程“拉踩”H100。

據AMD稱,在最常見的大型語言模型內核的性能方面,MI300X比H100略快。

但是,盡管AMD表示,該芯片爲大型語言模型提供了相同的訓練性能,但與競爭對手相比,其改進的內存能力將節省大量成本。

““這是世界上性能最高的生成式人工智能加速器,”AMD首席執行官蘇姿豐在演講中談到MI300X時說。

Instinct MI300X 基於 CDNA 3 架構,這是 AMD 的第三代 GPU 架構,專爲數據中心的 AI 和 HPC 工作負載而構建。

但是,盡管AMD在MI300A的HPC和AI融合中更加重視工作負載,但該公司認爲MI300X在大型語言模型(如Meta的开源Llama 2系列)上訓練和運行推理方面將具有更大的吸引力。

它配備了 192GB 的 HBM3 高帶寬內存,是 2022 年英偉達 H100 SXM GPU 的 80GB HBM3 容量的 2.4 倍。它也高於英偉達最近宣布的H200的141GB HBM3e容量,後者將於明年第二季度上市。雖然 MI300X 參數上不如英偉達最新產品 H200,但由於 H200 的出貨時間比較晚,因此 MI300X 仍被認爲是對當前算力市場的有力補充。

MI300X 的內存帶寬爲 5.3 TB/s,比 H100 的 3.3 TB/s 容量高出 60%,也比 H100 的 4.8 TB/s 容量高。

但是,雖然 H100 的 SXM 外形尺寸需要 700 瓦的功率,但 MI300X 的要求略高,功率範圍爲 750 瓦。

在HPC性能方面,AMD表示,MI300X可以通過雙精度浮點數學(也稱爲FP64)實現高達163.4 teraflops的矩陣運算。對於 FP64 矢量運算,芯片可以達到 81.7 teraflops。這些數字比 英偉達 的 H100 增加了 2.4。

對於單精度浮點數學(也稱爲 FP32),MI300X 的矩陣和矢量運算都可以達到 163.4 teraflops。據AMD稱,該芯片的矢量性能是H100所能達到的2.4倍。它補充說,H100 無法進行 FP32 張量運算,因此矩陣運算沒有可比性。

至於關鍵的人工智能性能指標,AMD表示,MI300X比H100快30%,用於TensorFloat-32或TF32(653.7 teraflops)、半精度浮點或FP16(1307.4 teraflops)、大腦浮點或BFLOAT16(1307.4 teraflops)、8位浮點或FP8(2614.9 teraflops)和8位整數或INT8(2614.9 teraflops)。

據AMD稱,在最常見的大型語言模型內核的性能方面,MI300X比H100略快。

對於 Meta 的 700 億參數 Llama 2 模型的內核,MI300x 的中型內核快 20%,大內核快 10%。對於 Flash Attention 2,MI300X 在中型內核上快 10%,在大內核上快 20%。

““這意味着內核級別的性能實際上直接轉化爲更快的結果,”蘇姿豐說。

AMD 沒有透露新品的定價,但 CEO 蘇姿豐聲稱比市場上的其它產品有更高的性價比,目前已向衆多 OEM 合作夥伴發貨。

微軟首席技術官 Kevin Scott 作爲發布會的演講嘉賓宣布,MI300X 已經部署到 Azure 當中,Azure ND MI300X 虛擬機現已推出預覽版。 Meta 還宣布將在其數據中心部署 MI300 處理器。另外,惠普、戴爾、聯想等數家數據中心基礎設施提供商,也宣布將計劃在其產品集成MI300。

此前,AMD 預計 AI 芯片將在新財季帶來 4 億美元增收,收入在明年將超過 20 億美元。作爲對比,英偉達的數據中心硬件在最新財季的收入爲 145 億美元,高於去年同期的 38 億美元。

在發布會上,AMD董事長蘇姿豐表示,預計到2027年,用於數據中心的人工智能芯片的整體市場規模將達到4000億美元,年復合增長率將達到 70%。

在AI這一新興領域中,英偉達已佔得先機。而AMD不甘示弱,手握着其“終極武器”,勢必要在算力芯片領域掀起一場“腥風血雨”,究竟能否打敗英偉達,登上AI“王座”?讓我們拭目以待。

- END -標題:AMD英偉達“战火”升級!發布世界最強芯片瞄准英偉達AI“王座”

地址:https://www.utechfun.com/post/301219.html