手工小作坊,終究敵不過工廠流水线。

如果說,當下的生成式AI,是一個正在茁壯成長的孩子,那么源源不斷的數據,就是其喂養其生長的食物。

而數據標注,就是制作這一“食物”的過程。

然而,這一過程真的很卷,很累人。

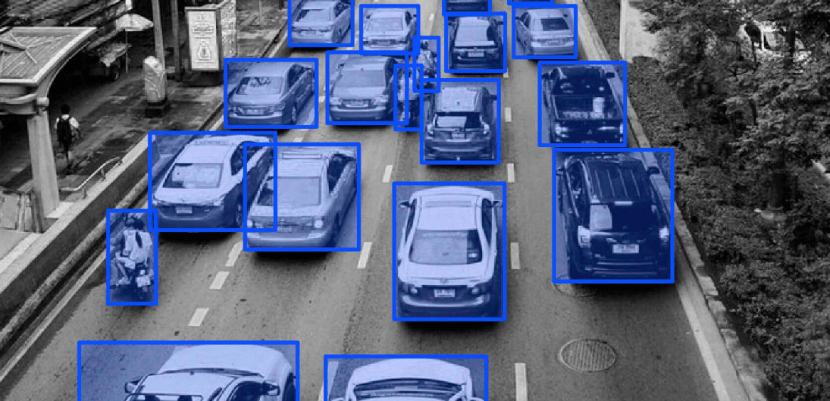

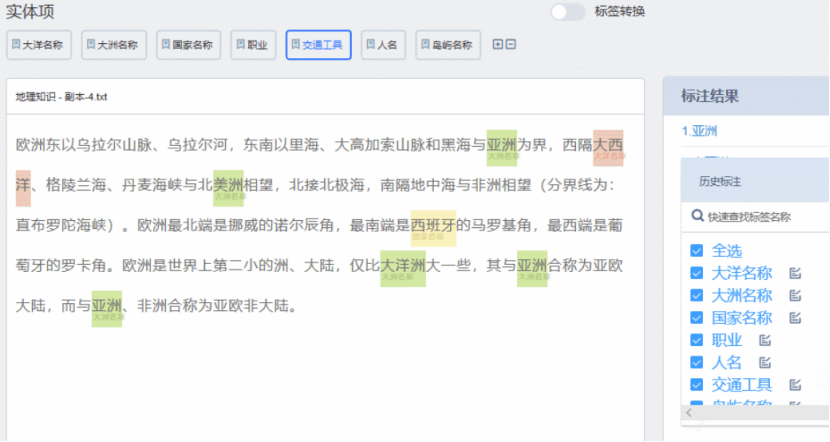

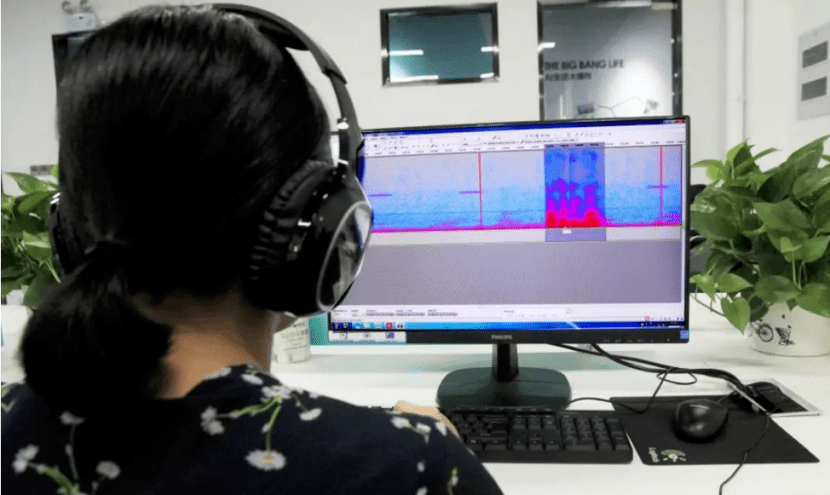

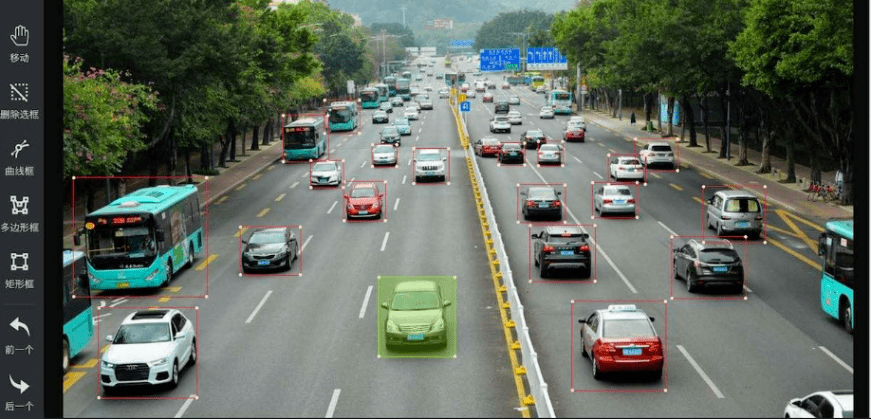

進行標注的“標注師”不僅需要反復地識別出圖像中的各種物體、顏色、形狀等,有時候甚至需要對數據進行清洗和預處理。

隨着AI技術的不斷進步,人工數據標注的局限性也日益顯現。人工數據標注不僅耗時耗力,而且質量有時難以保障。

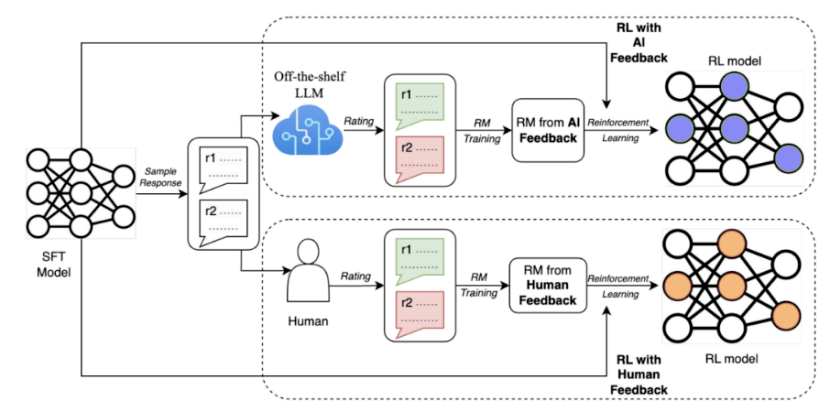

爲了解決這些問題,谷歌最近提出了一種用大模型替代人類進行偏好標注的方法,稱爲AI反饋強化學習(RLAIF)。

研究結果表明,RLAIF可以在不依賴人類標注的情況下,產生與人類反饋強化學習(RLHF)相當的改進效果,兩者的勝率都是50%。同時,RLAIF和RLHF都優於監督微調(SFT)的基线策略。

這些結果表明,RLAIF不需要依賴於人工標注,是RLHF的可行替代方案。

那么,倘若這一技術將來真的推廣、普及,衆多還在靠人工“拉框”的數據標注企業,從此是否就真的要被逼上絕路了?

01 數據標注現狀

如果要簡單地總結目前國內標注行業的現狀,那就是:勞動量大,但效率卻不太高,屬於費力不討好的狀態。

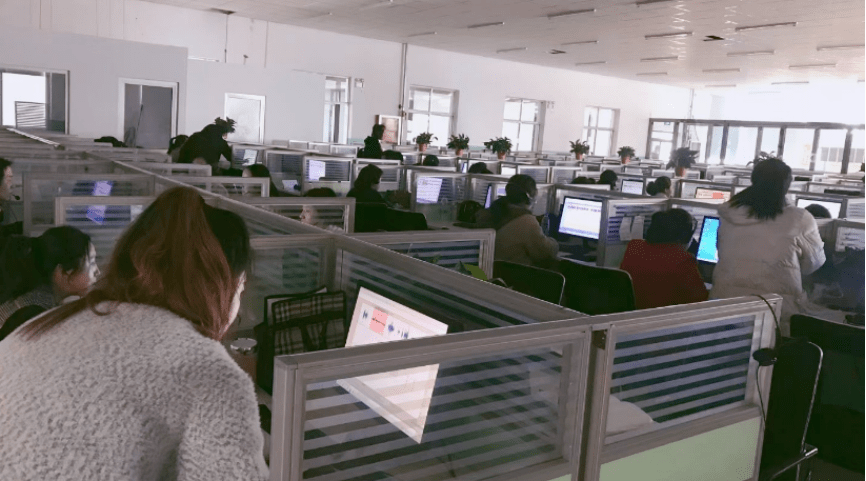

標注企業被稱爲AI領域的數據工廠,通常集中在東南亞、非洲或是中國的河南、山西、山東等人力資源豐富的地區。

爲了控制成本,標注公司的老板們會在縣城裏租一塊場地,擺上電腦,有訂單了就在附近招人兼職來做,沒單子就解散休息。

簡單來說,這個工種有點類似馬路邊上的臨時裝修工。

在工位上,系統會隨機給“標注師”一組數據,一般包含幾個問題和幾個回答。

之後,“標注師”需要先標注出這個問題屬於什么類型,隨後給這些回答分別打分並排序。

此前,人們在談論國產大模型與GPT-4等先進大模型的差距時,總結出了國內數據質量不高的原因。

但數據質量爲何不高?一部分原因,就出在數據標注的“流水线”上。

目前,中文大模型的數據來源是兩類,一類是开源的數據集;一類是通過爬蟲爬來的中文互聯網數據。

中文大模型表現不夠好的主要原因之一就是互聯網數據質量,比如,專業人士在查找資料的時候一般不會用百度。

因此,在面對一些較爲專業、垂直的數據問題,例如醫療、金融等,就要與專業團隊合作。

可這時,問題又來了:對於專業團隊來說,在數據方面不僅回報周期長,而且先行者很有可能會喫虧。

例如,某家標注團隊花了很多錢和時間,做了很多數據,別人可能花很少的錢就可以直接打包买走。

面對這樣的“搭便車困境”,國內大模型紛紛陷入了數據雖多,但質量卻不高的詭異困境。

既然如此,那目前國外一些較爲領先的AI企業,如OpenAI,他們是怎么解決這一問題的?

其實,在數據標注方面,OpenAI也沒有放棄使用廉價的密集勞動來降低成本,

例如,此前就曝出其曾以2美元/小時的價格,僱傭了大量肯尼亞勞工進行有毒信息的標注工作。

但關鍵的區別,就在於如何解決數據質量和標注效率的問題。

具體來說,OpenAI在這方面,與國內企業最大的不同,就在於如何降低人工標注的“主觀性”、“不穩定性”的影響。

02 OpenAI的方式

爲了降低這樣人類標注員的“主觀性”和“不穩定性”,OpenAI大致採用了兩個主要的策略:

1、人工反饋與強化學習相結合;

這裏先說說第一點,在標注方式上,OpenAI的人工反饋,與國內最大的區別,就在於其主要是對智能系統的行爲進行排序或評分,而不是對其輸出進行修改或標注。

智能系統的行爲,是指智能系統在一個復雜的環境中,根據自己的目標和策略,做出一系列的動作或決策。

例如玩一個遊戲、控制一個機器人、與一個人對話等。

智能系統的輸出,則是指在一個簡單的任務中,根據輸入的數據,生成一個結果或回答,例如寫一篇文章、畫一幅畫。

通常來說,智能系統的行爲比輸出更難以用“正確”或“錯誤”來判斷,更需要用偏好或滿意度來評價。

而這種以“偏好”或“滿意度”爲標准的評價體系,由於不需要修改或標注具體的內容,從而減少了人類主觀性、知識水平等因素對數據標注質量以及准確性的影響。

誠然,國內企業在進行標注時,也會使用類似“排序”、“打分”的體系,但由於缺乏OpenAI那樣的“獎勵模型”作爲獎勵函數來優化智能系統的策略,這樣的“排序”和“打分”,本質上仍然是一種對輸出進行修改或標注的方法。

2、多樣化、大規模的數據來源渠道;

國內的數據標注來源主要是第三方標注公司或科技公司自建團隊,這些團隊多爲本科生組成,缺乏足夠的專業性和經驗,難以提供高質量和高效率的反饋。

而相較之下,OpenAI的人工反饋則來自多個渠道和團隊。

OpenAI不僅使用开源數據集和互聯網爬蟲來獲取數據,還與多家數據公司和機構合作,例如Scale AI、Appen、Lionbridge AI等,來獲取更多樣化和高質量的數據。

與國內的同行相比,這些數據公司和機構標注的手段要“自動”和“智能”得多。

例如,Scale AI使用了一種稱爲 Snorkel的技術,它是一種基於弱監督學習的數據標注方法,可以從多個不精確的數據源中生成高質量的標籤。

同時,Snorkel還可以利用規則、模型、知識庫等多種信號來爲數據添加標籤,而不需要人工直接標注每個數據點。這樣可以大大減少人工標注的成本和時間。

在數據標注的成本、周期縮短的情況下,這些具備了競爭優勢的數據公司,再通過選擇高價值、高難度、高門檻的細分領域,如自動駕駛、大語言模型、合成數據等,就可不斷提升自己的核心競爭力和差異化優勢。

如此一來,“先行者會喫虧”的搭便車困境,也被強大的技術和行業壁壘給消弭了。

03 標准化VS小作坊

由此可見,AI自動標注技術,真正淘汰的只是那些還在使用純人工的標注公司。

盡管數據標注聽上去是一個“勞動密集型”產業,但是一旦深入細節,便會發現,追求高質量的數據並不是一件容易的事。

以海外數據標注的獨角獸Scale AI爲代表,Scale AI不僅僅在使用非洲等地的廉價人力資源,同樣還招聘了數十名博士,來應對各行業的專業數據。

數據標注質量,是Scale AI爲OpenAI等大模型企業提供的最大價值。

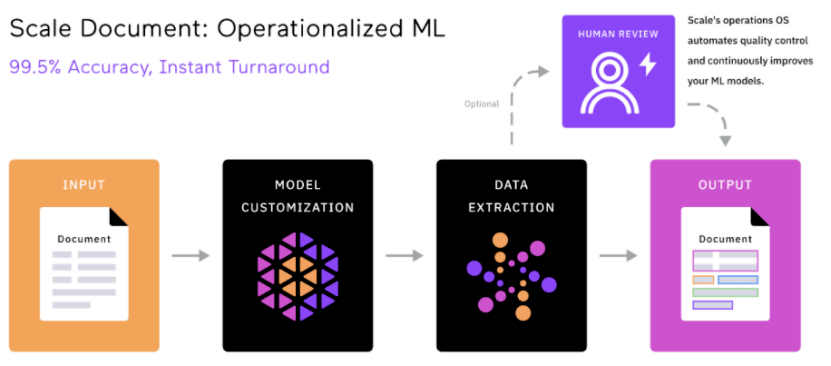

而要想最大程度地保障數據質量,除了前面提到的使用AI輔助標注外,Scale AI的另一大創新,就是了一個統一的數據平台。

這些平台,包括了Scale Audit、Scale Analytics、ScaleData Quality 等。通過這些平台,客戶可以監控和分析標注過程中的各種指標,並對標注數據進行校驗和優化,評估標注的准確性、一致性和完整性。

可以說,這樣標准化、統一化的工具與流程,成爲了區分標注企業中“流水线工廠”和“手工小作坊”的關鍵因素。

在這方面,目前國內大部分的標注企業,都仍在使用“人工審核”的方式來審核數據標注的質量,只有百度等少數巨頭引入了較爲先進的管理和評估工具,如EasyData智能數據服務平台。

如果在關鍵的數據審核方面,沒有專門的工具來監控和分析標注結果和指標,那對數據質量的把關,就仍舊只能淪爲靠“老師傅”眼力見的作坊式水准。

因此,越來越多的國內企業,如百度、龍貓數據等,都开始利用機器學習和人工智能技術,提高數據標注的效率和質量,實現人機協作的模式。

由此可見,AI標注的出現,並不是國內標注企業的末日,而只是一種低效、廉價、缺乏技術含量的勞動密集型標注方式的末日。

原文標題 : 谷歌這一“大招”,要逼死多少AI標注公司?

標題:谷歌這一“大招”,要逼死多少AI標注公司?

地址:https://www.utechfun.com/post/264301.html