作者|孫鵬越

編輯|大?? 風

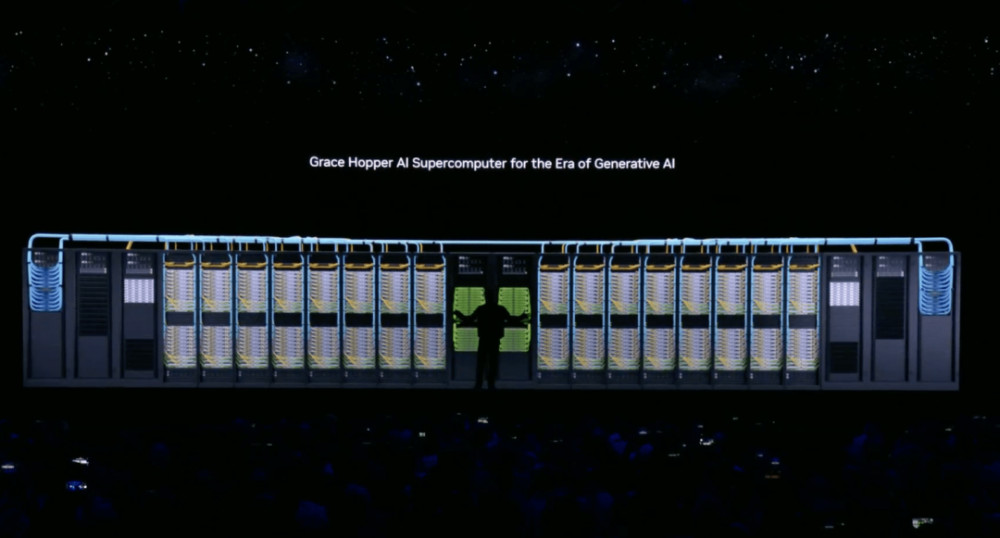

8月8日,全球計算機業內最重要的圓桌會議,世界計算機圖形學會議SIGGRAPH正式召开。 NVIDIA創始人兼CEO黃仁勳出席,並帶來了新一代英偉達超級AI芯片GH200。黃仁勳對自己的新旗艦產品非常有自信,將GH200稱爲“世界上最快的內存”。

在如今的AI市場,英偉達是堪稱“運轉整個AI世界的中心”。

不論是OpenAI還是谷歌、META、百度、騰訊、阿裏巴巴,所有的生成式AI都極度依賴英偉達的AI芯片來訓練。?並且,據媒體報道,英偉達AI芯片H100在2023年8月的市場總需求可能在43.2萬張左右,而目前一張H100芯片在Ebay上的價格甚至炒到了4.5萬美元,折合人民幣超過了30萬元。

?40多萬張芯片缺口,單價4.5萬美元,總價輕輕松松上數百萬美元。?英偉達,正在經歷一場比“挖礦時代”更瘋狂的市場浪潮。?

AI芯片,一張難求?

所謂的AI芯片,其實是圖形處理器(GPU),主要作用是幫助運行訓練和部署人工智能算法所涉及的無數計算。?也就是說,生成式AI的種種智能表現,均來自於無數GPU的堆砌。使用的芯片越多,生成式AI就越智能。

?OpenAI對GPT-4訓練細節守口如瓶,但據媒體猜測,GPT-4至少需要8192張H100芯片,以每小時2美元的價格,在約55天內可以完成預訓練,成本約爲2150萬美元(1.5億人民幣)。

?據微軟高管透露,爲ChatGPT提供算力支持的AI超級計算機,是微軟在2019年投資10億美元建造一台大型頂尖超級計算機,配備了數萬個英偉達A100 GPU,還配備了60多個數據中心總共部署了幾十萬個英偉達GPU輔助。?

ChatGPT所需要的AI芯片並不是固定的,而是逐次遞增。ChatGPT越聰明,背後的代價是所需算力越來越多。據摩根士丹利預測,到了GPT-5大概需要使用2.5萬個GPU,約是GPT-4的三倍之多。?

如果想滿足OpenAI、谷歌等一系列AI產品的需求,那么就相當於英偉達一家公司爲全世界的AI產品供芯,這對於英偉達的產能是個極大的考驗。?

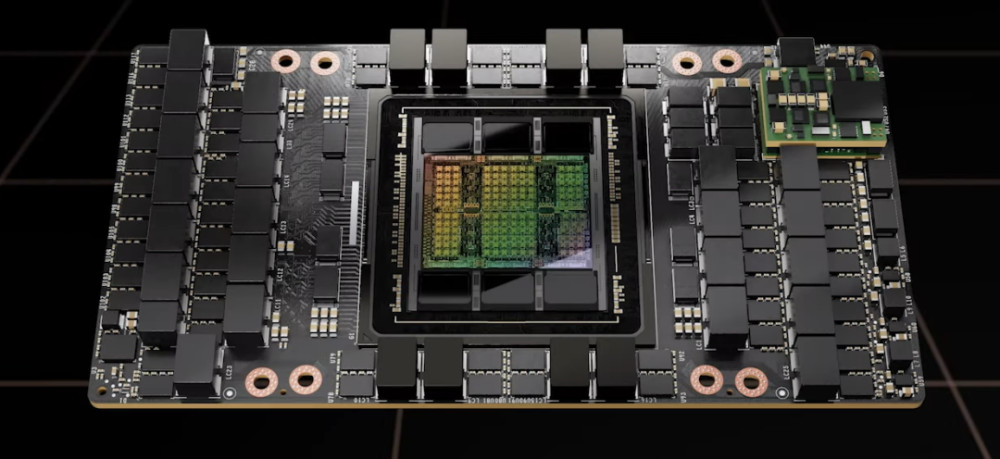

英偉達H100

?雖然英偉達正在开足馬力生產AI芯片,但據媒體報道,小型和大型雲提供商的大規模H100集群容量即將耗盡,H100的“嚴重缺貨問題”至少會持續到2024年底。

?目前,英偉達作用於AI市場的芯片主要分爲H100和A100兩種,H100是旗艦款產品,從技術細節來說,H100比A100在16位推理速度大約快3.5倍,16位訓練速度大約快2.3倍。?

不論是H100還是A100,全部都是由台積電合作生產,就使得H100的生產受到了限制。有媒體稱,每一張H100從生產到出廠大約需要半年的時間,生產效率非常的緩慢。?

英偉達曾表示它們在2023年下半年,提高對AI芯片的供應能力,但沒有提供任何定量的信息。?不少公司和求購者都在呼籲,要求英偉達加大對晶圓廠的生產數量,不只和台積電合作,而是把更多的訂單交給三星和英特爾。?

更快的訓練速度?如果沒辦法提高產能,那么最好的解決辦法就是推出性能更高的芯片,以質取勝。?

於是乎,英偉達开始頻頻推出新款GPU用來提升AI訓練能力。

先是在今年3月,英偉達發布了H100 NVL GPU、L4 Tensor Core GPU、L40 GPU、NVIDIA Grace Hopper四款AI芯片,以滿足生成式AI們日益增長的算力需求。?在上一代還未量產上市,英偉達又在8月8日世界計算機圖形學會議SIGGRAPH上,由黃仁勳發布了H100的升級版,GH200。

?據了解,全新GH200 Grace Hopper Superchip基於72核Grace CPU,配備480GB ECC LPDDR5X內存以及GH100計算GPU,搭配141GB HBM3E內存,採用6個24GB堆棧,使用6144位存儲器接口。?

英偉達GH200?GH200最大的黑科技,就是作爲世界上第一款配備HBM3e內存的芯片,能夠將其本地GPU內存增加50%。而這也是專門對人工智能市場做的“特定升級”,因爲頂級生成式AI往往尺寸巨大卻內存容量有限。?

據公开資料顯示,HBM3e內存是SK海力士的第五代高帶寬內存,是一種新型的高帶寬內存技術,可以在更小的空間內提供更高的數據傳輸速率。

它的容量爲141GB,帶寬爲每秒5TB,能分別達到H100的1.7倍和1.55倍。?從7月份發布以來,SK海力士就成爲GPU市場的寵兒,領先於直接競爭對手英特爾Optane DC和三星的Z-NAND閃存芯片。

?值得一提的是,SK海力士一直以來都是英偉達的合作夥伴之一,從HBM3內存开始,英偉達絕大部分產品都是採用SK海力士的產品。但SK海力士對於AI芯片所需要的內存一直產能堪憂,英偉達不止一次的要求SK海力士提高產能。

?一個難產大戶遇上另一個難產大戶,不由讓人擔心GH200的產能。?NVIDIA官方表示,GH200與當前一代產品H100相比,內存容量高出3.5倍,帶寬高出3倍;並且,HBM3e內存將使下一代GH200運行AI模型的速度比當前模型快3.5倍。

?比H100運行AI模型的速度快3.5倍,是否意味着,1張GH200就能相當於3.5張H100?一切都還得實踐操作才能得知。?但目前來說,可以肯定的一點就是,作爲AI市場的最大供應商,英偉達進一步鞏固了自己領先位置,並和AMD和英特爾拉大了差距。?

英偉達的對手們?

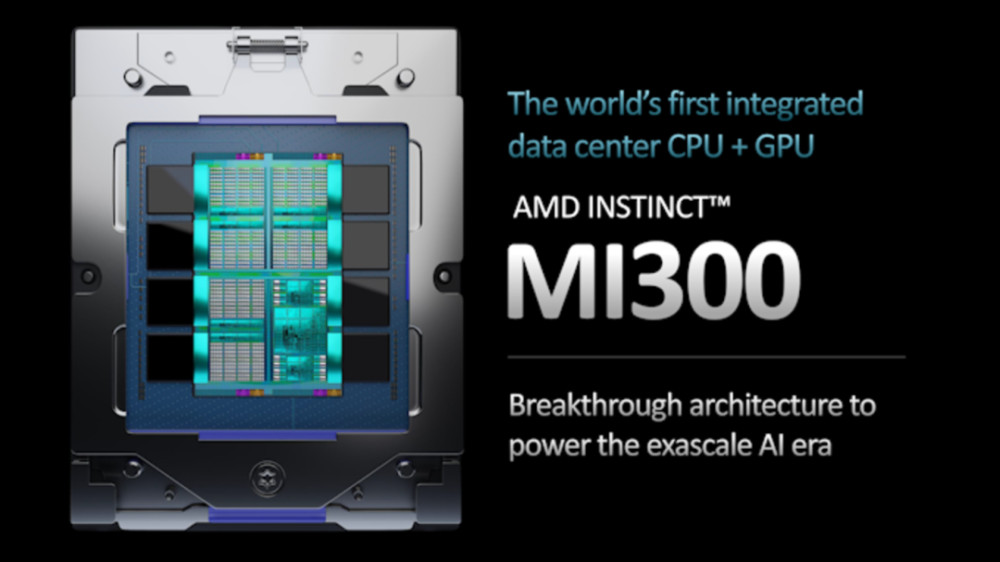

面對43萬張AI芯片缺口,沒有一家公司不動心。尤其是英偉達的最大競爭對手AMD和英特爾,不會放任其一個人獨吞整個市場。?今年6月14日,AMD董事會主席、CEO蘇姿豐密集地發布了多款AI軟硬件新品,包括針對大語言模型設計的AI芯片,MI300X。

正式拉开在AI市場,對英偉達的正面挑战。?在硬件參數上,AMD MI300X擁有多達13顆小芯片,總共包含1460億個晶體管,配置128GB的HBM3內存。

其HBM密度爲英偉達H100的2.4倍,帶寬爲英偉達H100的1.6倍,意味着可加快生成式AI的處理速度。?但可惜的是,這款旗艦AI芯片並沒有現貨,只是預計將於2023年Q4季度全面量產。?

而另一競爭對手英特爾,則在2019年就以約20億美元的價格收購了人工智能芯片制造商HABANA實驗室,進軍AI芯片市場。?

今年8月,在英特爾最近的財報電話會議上,英特爾首席執行官Pat Gelsinger表示,英特爾正在研發下一代Falcon Shores AI超算芯片,暫定名爲Falcon Shores 2,該芯片預計將於2026年發布。?

除了Falcon Shores 2之外,英特爾還推出AI芯片Gaudi2,已經开始銷售,而Gaudi3則正在开發中。?只是可惜的是,Gaudi2芯片規格並不高,難以實現對英偉達H100和A100發起挑战。?

AMD MI300X?除了國外半導體巨頭們大秀肌肉,开始了“芯片競爭”之外,國內的半導體公司也开始了對AI芯片的研發。

?其中,昆侖芯AI加速卡RG800、天數智芯的天垓100加速卡、燧原科技第二代訓練產品雲燧T20/T21,均表示能夠具有支持大模型訓練的能力。?

在這場以算力爲標准,以AI大模型爲战場的芯片之爭,英偉達作爲AI市場的最大贏家之一,已經在芯片設計和市場佔比等方面展示出它的強大。?但國產AI芯片雖然稍稍落後,但研發和擴展市場的腳步從未停止,未來值得期待。

原文標題 : AI缺芯,英偉達賣斷貨

標題:AI缺芯,英偉達賣斷貨!

地址:https://www.utechfun.com/post/248265.html