文 | 郝鑫、黃小藝

從去年底到現在,國內外肉眼可見地湧現出了一批文生圖公司,這背後與基礎架構开源有很大關系。

2022年8月,Stability.AI在GitHub上公开开源了Stable Diffusion模型的代碼和訓練數據集;當月底,基於Stable Diffusion的圖像生成工具Stable Diffusion web UI也正式开源發布。

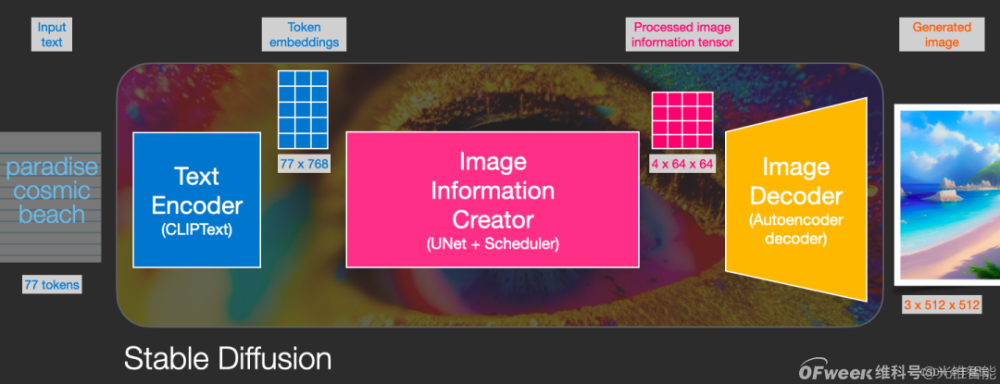

(Stable Diffusion模型基本架構 圖源:網絡)

自此,以“Stable Diffusion”命名的“擴散模型”響徹了整個AIGC,在落地中形成了由文字編碼器(Text Encoder)、圖像信息生成器(Image Information Creator)和圖像解碼器(Image Decoder)組成的擴散模型架構,技術的核心是在去噪的過程中逐漸還原出圖片。

(去噪過程演示 圖源:網絡)

开源的春風吹到了國內,也給了正在獨自摸黑探索的中國文生圖公司送去了光明。

“开源了,我們既興奮,但又更迷茫了。”

技術方向更加明確了,訓練路徑也更加清晰,中國文生圖公司又面臨着一個新問題:要不要全面擁抱开源模型?

對於這個問題,網易伏羲和趙增團隊也曾反復思考。

趙增的答案是,只能借鑑,不能全盤照抄。“模型訓練不能开黑盒,只要做不到完全透明、可控,就存在風險。”

基於這個邏輯,網易伏羲走上了中國式文生圖的道路,其基本模型架構爲“自研+开源”相結合,平台做到了全中文輸入、理解。

之前大模型因爲不理解中文“鬧了不少笑話”,而網易伏羲從模型訓練开始便意識到了這個問題,在思考如何把文生圖用得更好方面更快人一步。

如今,文生圖邁入了更高效、更穩定、更自由可控的裏程碑階段,也衍生出圖生圖、圖生3D、多圖生視頻等技術路徑。

在圍觀了國外文生圖應用的熱鬧景象之後,網易伏羲也走向了更深的自我思考和升級。

近期2023世界人工智能大會上,光錐智能對話網易伏羲預訓練及生成式人工智能平台負責人趙增,聊一聊他對於爆火的文生圖現象和背後技術的理解。

核心觀點如下:

1、文生圖的模型參數不是越大,效果就越好。

2、技術是標准化的,但審美是非標准化的,要想提升生成的美術效果,需要有美術專家介入,提供反饋。文生圖的模型上限在專家,下限在技術。

3、借鑑國外开源模型固然可以提升生成技術,但一味地擁抱开源並不可取,其中存在許多可控性、安全問題,還是要構建自主的生成模型。

?4、總體來看,文生圖應用還處於探索時期,沒有進入工業化落地階段。

(網易伏羲預訓練及生成式人工智能平台負責人趙增)

以下爲對話實錄:

光錐智能:網易伏羲生成平台的探索過程是怎樣的?近期有哪些新的進展?

趙增:2018年开始,網易伏羲就开始嘗試用GPT去做模型應用適配。但隨着OpenAI公司逐漸關閉對國內的技術訪問路口,2020年,我們开始自己組織團隊,以文本預訓練爲切入點去訓練模型。

2021年之後,結合網易自身業務需求和互聯網發展歷程,我們判斷多模態將是未來發展趨勢,因而开始大力做多模態理解和生成。去年Stable Diffusion开源後,开始將自身的模型訓練路线與开源架構相融合。

今年年初,文生圖再次被推到風口,开源生態也異常活躍,在此背景下,我們對技術架構路徑再次做了調整:一方面,持續優化自身的中文生成模型,希望其能在中文領域達到頂尖的效果;另一方面,去做更加友好开放的生產管线,將具有AI技術的人和專業藝術家都納入生態系統。

最近我們內部也正在做預研2.0,在能力得到充分驗證以後,也會更多地對外开放,融合到業務場景中、伏羲有靈美術平台中。

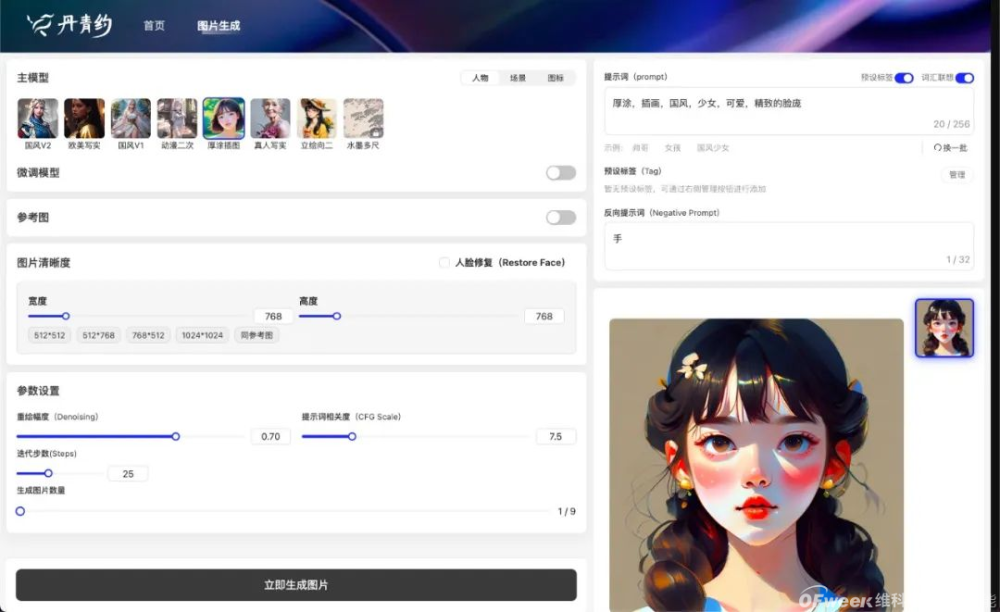

(AIGC繪畫平台)

光錐智能:網易伏羲文生圖大模型的參數是多少?

趙增:現在方案有很多套,有十幾億、三十幾億,也有幾百億的參數方案。一個很有趣的現象是,即使Stable Diffusion已經开源了多個版本,但現在最流行的還是早期的1.5版本,這就代表不是參數越大,效果就越好。我們的理念也是一樣,會先嘗試把數據變得越來越大,模型訓練得越來越大,但也還會根據實際情況選擇合適的尺寸去生成。

光錐智能:網易伏羲支持全中文操作,對比一些英中轉換的模型,建立一個全新的中文語料庫的難點在哪裏?

趙增:最大的難點在於整個前期投入,就是要去系統性地構建高質量的中文數據集,然後喂給基礎模型,從頭去構建,不斷地迭代,所以整個周期就會很長。我們的優勢在於,起步比較早,在Stable Diffusion還沒开源之前,我們就已經在不斷地投入,到現在已經產生了很多積累。

光錐智能:如何在技術層面提升語義指導的精准程度,提升文生圖的效果?

趙增:萬變不離其宗。第一,在數據層面,要構建更符合用戶輸入內容的數據分布。在大模型背後的系統組件支持下,把這些數據更有效地串聯和優化;

第二,在模型結構層面。我們在中文場景下做了很多調整,去嘗試有效的結構,包括規模嘗試。整體來講,我們的模型結構跟开源模型結構不是完全一樣的,無論是圖片還是文本,都做了優化;

第三,是數據反饋。要獲得有價值的評價,把幹擾生成過程中的數據剔除掉,形成正向反饋機制,才能在訓練過程中不斷提高生成能力。

(AIGC生成的古風人物形象)

光錐智能:技術是標准化的,可是審美是非標准化的。網易伏羲在做文生圖的時候,是怎樣標准化生成結果?優化生成效果的呢?

趙增:反饋是很重要的,網易有非常多的頂尖的藝術家,他們會在使用過程中提供很多專業意見,幫助我們找到需要優化的點。我們也會把當前的版本發到伏羲有靈衆包平台上,來獲取用戶匿名反饋。

舉個例子,之前3月的時候,我們做了一款二次元模型,初步覺得效果不錯,但美術專家一看,就說頭身比不行、姿勢不行,在他們的反饋之下,我們從模型數據層面做了重構,才調整過來。

這也給我們一個啓示,從系統的層面我們只能去增加量,但是想要做頂尖的內容生成,就要有頂尖的審美,需要跟行業有深度的合作。我們和美工在內部分工很明確,模型的上限在他們,下限可能在我們技術上。

(AIGC生成的二次元形象)

光錐智能:除了審美,專家的介入還會提帶來哪些反饋優化,可以舉個例子嗎?

趙增:主要基於他們的生產過程。

比如說處理圖的時候,他們需要什么樣的風格。如果是通用風格,例如二次元,我們就會把它做成基礎模型;但是如果特別小衆,例如厚塗,就做成二級模型,去开放自主仿真的能力,讓專家自己去定制模型。

而在圖生成以後,他們可能需要能在PS裏自動分層的圖片。還有,對於具體內容的理解,例如,專家們需要榫卯結構、中國古代盔甲......這就需要我們不斷去構建相應的數據,根據已有範式,補充相應的內容。

光錐智能:網易伏羲有沒有針對用戶展开具體的用戶畫像分析,比如專業的、業余的等等。

趙增:目前,是希望服務專業生產。因爲這部分用戶離我們最近,我們最能知道他們想要什么,也能很明確的算出來,等到他們真正用起來以後,我們才能產生巨大的收益。

光錐智能:如何看待使用國外开源模型的問題?

趙增:我們內部對要不要直接擁抱开源的這個問題,做了很多次討論,最後的答案是明確的:要構建自己的生成模型。

直接使用國外开源模型,存在幾個非常大問題,首先是對生產能力可控性的把握。以文生圖爲例,從特徵提取到真正拿來用,這中間還有很多環節,模型要怎樣去理解一些非常領域化和中國化的內容變得很關鍵,如果直接調用國外模型肯定會出現水土不服。

另外,在跟進國外开源生態的過程中,我們發現,一些生成效果比較好的模型,背後其實是龐大數據在支持,如果技術不加以控制,就可能出現失控。其次是數據合規性問題。雖然技術沒有國界,但事實證明現在生成的內容的確是有偏見的,我們需要保證最後生成的內容要符合實際生產需求。

總而言之,我們的目標是去構建更有中國特色的生成模型,對於這個生成模型,我們希望從底子上它就是可控的,所有構建過程都是白盒狀態,模型、數據、工程框架優化、迭代演進等都是清晰透明化的,而不是只知道一個模型的版本號,开源後拿過來改改再用。

光錐智能:國外已經出現了幾款爆款軟件,進入大規模應用階段。但目前在國內,這樣的感知似乎不是很強烈。以您的觀察來看,國內文生圖應用發展到了什么階段?

趙增:其實,無論國內外,我們認爲現在文生圖的應用基本都還處於探索階段。因爲以我們的標准來看,只有出現像Photoshop這樣現象級的產品,能實現爲整個行業去服務、產生巨大收益的時候,才算是進入一個工業化落地的階段。

目前,短暫的體驗型產品還遠遠不夠。從純圖文層面來講,現在的工具功能都是碎片化的,沒有一個能夠解決全流程的問題,我們的用戶需要不斷地在各個AI生產工具中切換,因此他們的支付意愿不高,對單個產品的依賴度也很低。

不過,雖然現在生產規模還在起點階段,但各種從業人員包括高層都看到了圖文的價值,還需要時間去探索如何規模化。

光錐智能:國外公司從文生圖轉向了文生視頻,在文生視頻方面,網易伏羲有做嘗試探索嗎?

?趙增:文生視頻我覺得是一個非常有價值的場景,但是從落地的角度來講,還是需要持續投入,它的成熟度會比文本、圖文更滯後一些。從技術難點看,它的數據量可能更大,需要處理前後幀的相關性。

原文標題 : 對話網易伏羲趙增:开源VS自研?哪條路是通向AIGC的捷徑?|WAIC2023

標題:對話網易伏羲趙增:开源VS自研?哪條路是通向AIGC的捷徑?|WAIC2023

地址:https://www.utechfun.com/post/239470.html