為解決高速運算,記憶體傳輸速率受限於 DDR SDRAM 頻寬無法同步成長的問題,高頻寬記憶體(High Bandwidth Memory,HBM)應運而生,革命性傳輸效率是讓核心運算元件充分發揮效能的關鍵。TrendForce 研究顯示,高階 AI 伺服器 GPU 搭載 HBM 已成主流,2023 年全球 HBM 需求量年增近六成,到 2.9 億 GB,2024 年再成長三成。

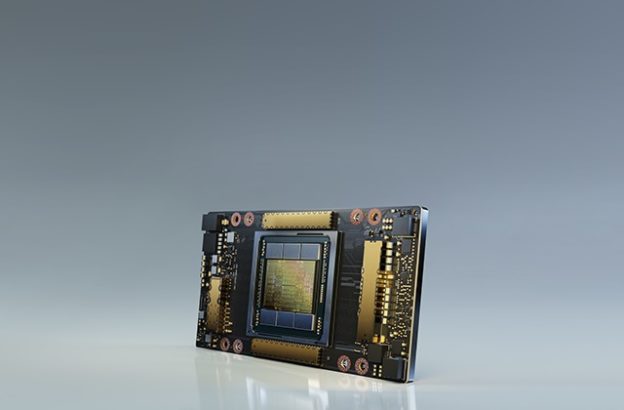

TrendForce預估到2025年,全球若以等同ChatGPT的超大型AIGC產品五款、Midjourney中型AIGC產品有25款,以及80款小型AIGC產品估算,所需運算資源至少145,600~233,700顆NVIDIA A100 GPU,加上新興應用如超級電腦、8K影音串流、AR / VR等,也同步提高雲端運算系統負載,顯示高速運算需求高漲。

由於HBM擁有比DDR SDRAM更高頻寬和較低耗能,無疑是建構高速運算平台的最佳解決方案,2014與2020年發表的DDR4 SDRAM及DDR5 SDRAM便可究其原因,兩者頻寬僅相差兩倍,且不論DDR5或將來DDR6,追求更高傳輸效能同時, 耗電量也同步攀升,勢必拖累運算系統效能表現。若進一步以HBM3與DDR5為例,前者頻寬是後者15倍,且能透過增加堆疊顆粒數量提升總頻寬。HBM可取代部分GDDR SDRAM或DDR SDRAM,更有效控制耗能。

TrendForce表示,主要由搭載NVIDIA A100、H100、AMD MI300及大型CSP業者如Google、AWS等自研ASIC的AI伺服器成長需求較強勁,今年AI伺服器出貨量(含搭載GPU、FPGA、ASIC等)出貨量預估近120萬台,年增率近38%,AI晶片出貨量同步看漲,可望成長突破五成。

(首圖來源:)

標題:AI 及 HPC 需求帶動,今年 HBM 需求容量達近 60%

地址:https://www.utechfun.com/post/231088.html