氣溫上升,還有什么能比“工作沒了”,更能讓人一瞬間心裏拔涼拔涼的呢?

這個“薪盡自然涼”的故事,就發生在數據中心。

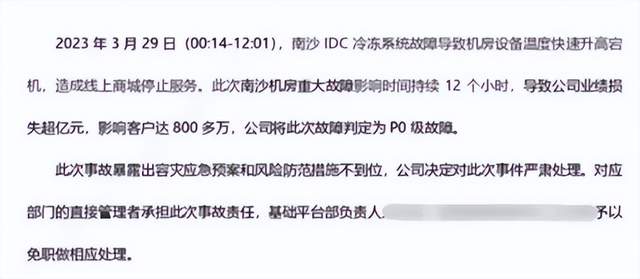

前不久,某電商平台正在購物高峰期,結果IDC冷凍系統故障,機房設備溫度快速升高,直接宕機了12個小時,據說損失高達一億以上。

業務涼了,該企業的基礎平台部負責人的職業生涯也涼了。當然,受傷的不止一個人,因爲這次機房事故影響的還有微信、QQ等軟件,騰訊內部的幾個高管也遭到了降級、免職的處罰。

(事故公告)

AI熱度狂飆,數字經濟加速,作爲計算的心髒最該保持涼爽的數據中心,也越來越難以冷靜,所以液冷也成了除AI之外,計算廠商“群起而攻之”的概念,也是IT人不得不關注的技術。

2022年被認爲是數據中心的“液冷元年”。

因爲客戶多了,雙碳战略和東數西算的政策持續牽引,液冷從少數互聯網巨頭、公有雲廠商、智算中心、HPC高性能計算中心等的選擇,开始引發更多大衆行業和企業的關注。

有需求就有供給,廠商動作也明顯多了。衆多服務器廠商、雲計算和互聯網企業爭先研發數據中心液冷技術,甚至有廠商喊出了 “All in 液冷 ”的口號,許多新的液冷產品和解決方案被推向市場。

資本市場也愿意爲液冷概念买單,今年以來,中科曙光、申菱環境、網宿科技、英維克等相關企業都出現過大漲。

多股力量之下,液冷的熱度很難不高。

不過,數據中心的冷卻技術發展了很多年,液冷對於數據中心來說並非新鮮事物,降本降PUE需求也不是一年兩年了,爲什么AI一來液冷就突然成了風口?這個熱度是真實的嗎?

這個炙熱的夏天,我們不妨通過液冷的故事,來清涼一下。

時也:真的假的 “元年”?

元年,是個被用濫了的詞,我們聽過太多野心家嘴裏的“元年”了。2014“智能家居元年”,买回家的藍牙聯網電器再也沒有更新過;2015“VR元年”,沒兩年行業就驟然降溫;2021“元宇宙元年”,一時沸騰,很快就被大家忘在腦後了……

數據中心的“液冷元年”,會不會也是曇花一現的概念炒作和噱頭呢?

我們也可以換個角度,來看看那些公認靠譜的“元年”,液冷是不是有雷同的要素加持?

2019被稱爲5G商業應用元年,大量5G商用牌照發放,進入明顯的加速進程——這是政策的強力牽引。

再看液冷,數據中心是能源密集型的,隨着雙碳政策的推進,數字經濟加速,工信部提出,2022年全國新建大型數據中心PUE要達到1.4以下;“東數西算”文件進一步要求,東部地區集群數據中心的PUE要控制在1.25以內,西部地區在1.2以內。在此背景下,數據中心“節能減排”已經勢在必行,風冷技術進步已經放緩,液冷开始得到重視,合理。

2022,被稱爲AIGC元年,AI作畫爆火,能力开始爲全球用戶所接受,歲末年初的大語言模型又添一把火,AIGC進入產業化應用已成必然——這是技術的成果扎實。

目前,風冷在數據中心中仍佔主導地位,液冷尚未得到更廣泛的採用,但主流服務器制造商都在 2022 年陸續开始建設標准化規模生產冷板液冷服務器的產线,幾乎所有的頭部互聯網公司都已對液冷技術密切跟蹤。技術夯實,成本隨產業化、標准化、規模化而大幅下降,液冷开始滲透,有戲。

往遠一點,1956年被稱爲“人工智能元年”,是因爲麥卡錫、閔斯基、香農等知名學者匯聚在達特茅斯會議,群星璀璨——這是高屋建瓴的洞察。

新一輪AI革命已經“做實”,當前 AI 正處於史上最長繁榮大周期,而AI計算等高性能應用的芯片架構,熱功率密度急劇上升,CPU已從每個芯片的150瓦增加到300瓦以上,圖形處理單元(GPU)已增加到每個芯片700瓦以上。功率越大,芯片就越熱,冷卻要求也就越高。這些高功率 CPU 和 GPU 被封裝到服務器中,每個機架產生的熱量就更多了。越來越多計算專家、科學家認同數據中心要供給高效綠色低碳的算力,Azure的首席架構師Marcus Fontoura指出,5到10年內,液冷的數據中心將成爲主流,而不僅僅在超算和比特幣挖礦領域。液冷+DC的長期前景,看好。

從這個幾個判斷依據來看,“液冷”和數字經濟之間的聯系密切,成爲這一年來數據中心行業的關鍵詞,“元年”這個詞不是行業炒作的噱頭,是有真材實料的支撐。

命也:打鐵還需自身硬

或許有人會說:到底還是政策導向,雙碳降PUE的需求,只要機房裏空調夠給力,增加的熱氣一樣會被冷卻,IT設備照樣好好地很可靠。

確實,只要服務器入口能保持在17-27攝氏度(64.4° F 和 80.6° F )之間,那管你什么冷卻技術,能抓住老鼠的都是好貓,能降溫就行。液冷能被選中,還是在於自身的技術先進性。

傳統冷卻方式,氣流對流冷卻,可以簡單統稱爲“風冷”。因爲都是通過冷空氣與服務器的發熱元器件(CPU、圖像處理器、存儲等)進行熱交換,來達到制冷的效果,通常會有機房空調(CRAC)或機房空氣處理器(CRAH)單元,就類似於大家在家裏吹空調,大熱天裏涼風習習,想想就美滋滋。所以,數據中心有80-90%都是風冷。

(架空地板將冷空氣送入設備入口)

吹空調已經很爽了,爲什么還要衝“冷水澡”?

液體冷卻,就是通過液體冷媒,將發熱源的熱量傳遞到遠處,再進行冷卻。

這就是液冷技術的“天生命好”——技術更先進。

液體冷媒比空氣的比熱容大,所以液冷的制冷效率和散熱速度,遠遠高於風冷。相當於室溫太高,空調得吹個十幾分鐘才舒適,而衝涼水一下子就能從頭涼到腳,哪台高速運轉的服務器能拒絕這種快樂呢?達到同樣的冷卻效果,液冷的電源消耗更小,PUE(電源使用效率)也更低,很多浸沒式液冷數據中心的PUE值甚至可以達到1.03~1.05,IT打工人降PUE的績效穩了。

液冷元件比風扇的聲音小,所以整個液冷系統的噪聲,也比風冷CRAH單元小,基本可以達到“靜音”效果。想象一下,如果沒有單獨的機房,又要在辦公室裏放一台服務器,誰坐在嗡嗡嗡的機器旁邊還能安心辦公啊,所以哪怕稍微貴一點,也愿意選液冷。

液冷系統比空氣更可控。風冷“看天喫飯”,外部氣溫變化都可能影響到制冷效果,導致意想不到的故障,液冷就可控多了,只要冷媒不斷不漏,能持續穩定地發揮冷卻作用。這意味着,像新聞裏那樣因爲設備過熱中斷宕機而丟工作的IT倒黴蛋,會少很多。

空調可樂冰西瓜,是普通人眼裏美妙的夏天,而緊緊巴巴擠在機櫃服務器的處理器們,“衝涼”才是最愜意的享受。

運也:液冷來到臨界點Tipping Point

既然液冷這么好用,爲什么風冷還是數據中心的主流,爲什么微軟還要把數據中心搬去海底,爲什么谷歌不早點向液冷轉型?

答案就是,液冷技術剛剛才來到“臨界點Tipping Point”。

液冷在數據中心的應用並非新鮮事物,已經存在了一段時間。上世紀60年代,IBM大型主機就通過液冷來解決固態設備的散熱難題。發展到本世紀,浸沒式液冷也應用在超算、高性能計算場景中,是當之無愧的黑科技。

而普通的數據中心機房,开始趨勢性地採用液冷,是近兩年才开始到達“臨界點”。

所謂“Tipping Point”,也被翻譯成轉折點、引爆點,指的是某個事物發展到一定程度,會產生重大且通常不可阻擋的變化,向野火一樣蔓延的神奇時刻。

根據格拉德威爾的說法,臨界點到來的一個重要因素是“粘性”,即一個事物是不是能夠“粘”在公衆的腦海中,並影響他們的決策行爲。

而我們觀察到,近年來液冷行業的一些變化:

首先,產業需求的粘性很強。

以往液冷技術主要應用於高性能計算領域,數據中心又是一個較爲傳統的行業,液冷的部署環境與傳統的機房有較大的差異,改造成本是很高的——除非它值得。

而AI和數字化的普及,讓液冷的需求粘性變得跟502一樣黏着。

以谷歌爲例,一开始並不愿意採用液冷方案。谷歌數據中心副總裁卡瓦曾說:“想象一下,有一排又一排,一排又一排的機架,裝滿了我們的服務器。我們的硬件運營團隊每天都在那裏,升級、維修、部署......如果所有這些服務器浸泡在數十萬加侖的礦物油中,日常操作將變得更加復雜。”

他本人承認,“液冷是非常好的東西,但對於谷歌的大規模部署,卻不是必需的”。結果我們都知道,谷歌變了,2018年开始向液冷轉型,原因是AI。自從谷歌的AI芯片TPU問世之後,它的並行計算能力強大,也十分耗電,以至於到了TPU 3.0,傳統的空氣冷卻完全不行了。所以,自從 TPU 3.0 在內部推出以來,谷歌數據中心的工程師就急忙改造基礎設施以適應芯片級液冷,即使這樣會增加成本。

AI所帶來的先進生產力和競爭力,讓風冷轉液冷的麻煩和投入,變得非常值得。

其次,技術的粘性在變強。

每一種新興技術的規模應用,都需要經過長期的實驗和迭代,來保證技術的實用性、穩定性。

近年來我們看到,液冷的技術也有了非常大的飛躍,使其能夠走向產業化應用。

技術變化一,芯片級冷卻的突破。

芯片級冷卻,可以直接對發熱量較大的CPU、GPU,進行針對性地冷卻,這樣制冷更精確,冷卻效果當然也就更出色,可以支持更強大的芯片。而做到芯片冷卻,是非常考驗設計能力和制造工藝的。目前這方面已經有非常多的產品問世,比如阿裏雲“麒麟”是國內第一個嘗試芯片級液態制冷的產品,將帶有芯片的集成電路板直接浸入液體,有效提升散熱效果。

技術變化二,冷板式液冷的可靠性加強。

應用最爲廣泛的冷板式液冷技術,也有非常大的提升。對於冷板式來說,用戶最擔心的就是漏液風險。冷卻液仍存在極小的安全性泄漏隱患,一旦發生可能引發嚴重的生產停運事故。

我們看到,頭部廠商已經通過提升管路焊接工藝、增加智能漏液監測裝置、使用相變等新技術、液環式真空CDU系統等,來多角度、全方位防範漏液風險,提升冷板式液冷的可靠性、安全性。

技術變化三,浸沒式液冷的下沉。

液冷有三種主流方式:冷板式、浸沒式、噴淋式。其中,冷板式最大衆,是應用最早的液冷技術,曙光、浪潮、百度、華爲等都开始在數據中心應用冷板式液冷技術;噴淋式最沒存在感,公开的應用很少;浸沒式,長期以來是創新性極強的“黑科技”,節能性強,也是最爲昂貴的“高嶺之花”。近年來,浸沒式液冷也开始從超算飛入尋常數據中心,有了“技術下沉”的趨勢。

比如2021 年,微軟研發了一種非常先進的兩相浸入式液冷方案,將電子元件浸入一桶液體中,這種液體的沸點很低,50°C(122°F)就會沸騰蒸發,吸走設備運行時產生的熱量,這一技術已經在位於華盛頓州昆西的數據中心運行,也讓微軟成爲第一家在生產環境中運行兩相浸入式液冷的雲廠商。

國內,中科曙光此前也已經在超算系統中應用了浸沒式液體相變的冷卻方式,積累了相應的技術和實踐,並开始將其帶到數據中心,阿裏也推出了單相變液冷產品。

(微軟Azure數據中心在測試兩相液浸式冷卻技術)

另一個粘性,體現在成本的顯著下降。

前期的建設成本。目前國內外廠商都开始推出模塊化設計的冷板式液冷解決方案,各個模塊(外冷設備、CDU模塊、集群環網模塊等)獨立設計、獨立安裝,大大提升了數據中心的建設效率,可以快速部署,省掉很多工時和流程,從而間接降低用戶成本。

後期的維護成本。近年來有實力的頭部廠商开始推出“交鑰匙工程”,提供液冷數據中心全生命周期整體解決方案,全线布局、加強服務,來降低綠色數據中心的後續成本。

折中的部署成本。一些傳統的風冷數據中心,不能新建機房,改造成本又比較高,難道就只能望洋興嘆了嗎?液冷產業還真想出辦法了,有廠商的液冷產品支持風液混布,風冷和液冷分別處於不同的子機房,互相之間獨立無幹擾,一樣可以達到降PUE的效果,同時無需改造風冷機房,避免了樓梯改造、空間重布的麻煩。

需求強勁、技術可用、成本下降,液冷近年來的創新確實是踩在了時代的韻腳,黏住了數據中心,也黏住了基礎設施廠商。曙光、華爲、聯想、阿裏雲、浪潮、寧暢等知名廠商紛紛發力,熱度看來還能再持續一陣。

能也:命運掌握在誰手裏?

有句老話,時也命也運也,非吾所能也。成功有時候靠的是天命和運勢等,超出了個人的掌控能力。表現在科技領域,就是那些站在新技術浪潮之巔的企業,往往能隨着時代巨浪向前發展。

這是不是說,只要抓住“液冷”這個概念,就能喫到數據中心行業接下來的紅利呢?

歸根結底,要站上時代之巔確實有運勢一說,不全看真本事,但不能沒有真本事。

2022年以來,廠商都在將液冷列入战略規劃,加大投入力度,我們能隔三岔五聽到液冷的產品與解決方案發布,隱隱有着全行業开花的趨勢。

然而必須承認的是,大衆對液冷的關注,很大一部分來自雙碳政策的壓力,追求數據中心節能的“政策正確”,企業必須在壓力下去更新IT基礎設施是“液冷”邏輯成立的前提。

而商業邏輯之外,我們更應該看到,液冷技術大規模商用的瓶頸,才能更好判斷,哪些企業是真的能交付成熟的產品,哪些企業是將“液冷”作爲一種趨勢在對客戶宣講。

第一個門檻,就是長時間投入的定力。

液冷數據中心是典型的技術密集型產業,需要參與者有多年的研發經驗,來積累和掌握前沿技術,較高的研發費用決定了這只可能是少數頭部廠商的遊戲,還是要跟進微軟、谷歌、華爲、阿裏、浪潮、曙光、聯想等頭部廠商的動態。尤其液冷數據中心的落地部署都是近年來才完成,缺乏長周期、大規模的驗證,比如浸沒式液冷還有很多技術規範是空缺狀態,這些企業的發展布局較早,使用過程中的可靠性更有保障。

第二個門檻,是標准化和定制化的平衡。

沒有標准化、規範化的產品設計和制造能力,產品和解決方案的成本很難被攤薄,後續的擴展和適配也可能存在隱患。與此同時,數據中心的規模不同、承載的業務負載也不同,比如用來進行AI大模型訓練的企業級數據中心,和小型數據中心,對液冷服務器產品的需求截然不同,電力系統、能源條件、能效目標等指標也各不相同,這又要求企業能夠針對性地定制產品和解決方案,滿足多元化的需求,非標產品也能做到成本可控,這非常考驗廠商的精益生產。

第三個瓶頸,是軟實力的充分完善。

數據中心採用液冷技術和產品涉及到復雜的規劃、改造、運維等工作,基礎設施廠商不僅要能提供過硬的硬件產品,軟實力也必須過關。一方面,是足夠全面,通過全生命周期從規劃到運維的服務,爲客戶解決全系統環節可能出現的問題,充分保障液冷數據中心的可靠運行。另一個是足夠高效,通過人工智能等技術提高服務器利用效率,能耗治理不是“引入液冷,萬事大吉”,還要通過電力網、算力網和熱力網的協同優化,構建最優能耗體系。谷歌使用DeepMind AI產品在40個月內將冷卻能耗減少了18%。此外,足夠多的朋友。液冷是非常需要產業鏈協作的,從上遊的冷卻液、芯片供應商到部件生產商、下遊的ISV經銷夥伴,擁有一個友好开放的朋友圈,確保供應鏈的韌性和最終交付效果也是“軟實力”的體現。

從長遠來看,面向算力時代,液冷本身的前景遠大是真實的,不過短時間內,產業條件和應用性還有待加強,必定是先經過一個個示範案例落地的逐步驗證和經驗積累,最終一步步過渡到全液冷、全綠色的產業革命。

液冷來到臨界點,後面必然是巨大變化的开始。數據中心和一個涼爽的夏天,距離已經不遠了。

原文標題 : 夏天到了,給數據中心潑點“冷水”

標題:夏天到了,給數據中心潑點“冷水”

地址:https://www.utechfun.com/post/226591.html