01

AI騙子,防不勝防

AI進化的速度有多快,騙術也跟着變得更狠。

福州一位科技公司的老板,某天突然接到了個好友的微信視頻,說是自己的朋友在外地競標,需要 430 萬的保證金,想走他的公司账戶過個账。老郭在確認視頻通話裏的人和聲音都是他朋友之後,就同意了。

隨後,對方就給老郭發了一張銀行卡轉账成功的截圖,說是錢已經轉到老郭的戶頭上了,由於老郭之前已經確認了朋友的身份,在沒確認錢到帳與否的情況下,直接就把 430 萬轉到了好友給的銀行卡上。

結果,這是一場騙局,還是AI操控的。雖然接到報警後,福州、包頭兩地警銀迅速啓動止付機制,成功止付攔截336.84萬元,但仍有93.16萬元被轉移。

還有利用AI進行聲音合成實施的詐騙。騙子通過騷擾電話錄音等來提取某人聲音,獲取素材後進行聲音合成,從而可以用僞造的聲音騙過對方。

已經有人因爲AI聲音被騙了。曾有某公司財務接到領導電話,要求立刻給供應商轉款2萬元,並將轉账信息以郵件形式發送,轉款理由是避免繳納滯納金,因爲老板的口音十分逼真,財務也信了,在1小時內轉款完成,轉完才發現被騙。

AI 換臉早已不是什么新鮮事,很多短視頻鬼畜博主都精通這種操作,但擬聲技術相對復雜一些,畢竟犯罪分子需要獲取你的聲音,然後通過軟件將聲音變成他們想要的內容。

實際上,如今的騙子想要獲取聲音也並不難,最普遍的方法就是騷擾電話,只要你接電話後並說了幾句話,那么犯罪分子就會對你的聲音進行錄制,並提取你聲音的信息。

有業內人士表示,犯罪分子通過這一套流程進行詐騙的成功率基本是 100%,尤其是面向那些並不懂AI、防範意識可能薄弱的老年群體,AI詐騙更容易發生。

類似的聲音騙局,國外也早有發生。

一個國外的詐騙公司,使用 AI 模擬了“卷福”的音頻,打電話給一家新西班牙的小電影公司,稱想要和對方合作,並要求對方先打款 20 萬英鎊才能見面,結果在電影公司付完錢之後,他們才發現這次事件,完完全全就是一場AI騙局。

對於AI騙局,有律師表示,使用人工智能技術手段模仿真人面容、聲音,冒充親友、熟人、領導等,很容易達到以假亂真的程度,具有極強的迷惑性。與其他類型電信詐騙相比,AI詐騙迷惑性更強,針對性更強,辨識更困難。

如今,耳聽,眼見都不一定爲實,各種騙局真是讓人防不勝防。

02

AI有多強大?讓孫燕姿本人都害怕

最近,關於AI還發生了一個熱點:孫燕姿本人親自回應AI孫燕姿。

對於熱門歌手AI,孫燕姿自己都承認,“諷刺的是,人類再怎么快也無法超越它。”

她在回應小作文裏寫道,“人類無法超越AI技術已指日可待,凡事皆有可能,凡事皆無所謂。”就算暫時能夠辨認出AI歌手和真人歌手的區別,很快這條護城河也將不復存在。這種被虛擬淹沒真實的感受,如今已經在全世界蔓延。

AI不光是唱歌可以完全貼近真人,連直播帶貨的活都可以接。

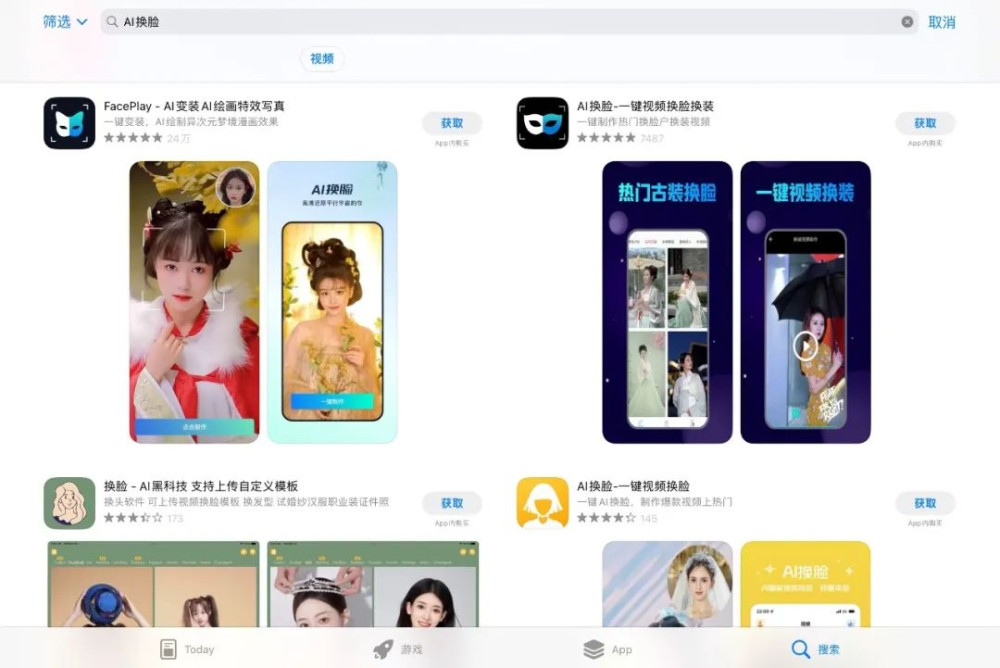

最近有人在直播間裏發現,正在賣貨的竟是當紅女星。然而再定睛一看,這些明星居然是使用了AI實時換臉技術的普通主播。

AI實時換臉,正在直播間悄然出現,楊冪、迪麗熱巴、angelababy等當紅女星,成爲了AI換臉的熱門。雖然目前還沒有曝出被騙新聞,但由於明星臉的帶貨主播往往擁有更好的引流效果,消費者或明星粉絲很可能會衝着明星效應進行消費而被坑騙。

而這種技術門檻也並不高。有媒體報道,AI實時換臉全套模型購买價僅需3.5萬元。

买不起全套模型,還有“AI換臉特效插件”供买家選擇,售價數百元,只對電腦配置有一定要求,購买後使用者只需更換素材照片,軟件就能自己運行完成“換臉”。這款軟件不僅能對圖片進行換臉,也能在視頻上進行換臉。

AI換臉的風靡,還帶來了“AI脫衣”的新問題。早在今年3月,一則“女子地鐵照被AI一鍵脫衣傳播”的新聞衝上了熱搜,一名女性搭乘地鐵時的一張照片被人用AI軟件“一鍵脫衣”,遭到惡意傳播,罪犯還廣泛散布不實信息對該女子進行污蔑。

更可怕的是,AI深度僞造(DeepFake)內容,可以利用互聯網平台在全球範圍內病毒式傳播。比如AI現在居然還能通過發布假新聞,讓股市抖三抖。

幾天前,多個經過驗證的推特账戶,齊刷刷分享了一張聲稱在五角大樓附近發生爆炸的假照片,頓時引起轟動,並導致股市短暫下跌。

這張照片雖然具有AI生成的所有特徵,但是因爲被許多經過驗證並打上了藍色勾的推特账戶分享,不少人還是信以爲真,謠言一傳十十傳百,甚至有人聲稱這張照片與彭博新聞有關。

連印度一家電視台都信了,共和國電視台(Republic TV)報道稱五角大樓發生了爆炸,並在節目中播放了這張假圖片,後來,當發現美國當地官員證實沒有發生此類事件後,共和國電視台快速撤回了這則報道,這一番操作下來也是相當尷尬。

03

AI騙局,並非沒有破綻

隨着AI技術的不斷發展,被AI騙的人越來越多。根據殺毒軟件 McAfee 公布的最新報告,基於人工智能的語音詐騙越發猖獗,在接到 AI 詐騙電話的群體中,有 77% 的人會上當受騙。

今年3月,一份名爲《暫停大型人工智能研究》的公开信在未來生命研究所官網上發布,包括特斯拉CEO埃隆·馬斯克(Elon Musk)、蘋果公司聯合創始人史蒂夫•沃茲尼亞克(Steve Wozniak)等人在內的千名科學家、企業高管籤字呼籲暫緩GPT-4以上版本的研發,他們矛頭所指都是強大AI技術可能的負面用途。

不過AI詐騙雖然逼真,但它並不是沒有破綻,比如AI換臉技術會導致臉部變形,一些主播低下頭頭頂會發黑,AI的聲音,也很難表達真實的主觀情緒。

正如不少網友所說,AI孫燕姿“根本不是孫燕姿的唱法。”“AI孫燕姿能模仿她的音色,但模仿不到她的感情;AI孫燕姿能模仿她的聲音,但模仿不了她的現場。”

與此同時,國內與AI換臉、換聲相關的法律法規也在不斷完善。

在過去,“AI換臉”被大量使用到影視劇二度創作、趣味惡搞視頻、表情包制作當中,其中隱藏的法律風險和侵權糾紛,如今都在得到重視,不少擦邊行爲已經得到了及時的懲治。

比如近期,據企查查官網信息顯示,上海魚腥草信息科技有限公司就因旗下一款換臉手機APP遭多位網紅博主起訴,很快在監管部門約談後,這款App下架,因爲換臉侵犯了公民的肖像權。

去年12月,《互聯網信息服務深度合成管理規定》發布,對人臉生成、替換、操控,合成人聲、仿聲等都有明確約束。顯然,隨着制度設計更精准,相關立法更健全,AI肆意換臉的空間將越來越小。

就在4月11日,國家互聯網信息辦公室又迅速起草了《生成式人工智能服務管理辦法(徵求意見稿)》,涉及的生成式人工智能包括基於算法、模型、規則生成文本、圖片、聲音、視頻、代碼等內容的技術,可以說,對當下的AI僞造都進行了更爲全面的約束。

AI究竟是天使還是魔鬼,全在於使用者的一念之差,但唯一可以確定的是,潘多拉魔盒,已經打开。

參考資料:

《AI詐騙正在全面爆發》,紅星新聞;

《“AI換臉”詐騙防不勝防?要用“法”打敗“魔法”!》,京報網;

《警惕四大AI新騙術,有人10分鐘被騙430萬》,智東西

原文標題 : 10分鐘騙走430萬,如何堤防詐騙新技術?

標題:10分鐘騙走430萬,如何堤防詐騙新技術?

地址:https://www.utechfun.com/post/217730.html