AI大模型,如今被公認爲是改變未來科技公司、社會發展的先進技術,引得一衆科技公司、創業公司關注與押注。在激烈競爭中,已有數家布局該領域的企業企圖通過多渠道融資的方式爲AI大模型的業務提供資金支持。

文丨阿秋

編輯丨劉備

5月10日,據《AI前哨》消息,有知情人士透露,中國人工智能公司及智能設備制造商出門問問正與中金公司和招銀國際合作,爲最快可能在年內开展的香港首次公开募股(IPO)做准備,籌資規模或達2億至3億美元。4月20日,該公司公开宣布內測探索大模型“序列猴子”。

今年3月底,雲從科技定增計劃申請獲科創板受理,將再次進行募資,定增計劃募資資金超36億元。此次定增計劃距離其IPO不滿一年,此前其IPO募資總額爲17.28億元。

“這是一個確定性的機會,如果輸了,五年最高虧一百億美金,但要是成了,20年賺一萬億美金。要是你,怎么選?”《經濟觀察報》報道稱,某科技上市公司CTO表示,一家公司即便數據不夠多,但有一定的資本、算力技術等資源,“是我,我也會選擇做大模型。”

融錢養活AI大模型?

AIGC,即 AI Generated Content,是指利用人工智能技術來生成內容。

2021 年之前,AIGC 生成的主要是文字,而新一代模型可以處理的格式內容包括文字、語音、代碼、圖像、視頻等等。目前主要用在文字、圖像、視頻、音頻、遊戲等領域。如今所被廣泛應用的 AI 繪畫、AI 寫作等都屬於 AIGC 的分支。

AIGC 技術的基本原理是利用人工智能技術中的“自然語言處理”、“機器學習”、“深度學習”等技術,對大量的語言數據進行分析、學習和模擬,從而實現對自然語言的理解和生成。AIGC 可以稱之爲 Web 3.0 時代強有力的生產力工具。

自四月至今,出門問問、科大訊飛以及雲從科技相繼發布了各自的AI大模型,大模型的名稱、業務能力以及未來的落地場景各有不同,但從各家財報以及最新的公司動態可以看出,AI大模型是一個費錢的技術,不僅短期對科大訊飛第一季度的業績造成影響,而且還引得雲從科技开啓定向募資36億元,給公司大模型的研發提供資金支持。

出門問問是一家以語音交互和軟硬結合爲核心的人工智能公司,已陸續推出過AI智能手表、AI真無线智能耳機、智能音箱等智能硬件產品。

4月20日,出門問問宣布內測探索大模型“序列猴子”,但彼時創始人對自己的“序列猴子”打了不及格分,李志飛表示,“如果說ChatGPT-4是100分,我們的模型只有50分,雖然還有差距,但看到了上哈佛的希望。”

5月10日,《AI前哨》報道稱,有知情人士表示,出門問問正與中金公司和招銀國際合作,爲首次股票發行做准備,此次IPO可能會融資2億美元至3億美元,最早可能在今年進行IPO。不過,目前IPO考慮還處於初步階段,融資規模和上市時間等細節可能會改變。

據公开資料顯示,出門問問創始人李志飛一直有將出門問問上市的計劃。

早在2017年,李志飛曾表示計劃兩年內尋求IPO,彼時稱或許會在美國或香港上市;2018年接受媒體採訪時,他又稱計劃在2019年底或2020年上半年考慮上市;2019年,彭博社引述知情人士消息,出門問問即將獲得融資,使其在IPO之前的估值超過10億美元。該公司正尋求籌集1億美元資金,並計劃在上海證券交易所科創板上市。

但最近李志飛在接受媒體採訪時透露,近期並無融資打算,因爲公司的商業化做得不錯,且自己希望能夠花能用1/10的錢,幹出比別人10倍好的事情,因爲這會讓他有成績感。

與出門問問目前不太差錢的發展狀態不同,雲從科技從創立至今都未成功脫離虧損的泥潭。

據2022年年報,雲從科技2022年營收爲5.26億元,與上年同期相比減幅51.06%;扣除非經常性損益後歸屬於上市公司股東的淨利潤爲-9.46億元,上年同期爲-7.53億元,虧損較上年度擴大1.93億元;經營活動產生的現金流量淨額爲-6.30億元,較上年度減少0.7億元。

談及各項數據下降原因,雲從科技在財報中寫明,主要是受宏觀經濟增速放緩以及市場競爭格局加劇等多重因素影響,收到的政府補助減少,公司項目業務規模下降,以及爲增強技術優勢,持續進行研發投入所致。

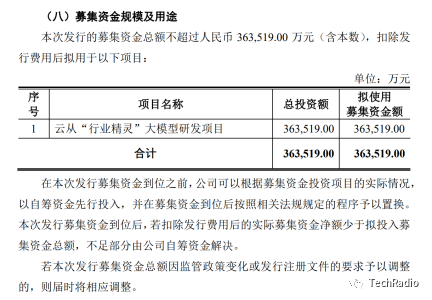

今年3月,雲從科技开始向科創板申請定增計劃並獲得受理,此次將定向融資36億元,旨爲用於雲從“行業精靈”大模型研發項目。

圖源:《雲從科技集團股份有限公司2023 年第一次臨時股東大會會議資料》

雲從科技表示,公司目前融資渠道相對單一,資金來源主要依靠銀行信貸,無法滿足公司業務快速發展的需要。公司需要擴充市場化融資渠道,爲技術迭代與產品线擴充提供必要的資金支持。本次定向募集資金,有助於增強公司資本實力、緩解公司營運資金壓力,提高公司的核心技術競爭力,鞏固並提升公司的行業地位,爲公司未來經營發展提供有力的保障。

5月6日剛剛對外推出星火大模型的科大訊飛,雖然去年全年利潤爲正,但投入大模型的研發也在一定程度上拖累了科大訊飛今年第一季度業績。

科大訊飛2023 年第一季度報告顯示,公司 2023 年第一季度營業收入 28.88 億元,較去年同期下降17.64%;歸屬於上市公司股東的淨利潤與扣除非經常性損益的淨利潤分別爲-0.58億元和-3.38 億元。

談及下滑原因,科大訊飛在財報中解釋稱,面對認知智能技術階躍帶來的重大機遇,公司於 2022年 12 月 15 日啓動了“1+N 認知智能大模型專項攻關”,該攻關項目的新增投入一定程度上影響了當期利潤,但是會帶來公司已有產品競爭力的顯著提升。

AI大模型有多費錢?

AI大模型的訓練成本、基礎設施成本和人才成本,可謂是壓在企業頭上的三座成本大山。

據國盛證券報告《ChatGPT需要多少算力》估算,GPT-3訓練一次的成本約爲140萬美元,對於一些更大的LLM(大型語言模型),訓練成本介於200萬美元至1200萬美元之間。以ChatGPT在今年1月的獨立訪客平均數1300萬計算,其對應芯片需求爲3萬多片英偉達A100 GPU,初始投入成本約爲8億美元,每日電費在5萬美元左右。

法國裏昂商學院人工智能管理學院(AIM)院長、全球商業智能中心(BIC)主任龔業明在接受媒體採訪時表示,“大模型的訓練和推理成本一直以來是AI產業發展的瓶頸,因此具有大模型構建能力的企業往往是世界科技巨頭。這會形成強大的護城河,造成強者恆強的局面。”

行業人士普遍認爲,1萬顆A100芯片是訓練大模型的入門券,但現在廠商面臨的問題是买不到芯片,且國產替代芯片在性能和價格上都會大打折扣。此前有媒體報道稱,國內擁有超過1萬枚GPU的企業不超過5家,且多爲英偉達中低性能產品,而擁有1萬枚A100芯片的企業最多只有一家。

構建大模型的計算基礎設施,不僅是簡單的硬件堆砌,更需要實際搭建過程中積累的know-how(實踐知識)。

據《每日經濟新聞》,阿裏雲CTO周靖人表示,“所有GPU不是簡簡單單地堆砌,更需要的是讓所有GPU,讓異構算力能夠聯合起來去爲我們的模型訓練服務。我們有成千上萬的模塊,如何幫助他們有效地高速連接起來,如何能夠提供一個高吞吐、低延遲的網絡方案,對模型訓練是至關重要的。”此外,完善的大規模的數據存儲和低延遲的網絡方案同樣重要。

原文標題 : AI大模型如此多嬌,引得雲從科技出門問問競相融資

標題:AI大模型如此多嬌,引得雲從科技出門問問競相融資

地址:https://www.utechfun.com/post/216191.html