▎AMD、英特爾和中國公司都在積極开發和發布新的AI芯片產品,以爭取在AI芯片市場的份額,與英偉達展开競爭。AMD預計,2027年全球數據中心 AI 計算市場規模將超過1500億美元。

作者|林志佳

來源|鈦媒體

隨着英偉達率先佔領 AI 大模型算力芯片市場,並超過萬億市值。而同時,英特爾、AMD和中國GPU芯片公司也在暗暗較勁,希望在AI算力芯片市場中分一杯羹。

9月19日,美國聖何塞舉行的Intel On技術創新大會上,62歲英特爾 CEO 基辛格(Pat Gelsinger)“火力全开”,以俯臥撐开場演講。

此次會議上,基辛格一口氣發布一系列新技術產品:基於Intel 4(5nm)工藝的英特爾酷睿Ultra處理器,代號“Meteor Lake”;預覽第五代至強服務器芯片和後續至強產品路线圖;披露5nm AI 芯片Gaudi 3等。

英特爾CEO基辛格(Pat Gelsinger)現場做俯臥撐場景

相比往屆,此次基辛格“變身皮衣老黃”,全場近2小時大談 AI 算力對經濟的作用。據鈦媒體App統計,此次演講中,基辛格約有200次提到“人工智能”、“深度學習”相關術語。

幾乎在同一時間,英特爾、英偉達的競爭對手AMD公司,發布了最新EPYC 8004 CPU(中央處理器)芯片,並預計年底前出貨MI300系列AI芯片,以對抗英偉達。此外在國內,包括華爲、天數智芯等 AI 芯片廠商也在積極布局大模型訓練推理和 AI 算力產品。

“我們與 AI 算力芯片市場領導者英偉達競爭非常激烈。但無論是Gaudi2 還是Gaudi3,都比他們往前邁出了一大步。我們正在獲得動力,市場开始意識到,AI 芯片行業領導者中還有另一個機會。”基辛格9月20日對CNBC表示。

市場競爭加劇

“老黃”難以獨食萬億AI算力

2023年至今,以ChatGPT爲代表 AI 大模型“熱潮”席卷全球,大模型正推動 AI 向更通用方向發展。

同時,算力的稀缺和昂貴已成爲制約 AI 發展的核心因素。而算力也成爲了全社會數字化、智能化轉型的重要基石,從而帶動智能算力需求激增。

據AMD首席執行官蘇姿豐(Lisa Su)提供的數據顯示,2023年,全球數據中心AI加速器的潛在市場總額將達到300億美元左右,預計到2027年,這一數字將超過1500億美元(約合人民幣1.095萬億元),年復合增長率超過50%。

英偉達企業運算副總裁曼努維爾·達斯(Manuvir Das)給出了另一組數據顯示,預計 AI 所在的潛在市場(TAM)規模將增長至6000億美元。其中,芯片和系統可分得3000億美元,生成式AI軟件可分得1500億美元,另外1500億美元則由英偉達企業軟件貢獻。

很明顯,AI 算力芯片市場是一塊大“蛋糕”。

但目前,英偉達卻佔據全球數據中心 AI 加速市場82%的份額,而且以95%的市場佔有率壟斷了全球 Al 訓練領域的市場,成爲這輪 AI 混战中最大贏家。而黃仁勳和他的英偉達公司賺的盆滿鉢滿,市值超越1萬億美元。

與此同時,算力需求的激增,直接導致英偉達GPU(圖形處理器)“一卡難求”。而有多少英偉達A100顯卡,已經成爲衡量一個公司算力的標准。

事實上,一家企業若想研發通用大模型,在算力層面需首先關注兩點:顯卡數量和價格。

其中,顯卡數量方面,OpenAI使用了1萬-3萬顆英偉達GPU來訓練GPT-3.5模型。據集邦咨詢最新報告顯示,如果以英偉達 A100 顯卡的處理能力計算,運行ChatGPT將可能需要使用到3萬塊英偉達GPU顯卡。另外在开源模型方面,Llama模型則是在2048塊80GB A100上訓練,整個訓練算力接近2000 PTOPS算力。

價格方面,目前國內可以买到的H800價格已經高達20萬/張,而A100/A800價格已漲至15萬、10萬/張左右。以2000P算力需求爲例,H800 GPU單卡算力2P,需要1000張,預測整個卡價格爲2億元;A800單卡算力約爲0.625P,需要數量爲3200張,預計整個顯卡價格就高達3.2億元。

除了买GPU顯卡,服務器還要考慮整機配置運算,包括CPU、存儲、NV-Link通訊連接等,以及電力消耗、場地租金和運維成本等因素。

當下,A800和H800服務器主要以8卡機型爲主,爲了滿足2000 P的算力,就需要配置125台8卡H800服務器,或400台8卡A800服務器,價格分別爲3億元、5.6億元。而且,由於H800還支持PCIe 5.0、新一代的CPU和內存等,因此需要提升價格,才能發揮其最優的算力性能。

所以,從大模型訓練角度看,購买H800的總成本要低於A800,性價比更高,而且也比搭建CPU的成本要低——這也就是英偉達CEO黃仁勳最近常說的:“买的越多,省的越多”。

當然,如果你實在买不起也沒關系。英偉達還貼心地推出在线租賃服務DGX超級AI計算系統,通過租賃的方式开放給企業,搭配8個H100或者是A100的GPU,每個節點640GB內存,每月租金爲37000美元,從而不用自建數據中心購买大量GPU顯卡。這類租賃方式毛利率很高,根據一份關於微軟“雲端算力租賃”服務報告顯示,該業務毛利率高達42%,已成爲微軟新的“現金奶牛”。

那么國內市場,英博數科、商湯AIDC和其他超過11個智算中心/雲廠商也有類似的服務,對於大模型來說,整體價格要比自建價格減少20%以上。

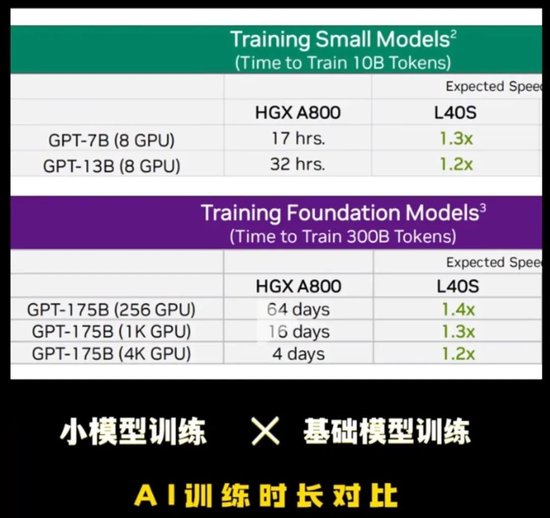

此外還有大模型訓練時間。英偉達最新發布的NVIDIA L40S GPU,比A800/H800模型訓練效率更高。一個70億參數的模型,HGX A800跑完需要17個小時,而L40S速度要快1.3倍,短短半天時間就跑完了,更不用說一個1750億參數的模型,用L40S一個周末時間就能訓練完。

總的來說,一家企業要做大模型,需要在算力成本方面就要耗資數億元,而這才只是“入場券”。

早前有消息稱,百度、字節跳動、騰訊和阿裏巴巴已經向英偉達下單訂購價值50億美元的芯片,加上此前的囤積的顯卡數量,國內擁有英偉達GPU顯卡總額超過千億元。市場調研機構Counterpoint發布報告稱,盡管半導體行業周期性下行未止,但騰訊、百度等中國企業仍在大舉採購英偉達A800芯片。

那么,這么一個萬億級規模的重要市場,無論是芯片企業,還是下遊客戶,都不想看到“英偉達”一家獨佔鰲頭。因此,AMD、英特爾和中國GPU芯片企業紛紛試圖挑战英偉達在 AI 芯片市場的霸主地位。

AMD首先出擊。

AI 芯片方面,今年1月2023年消費電子展(CES)上,AMD董事長、CEO蘇姿豐(Lisa Su)正式發布下一代面向數據中心的APU(加速處理器)產品Instinct MI300,採用台積電5nm+6nm結合的Chiplet架構設計,集成CPU和GPU,擁有13顆小芯片,晶體管數量高達1460億個,AI性能和每瓦性能是前代MI250的8倍和5倍(使用稀疏性FP8基准測試),將在2023年下半年量產供貨。

隨後6月,AMD還公布全新專爲生成式 AI 打造、擁有1530億個晶體管的 AI 加速芯片Instinct MI300X、Instinct MI300A等產品,在存儲容量、互聯帶寬方面均有提升,MI300X的晶體管數量比H100多兩倍,HBM3高帶寬內存是H100的2.4倍。單顆芯片上可以運行800億參數的大模型,預計今年底之前發貨。

這不僅全面展示收購賽靈思之後的數據中心 AI 技術能力,而且也在挑战英偉達 AI 算力芯片霸主地位。

當然不止是GPU和 AI 芯片,AMD最擅長的就是做CPU(中央處理器)芯片,畢竟數據中心需要CPU的通用計算能力。去年11月,AMD發布了採用Zen 4架構的第四代數據中心EPYC 9004系列,代號爲“熱那亞”(Genoa),不僅架構升級,蘇姿豐還在這顆芯片上堆料堆到了極致:台積電5nm制程,96個核心,192個线程,384M三級緩存,支持PCle5.0。

與英特爾的八核處理器相比,AMD的數據中心、邊緣計算CPU系列在能耗、性能方面都有很大提升,包括熱那亞芯片面積減少40%,同時能源效率提高48%。

今年9月,AMD則推出最新第四代EPYC 8004系列,將“Zen 4c”核心引入專用CPU,提供從智能邊緣(例如零售、制造和電信)到數據中心、雲計算等領域。

事實上,亞馬遜雲AWS發布了基於熱那亞M7A通用計算實例,最終結果顯示,性能相比前一代提升50%,而相比英特爾第四代至強白金版8490H版,熱那亞在多個應用場景的性能提升達1.7-1.9倍,整體的能效提升達1.8倍,全面用於金融建模、天氣模擬、藥物研發等高性能計算領域。另外在 IoT Edge網關工作負載中,最新八核EPYC 8024P供電的服務器也爲每8kW機架提供大約1.8倍的總吞吐量性能。

整體來看,無論是CPU、GPU,還是FPGA、DPU數據中心處理器,或是軟件棧工具AMD ROCm系統,AMD都已經做好了准備,正“磨刀霍霍”以挑战英偉達的產品。

作爲成立60多年的芯片巨頭,英特爾也不想將市場“拱手讓人”。

今年7月11日,芯片巨頭英特爾公司(Intel)在北京發布面向中國市場、採用7nm工藝的 AI 芯片Habana Gaudi2,可運行大語言模型,加速AI訓練及推理,運行ResNet-50的每瓦性能約是英偉達A100的2倍,性價比相較於AWS雲中基於英偉達的解決方案高出40%,並預計今年9月性價比超越英偉達最新H100。

英特爾執行副總裁Sandra Rivera 今年7月對鈦媒體App表示,不可能有唯一一家企業獨霸 AI 芯片市場。因爲市場需要多樣性,並且客戶也希望看到更多的芯片企業在 AI 領域發揮領導作用。

英特爾CEO基辛格(Pat Gelsinger)

9月,在美國聖何塞舉辦的英特爾On技術創新大會上,基辛格宣布採用5nm制程的 AI 芯片Gaudi 3將於明年推出,屆時,其算力將會是Gaudi 2的兩倍,網絡帶寬、HBM容量則會是1.5倍。

同時,基辛格還預覽第五代英特爾至強可擴展服務器處理器,稱下一代至強將擁有288核心,預計將使機架密度提升2.5倍,每瓦性能提高2.4倍。另外,英特爾還發布Sierra Forest、Granite Rapids,與第四代至強相比 AI性能預將提高2到3倍。

阿裏雲首席技術官周靖人表示,阿裏巴巴將第四代英特爾至強處理器用於其生成式 AI 和大語言模型,即“阿裏雲通義千問大模型”,而英特爾技術大幅縮短了模型響應時間,平均加速可達3倍。

此外,對於 AI 大模型訓練來說,比較重要的是軟件生態。英特爾宣布與 Arm 公司合作,使其至強產品部署到Arm CPU 上,同時推出AI推理和部署運行工具套件OpenVINO,不僅支持預訓練模型,而且只需編寫一次即可部署任何可用的關鍵跨平台支持,已支持Meta的Llama 2模型。

同時,Linux基金會在本周還宣布成立統一加速(UXL)基金會,提供开放標准的加速器編程模型,簡化高性能、跨平台應用程序的开發,核心是加速演進英特爾oneAPI計劃,創始成員包括 Arm、谷歌雲、英特爾、高通、三星等公司——英偉達不在其中。

英特爾公司高級副總裁、英特爾中國區董事長王銳對鈦媒體App等表示,英特爾後續將發布擁有288核的處理器。數據中心在未來也會越來越多,英特爾將推出Gaudi3、Falcon Shores等產品,產品矩陣將構成未來加速器與AI計算發展的路线圖。

“我們把AI的能力內置到芯片中。根據不同需求,內置AI能力將使用不同算力、不同架構來提供支持。”王銳表示,在數據中心方面,從客戶端到邊緣端,再到雲端,AI已經滲透到各種應用場景;從進行大語言模型訓練到進行小規模、普惠語言模型訓練,AI的影響力無處不在。

今年8月底基辛格表示,他認爲英特爾正邁向達成其宏大的整頓目標,朝着恢復在產業的領先地位前進。而談及英偉達時,基辛格坦承英偉達布局良好,能抓住支持 AI 軟件擴張所需系統的需求,但他說,英特爾很快將开始贏得這些加速器芯片市場的訂單。

“他們做得很好,我們都贊揚他們。但我們即將展現實力。”基辛格表示。

英偉達市值蒸發千億美元,

國產芯片能否抓住機遇?

英偉達在2023年的輝煌表現,似乎在近兩個月有所減弱。

根據Refinitiv的數據顯示,盡管英偉達今年股價上漲約190%,表現十分亮眼,但其在9月的股價表現不佳:自8月31日以來,英偉達股價已下跌超過10%,總市值蒸發了超過1760億美元。

事實上,英偉達股價下跌因素有很多。

首先,市場對美聯儲爲了抑制通膨而將利率維持在較高水准更長時間的擔憂加劇,整個股市承壓,標准普爾500指數9月平均下跌0.7%、迄今下跌近4%。

其次,以LIama 2爲代表的开源模型陸續發布,更多企業开始直接使用這些模型,僅需要AI推理芯片即可應用,這導致了對算力訓練芯片的需求有所減少。

最後,據The Information報道,英偉達一直非常關注一些美國中小型雲計算公司的顯卡供應情況,在當前“一卡難求”的情況下,英偉達對谷歌、Meta等大公司以及中國企業的後續服務和顯卡供應,似乎不再是首要優先,而這直接導致市場對於英偉達產品供應能力的質疑。

當然,瑕不掩瑜,英偉達在 AI 算力市場有很大的先發優勢。除了GPU芯片性能領先外,其龐大的 AI 軟件生態CUDA讓很多人望塵莫及。另外,英偉達的NVLink 高速GPU 互連技術也成爲大模型技術提升的“關鍵法寶”,它的作用遠高於GPU單卡本身。

百川智能創始人、CEO王小川曾提到,在該行業中,GPU的算力成本大概佔40%-70%,而其中網絡連接成本和GPU顯卡成本的比例大概爲3:1。

“未來如果往更高模型去發展,算力儲備非常關鍵。從訓練、推理兩部分看,推理需要有國產 AI 芯片,而不止有英偉達,但訓練目前只有英偉達做的最好。這場‘算力仗’,中國的國產 AI 芯片必須要能頂上。”王小川表示。

實際上,除了兩大芯片巨頭之外,隨着國內“百模大战”,AI 算力需求激增,但英偉達 AI00/H100等多款 AI 芯片限制向中國出口,國內企業越來越難拿到美國的高端芯片。

2022年10月,美國商務部下屬工業和安全局(BIS)發布出口管制新規,量化各項芯片算力、帶寬、制程等指標,限制美國企業對中國出口,其中關於高算力芯片的限制,直接衝擊中國AI、超算、數據中心等相關行業發展。主要滿足AI等需求的GPU(圖形處理器)廠商英偉達,8月就接到了美國政府限制有關先進芯片出口的通知。

英偉達反應迅速,2022年三季度就投產了A800芯片,以替代無法繼續向中國出貨的A100。這也是美國公司爲此推出的首個“特供”產品。

英偉達並未對外公布關於A800的詳細參數,不過,其經銷商提供的產品手冊顯示,A800峰值算力與被限制出口的A100一致,但傳輸速率被限制在A100的三分之二,以符合美國政府的相關要求。而最新的“中國特供版”H800的訓練算力則比H100要差約40%,如果沒有英偉達提供的互連模塊,算力差距可達60%以上。

英特爾則於2023年7月爲其Gaudi 2產品推出中國版本。Gaudi 2是一款ASIC(專用集成電路)芯片,主要面向高性能深度學習AI訓練。與2022年5月公布的國際版相比,中國版Gaudi 2中集成的以太網端口由24個減少爲21個。英特爾當時稱,這是一個相對較小的變動,對實際性能表現影響有限。基辛格日前表示,目前公司正在中國銷售Gaudi 2中國版,他希望之後一直這樣做下去。

所以在國外芯片限制影響下,華爲、天數智芯、寒武紀、登臨科技等國內 AI 算力公司積極布局,以填補國產 AI 算力空缺。

目前,國產 AI 算力市場主要分爲三大派別:一是華爲鯤鵬和昇騰 AI 生態的算力方案,其中沒有英偉達GPU的參與;二是混合型算力支持,大量採用英偉達A100芯片,並在部分環境中加入AMD、英特爾以及天數智芯、寒武紀、海光等芯片,以支持大模型的訓練;三是租用性價比更高的服務器雲算力,以補充算力不足情況。

今年8月舉行的2023 亞布力中國企業家論壇第十九屆夏季高峰會上,科大訊飛創始人、董事長劉慶峰表示,華爲的GPU技術能力現在已經與英偉達A100相當,現在已經做到對標英偉達A100。

9月20日,華爲副董事長、輪值董事長、CFO孟晚舟表示,華爲推出全新架構的昇騰AI計算集群,可支持超萬億參數的大模型訓練。華爲將持續打造堅實的算力底座。

天數智芯董事長兼CEO蓋魯江透露,目前,多家國內大模型公司已开始使用國產 GPU顯卡,且該公司已支持完成70億參數大模型訓練工作。

另外,其他國產GPU企業多數正處於AI推理訓練階段。

蓋魯江認爲,在國內,英偉達在訓練領域的市場份額高達95%以上,部分達到99%,基本實現了壟斷,這主要得益於其硬件架構和廣泛應用的CUDA生態——已有超過300萬全球用戶。當前,國內GPU企業面臨生態遷移難題,由於衆多基於CUDA的代碼,轉向新生態將需大量時間和成本。

在最近一場圓桌活動上,登臨科技聯合創始人兼首席架構師王平提到,對於AIGC的客戶來說,不僅需要文本生成圖片等解決方案,更重要的是實用的產品。因此,需要具有大算力和通用性強的算力產品落地應用,爲客戶創造價值。據悉,登臨科技的新一代AI芯片產品能耗比國際主流通用GPU產品有3倍以上的優勢。

蓋魯江表示,對於天數智芯來說,下一步計劃優化產品迭代,需依賴數據、客戶反饋與技術創新,並針對國內特殊需求進行調整。同時,公司會積極完善生態體系和軟件棧,確保用戶在效率、成本、性能和性價比上獲得最優體驗,以推動產品進一步商業化。

王平認爲,由於獲取美國高端芯片的難度增加,雖然國內尚無企業能生產能真正替代的芯片,但他相信國產算力會不斷增長。芯片需不斷迭代,用戶越多,問題反饋越多,國產 AI 芯片企業才能在後續迭代中改進,提升使用體驗。

“對國內通用GPU企業來講,這是一個重大的機遇。”蓋魯江告訴鈦媒體App。

(本文首發鈦媒體App)

海量資訊、精准解讀,盡在新浪財經APP

海量資訊、精准解讀,盡在新浪財經APP

責任編輯:韋子蓉

標題:中美“圍剿”英偉達,萬億AI芯片市場難獨霸

地址:https://www.utechfun.com/post/266851.html