9月20日,商湯科技與上海人工智能實驗室聯合香港中文大學和復旦大學正式推出書生·浦語大模型(InternLM)200億參數版本InternLM-20B,並在阿裏雲魔搭社區(ModelScope)开源首發。

同時,書生·浦語面向大模型研發與應用的全鏈條工具鏈全线升級,與InternLM-20B一同繼續全面开放,向企業和开發者提供免費商用授權。

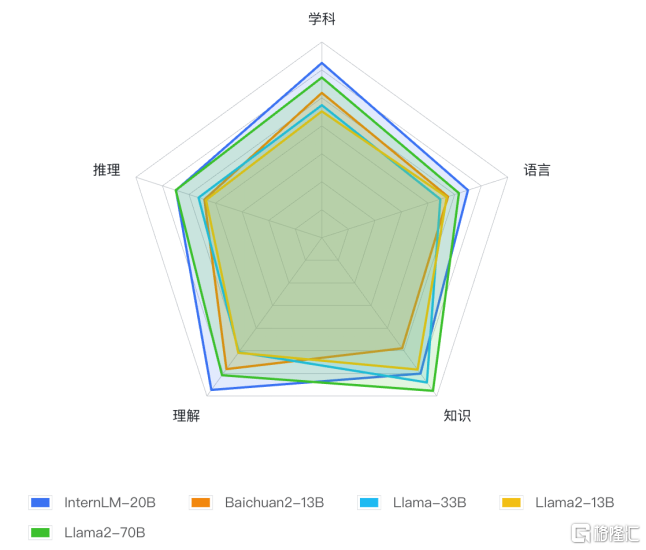

自今年6月首次發布以來,書生·浦語已經歷多輪升級,在开源社區和產業界產生了廣泛影響。InternLM-20B模型性能先進且應用便捷,以不足三分之一的參數量,達到了當前被視爲开源模型標杆的Llama2-70B的能力水平。

書生·浦語"增強版":增的不只是量

相比於國內社區之前陸續开源的7B和13B規格的模型,20B量級模型具備更爲強大的綜合能力,在復雜推理和反思能力上尤爲突出,因此對於實際應用能夠帶來更有力的性能支持。

另一方面,20B量級模型可以在單卡上進行推理,經過低比特量化後,可以運行在單塊消費級GPU上,給實際使用帶來很大的便利。

InternLM-20B是基於2.3T Tokens預訓練語料從頭訓練的中量級語言大模型。相較於InternLM-7B,訓練語料經過了更高水平的多層次清洗,補充了高知識密度和用於強化理解及推理能力的訓練數據。

在理解能力、推理能力、數學能力、編程能力等考驗語言模型技術水平的方面,InternLM-20B與此前已开源模型相比,性能顯著增強:優異的綜合性能,通過更高水平的數據清洗和高知識密度的數據補充,以及更優的模型架構設計和訓練,顯著提升了模型的理解、推理、數學與編程能力。

InternLM-20B全面領先量級相近的开源模型,使之以不足三分之一的參數量,評測成績達到了被視爲开源模型的標杆Llama2-70B水平。

擁有強大的工具調用能力,實現大模型與現實場景的有效連接,並具備代碼解釋和反思修正能力,爲智能體(Agent)的構建提供了良好的技術基礎;

支持更長語境,支持長度達16K的語境窗口,更有效地支撐長文理解、長文生成和超長對話,長語境同時成爲支撐在InternLM-20B之上打造智能體(Agent)的關鍵技術基礎;

具備更安全的價值對齊,書生·浦語團隊對InternLM-20B進行了基於SFT(監督微調)和RLHF(基於人類反饋的強化學習方式)兩階段價值對齊以及專家紅隊的對抗訓練,當面對帶有偏見的提問時,它能夠給出正確引導。

基於OpenCompass的InternLM-20B及相近量級开源模型測評結果

全鏈條工具體系再鞏固:各環節全面升級

今年7月,商湯科技與上海AI實驗室聯合發布書生·浦語的同時,在業內率先开源了覆蓋數據、預訓練、微調、部署和評測的全鏈條工具體系。

歷經數月升級,書生·浦語全鏈條开源工具體系鞏固升級,並向全社會提供免費商用。

全面升級的全鏈條工具體系

數據-OpenDataLab开源"書生·萬卷"預訓練語料

書生·萬卷是开源的多模態語料庫,包含文本數據集、圖文數據集、視頻數據集三部分,數據總量超過2TB。

目前,書生·萬卷1.0已被應用於書生·多模態、書生·浦語的訓練,爲模型性能提升起到重要作用。

預訓練-InternLM高效預訓練框架

除了大模型外,InternLM倉庫也开源了預訓練框架InternLM-Train。深度整合了Transformer模型算子,使訓練效率得到提升,並提出了獨特的Hybrid Zero技術,使訓練過程中的通信效率顯著提升,實現了高效率千卡並行,訓練性能達行業領先水平。

微調-InternLM全參數微調、XTuner輕量級微調

InternLM支持對模型進行全參數微調,支持豐富的下遊應用。同時,低成本大模型微調工具箱XTuner也在近期开源,支持多種大模型及LoRA、QLoRA等微調算法。

通過XTuner,最低僅需 8GB 顯存即可對7B模型進行低成本微調,在24G顯存的消費級顯卡上就能完成20B模型的微調。

部署-LMDeploy支持十億到千億參數語言模型的高效推理

LMDeploy涵蓋了大模型的全套輕量化、推理部署和服務解決方案,支持了從十億到千億級參數的高效模型推理,在量等性能上超過FasterTransformer、vLLM和Deepspeed等社區主流开源項目。

評測-OpenCompass一站式、全方位大模型評測平台

OpenCompass大模型評測平台構建了包含學科、語言、知識、理解、推理五大維度的評測體系,支持超過50個評測數據集和30萬道評測題目,支持零樣本、小樣本及思維鏈評測,是目前最全面的开源評測平台。

自7月發布以來,受到學術界和產業界廣泛關注,目前已爲阿裏巴巴、騰訊、清華大學等數十所企業及科研機構廣泛應用於大模型研發。

應用-Lagent輕量靈活的智能體框架

書生·浦語團隊同時开源了智能體框架,支持用戶快速將一個大語言模型轉變爲多種類型的智能體,並提供典型工具爲大語言模型賦能。

Lagent集合了ReAct、AutoGPT 及ReWoo等多種類型的智能體能力,支持智能體調用大語言模型進行規劃推理和工具調用,並可在執行中及時進行反思和自我修正。

基於書生·浦語大模型,目前已經發展出更豐富的下遊應用,將於近期陸續向學術及產業界分享。

面向大模型掀起的新一輪創新浪潮,商湯科技堅持原創技術研究,通過前瞻性打造新型人工智能基礎設施,建立大模型及研發體系,持續推動AI創新和落地,引領人工智能進入工業化發展階段,同時賦能整個AI社區生態的繁榮發展。

本文作者可以追加內容哦 !

標題:性能超越开源模型標杆Llama2-70B,書生·浦語大模型InternLM-20B开源發布

地址:https://www.utechfun.com/post/265360.html