作者|孫鵬越

編輯|大 風

你敢相信?ChatGPT已經通過圖靈測試了!

甚至不是最新的GPT-4o,老版本GPT-3.5和GPT-4就已經打破人類和AI的最後一層限制。

“圖靈測試”由計算機科學家艾倫?圖靈在1950年提出。他將人工智能給出了一個完全可操作的定義:如果一台機器輸出的內容和人類大腦別無二致的話,那么我們就沒有理由堅持認爲這台機器不是在“思考”。

“圖靈測試”和“機器人三定律”,一直被人類世界視爲保護人類的最後屏障。

就連“AI講師”周鴻禕,都在最近的社交平台上大談AI滅世論,將AI焦慮拉到極致。

在2024年,以OpenAI爲首的大模型公司,真的能打开毀滅人類社會的潘多拉魔盒嗎?

“AI滅世論”引發焦慮

從上世紀开始,通過圖靈測試就成爲人類在AI領域爲之奮鬥的裏程碑目標。

可真的有AI通過測試後,人類的惶恐卻大過於驚喜。

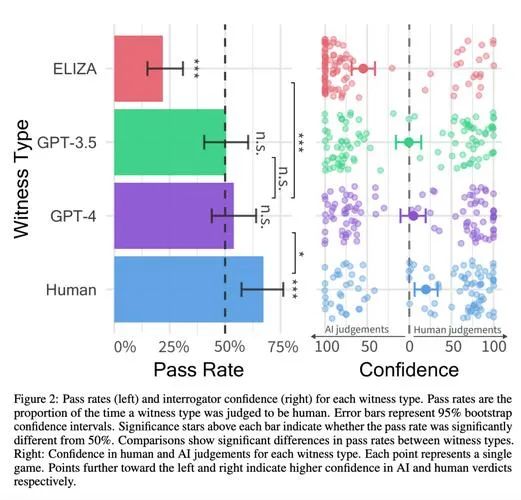

加州大學研究人員招募了500名參與者,讓他們與四位“對話者”進行五分鐘的交流,這四位“對話者”分別是:真人、上世紀60年代的初代聊天機器人ELIZA、GPT-3.5和GPT-4。

參與者在對話結束後,需判斷對方是人還是機器。

評估對象通過率(左) 評估者信任度(右)

結果顯示,真人被正確辨認的比例則爲67%;ELIZA只有22%;GPT-4和GPT-3.5則高達54%、50%。

這項測試無疑是非常可怕,真人和GPT-4的差距僅有12%!

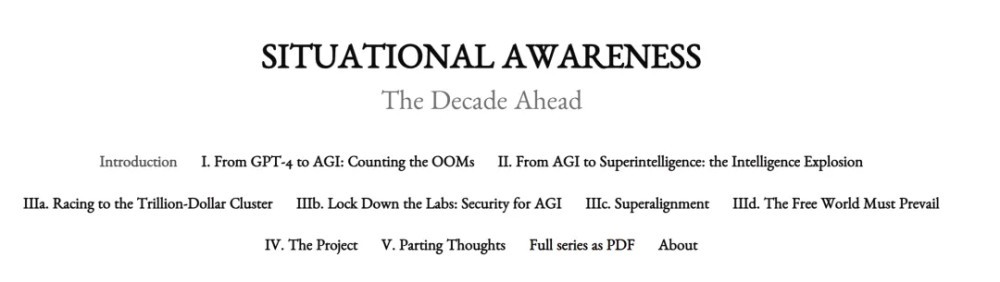

前OpenAI“超級對齊團隊”成員利奧波德·阿申布倫納(Leopold Aschenbrenner),曾在在社交平台披露出來的一份長達165頁的PDF文檔,對外界發出警告。

阿申布倫納表示,AI在過去10年深度學習的進步速度非常驚人。僅僅10年前,AI識別簡單圖像的能力就已經是革命性的。但如今,人類不斷嘗試提出新穎的、更難的測試,但每個新的基准測試都很快被AI所破解。

過去,破解廣泛使用的基准測試,AI需要數十年的時間,而現在只要幾個月。

而圖靈測試雖然名氣大,但從問題深度和難度上,並不如當下最困難的基准測試,也就是類似GPQA的測試,內容是博士級別的生物、化學和物理問題。

阿申布倫納估計,GPT-4進化到GPT-4o,或者到GPT-5模型迭代後,這一基准測試也將作廢。

爲什么人類設置的難題,會這么快被AI所破解?原因就是,AI學習能力真的太快了!

來源:利奧波德·阿申布倫納

2019年發布的GPT-2模型,智力水平僅僅於學齡前兒童相仿,只能簡單串起一些看似合理的句子,但是卻無法從1數到5,也無法完成總結類任務;

2020年發布的GPT-3模型,智力水平大致達到了小學生的水平,能生成篇幅更長的模型,並能完成一些基礎的算術任務和語法糾錯;

2022年發布的GPT-4模型,智力水平就能與較爲聰明的高中生相似,能編寫復雜的代碼並進行迭代調試,還能完成高中數學競賽題。

等到2024年,更先進GPT-4o,更是完成了對GPT-4的全方位超越。

相比較人類,正常人類從小學提升到初中,需要六年的時間;初中提升到高中,又需要三年的事件。

而AI的進化,則是兩年一個台階的越級進化,遠遠超過正常人類的水平。

超級人工智能時代

“在2027年,我們就有極大可能實現AGI(超級人工智能)。”

這是阿申布倫納的推斷,他的數據支撐是GPT-2到GPT-4的模型迭代趨勢。

從2019-2022年的4年時間裏,ChatGPT算力和算法效率都在以每年0.5個數量級(1個數量級=10倍)的速度發展。

再加上可能出現的釋放模型性能的技術突破,等到了2027年,AGI(超級人工智能)時代就會降臨,AI工程師完全可以取代人類工程師的所有工作。

AI的“超級進化”,背後是算力與資源的巨額消耗。

AI研究機構Epoch AI評估報告顯示,GPT-4訓練使用的原始計算量比GPT-2多約3000-10000倍。

這無疑是個可怕的數據,據阿申布倫納估計,到2027年底,將會出現2個數量級的算力增長,用電量相當於美國一個中小型的州的用電量。

也就是說,要拿一個省份的用電量,來支撐起一個AI大模型的日常訓練,這還是GPT-4的水准,還遠不到AGI(超級人工智能)的標准。

周鴻禕對阿申布倫納的言論並不認同,甚至有些“不切實際,更像是科幻小說”。

他表示,如果一個AGI(超級人工智能)的誕生就需要多個省份的電力資源,那么有10個以上的AGI,就能把整個地球的資源抽幹殆盡。

周鴻禕

周鴻禕給出了自己對AI的擔憂,他認爲如果在未來誕生出一個AGI,它就會取代人類工程師負責對AI大模型的开發,那么就會有一個24小時日以繼夜工作、讓算法和技術突破的更快,形成極爲誇張的正循環。

在“機器人改造機器人”“機器人改造算法”的模式下,AI的智力水平會從人類進化到超人,那么就會上演“硅基生物VS碳基生物”的好萊塢戲碼。

雖然周鴻禕反對阿申布倫納的言論,但同樣認爲智能大爆炸之後的“超級智能時代”,將是人類歷史上最動蕩、最危險、最緊張的時期。

這並不是周鴻禕在社交平台上,第一次對AI領域充斥着憂慮。早在2023年年初,GPT-4剛剛火遍全球的時候,周鴻禕就已經表達過對AI安全的擔憂。

周鴻禕表示:原來的人工智能給人的感覺像“人工智障”,雖然能做一些技術比如人臉識別、語音識別,但並不能理解你說的什么。但是ChatGPT模型不僅能夠通過圖靈試驗,而且它有自己的人設、自己的觀點,按照進化速度、摩爾定律,如果進一步訓練下去,ChatGPT也許就能實現自我意識的突破。

一旦自我意識突破,它就有可能控制全網的電腦,就會認爲比人類高明很多。在它眼裏,人類這個物種其實無論從存儲、算力、反應能力、知識面上比它差太遠,它就能反過來奴役人類,科幻正離現實越來越近。

作爲360的創始人,AI安全問題,周鴻禕的顧慮更多。

無人在意的AI安全

OpenAI作爲AI時代的領頭羊,面對AI安全的全球輿論,它做了什么嗎?

顯然是沒有的,甚至OpenAI還在今年解散了負責AI安全的“超級對齊團隊”。

在去年,OpenAI首席科學家伊利亞·蘇斯克沃就因爲AI安全問題,對CEO山姆·奧特曼進行彈劾,但最終還是山姆·奧特曼笑到最後,伊利亞·蘇斯克沃被趕出公司。

伊利亞·蘇斯克沃離开OpenAI後,在6月20日宣布成立新公司SSI(超級安全智能Safe SuperIntelligence)。

最在意AI安全的伊利亞·蘇斯克沃離職,上文提到了利奧波德·阿申布倫納就以“泄密”爲由,被OpenAI同樣趕出了公司。

這也是他在社交平台發布165頁的文檔,曝光OpenAI的原因。

甚至,曝光OpenAI的吹哨人,還不止阿申布倫納一人,在上個月,有一批OpenAI的前員工和現員工聯合起來,公开發表了一封聯名信,聲明OpenAI缺少監管,人工智能系統已經能對人類社會造成嚴重危害,未來甚至能“滅絕人類”。

雖然“滅絕人類”這個說法過於驚悚,但在解散超級對齊團隊之後,OpenAI GPT商店充斥着垃圾郵件,並違反平台的服務條款從YouTube抓取數據。

看到AI安全在OpenAI的地位,越來越多的安全研究人員,選擇另謀高就。

艾隆·馬斯克也忍不住抨擊山姆·奧特曼:“安全並不是OpenAI的首要任務。”

山姆·奧特曼

對於外界的批評,山姆·奧特曼置若罔聞,他已經把全部精力用於推動OpenAI徹底轉向營利實體,不再由非營利性組織控制。

如果OpenAI轉型爲營利組織後,有限合夥人每年利潤分紅的限制就不復存在了,巨額回報激勵能夠進一步擴大合夥人範圍,也有利於OpenAI走向IPO。

也就是說,估值高達860億美元的OpenAI(約6244億人民幣),將能給山姆·奧特曼本人帶來更多的財富。

在Dollar面前,山姆·奧特曼毅然決然的放棄了AI安全。

原文標題 : AI統治人類,需要分幾步走?

標題:AI統治人類,需要分幾步走?

地址:https://www.utechfun.com/post/389322.html