“芯”原創——NO.51

搶佔AI腹地。

文 I 十巷

報道 I 芯潮 IC

ID I xinchaoIC

圖片來源 | Unsplash

前幾日,英偉達市值衝破3萬億美元,將蘋果公司甩在身後的故事還沒來得及回味。英偉達市值登頂全球第一的新聞再次登上各大熱搜(發稿前,英偉達市值已出現較大回落)。

作爲AI芯片巨頭,英偉達近年來可謂風光無限。

過去,我們看到了很多有關英偉達GPU和CUDA護城河的介紹。誠然,經過多年的投入,他們已經建立起了難以逾越的優勢。但除此以外,英偉達還有很多隱形護城河,其中,互聯技術也是其在AI浪潮中取得成功過程中不可忽視的一大關鍵。

日前,黃仁勳在Computex的主題演講中,再次透露了未來幾年GPU和互連技術的路线圖;而另一邊,八大芯片巨頭抱團取暖,成立UALink推廣組意在制定行業標准,以打破市場領導者英偉達的壁壘和壟斷。

如今大模型時代來臨,隨着越來越多的加速器被集成到一起,性能損耗和帶寬瓶頸逐漸顯現,如何高效傳輸數據成爲了AI芯片互聯領域亟待攻克的瓶頸。

在此背景下,行業廠商加速入局,試圖搶佔GPU互聯市場的新高地。

爲什么需要GPU互聯技術?

01

長期以來,馮·諾依曼架構面臨的一個核心挑战是CPU的計算速度與內存訪問速度之間的不匹配,尤其是與存儲設備的速度相比更是天壤之別。這就是業界著名的“內存牆”,其不均衡的發展速度對日益增長的高性能計算形成了極大制約,成爲訓練大規模AI模型的瓶頸。

與此同時,隨着高性能存儲技術的進步,計算機組件間通信的帶寬再次成爲限制性能提升的關鍵因素。從“Pascal”P100 GPU一代到“Blackwell”B100 GPU一代,八年間GPU的性能提升了1053倍。

在此趨勢下,GPU作爲AI時代的核心處理器,單卡GPU算力和顯存有限,無法滿足訓練需求。爲適應算力需求,需要聯合大量GPU甚至多台服務器協同工作,分布式訓練訴求快速提升。

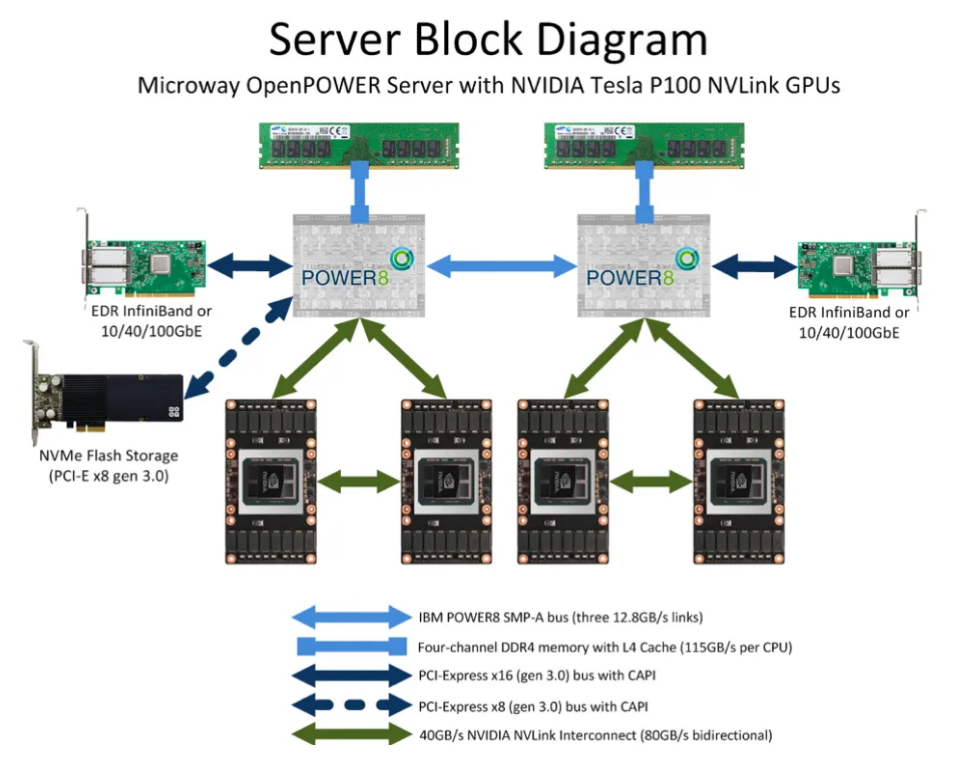

GPU服務結構

在分布式系統中,大模型訓練對算力基礎設施的要求從單卡拓展到了集群層面,這對大規模卡間互聯的兼容性、傳輸效率、時延等指標提出了更高的要求。

自此,GPU互連技術开始擔任重要角色。

GPU互聯技術,百家爭鳴

02

衆所周知,總线是數據通信必備管道,是服務器主板上不同硬件互相進行數據通信的管道,對數據傳輸速度起到決定性作用。

目前最普及的總线協議爲英特爾2001年提出的PCIe(PCI-Express)協議,PCIe主要用於連接CPU與其他高速設備如GPU、SSD、網卡、顯卡等。2003年PCIe1.0版本發布,後續大致每過三年會更新一代,目前已經更新到6.0版本,傳輸速率高達64GT/s,16通道的帶寬達到256GB/s,性能和可擴展性不斷提高。

AIGC的發展極大刺激算力需求的增加,GPU多卡組合成爲趨勢。GPU互聯的帶寬通常需要在數百GB/S以上,PCIe的數據傳輸速率成爲瓶頸,且PCIe鏈路接口的串並轉換會產生較大延時,影響GPU並行計算的效率和性能。

同時,由於PCIe總线樹形拓撲和端到端傳輸方式限制了連接數量和速度,GPU發出的信號需要先傳遞到PCIe Switch來拓展,PCIe Switch涉及到數據的處理又會造成額外的網絡延時,此外PCIe總线與存儲器地址分離,每次訪問內存會加重網絡延遲。

因此,PCIe的傳輸速率和網絡延遲無法滿足需求,限制了系統性能。

在市場需求和技術驅動下,GPUDirect/NVLink/Infinity Fabric/高速以太網/InfiniBand等GPU互聯技術爭相推出,“百家爭鳴”時代开啓。

GPUDirect

在這個過程中,英偉達率先推出了能夠提升GPU通信性能的技術——GPUDirect,使GPU可以通過PCIe直接訪問目標GPU的顯存,可實現GPU與其他設備之間直接通信和數據傳輸的技術,大大降低了數據交換的延遲。

傳統上,當數據需要在GPU和另一個設備之間傳輸時,數據必須通過CPU,從而導致潛在的瓶頸並增加延遲。使用GPUDirect,網絡適配器和存儲驅動器可以直接讀寫GPU內存,減少不必要的內存消耗,減少CPU开銷並降低延遲,從而顯著提高性能。GPUDirect技術包括GPUDirect Storage、GPUDirect RDMA、GPUDirect P2P和GPUDirect 視頻。

但受限於PCIe總线協議以及拓撲結構的一些限制,無法做到更高的帶寬。此後,英偉達提出了NVLink總线協議。

NVLink成爲主流

過去,我們看到了很多有關英偉達GPU和CUDA護城河的介紹。誠然,經過多年的投入,他們已經建立起了難以逾越的優勢。但除此以外,英偉達還有很多隱形護城河,NVLink就是其中之一,一個爲GPU到GPU互聯提供高速連接的技術。

NVLink是一種英偉達提出的高速GPU互聯協議,用於連接多個GPU之間或連接GPU與其他設備(如CPU、內存等)之間的通信。它允許GPU之間以點對點方式進行通信,具有比傳統的 PCIe 總线更高的帶寬和更低的延遲,爲多GPU系統提供更高的性能和效率。

對比傳統PCIe總线協議,NVLink主要在三個方面做出較大改變:

1)支持網狀拓撲目,解決通道有限問題;

2)統一內存,允許GPU共享公共內存池,減少GPU之間復制數據的需要,從而提高效率;

3)直接內存訪問,不需要CPU參與,GPU可直接讀取彼此的內存,從而降低網絡延遲。

英偉達官方表示,NVLink是全球首創的高速GPU互連技術。作爲一種總线及其通信協議,NVLink採用點對點結構、串列傳輸,用於連接GPU與支持NVLink技術的CPU,在內存牆無法突破的情況下,最大化提升CPU和GPU之間通信的效率,也可用於多個英偉達GPU之間的高帶寬互連。使用NVLink連接兩張NVIDIA GPU,即可彈性調整記憶體與效能,滿足專業視覺運算最高工作負載的需求。

自2014年开始,英偉達在其GPU中引入了NVLink互聯技術。

彼時,爲帶寬不足而發愁的英偉達,與當時坐擁更高帶寬POWER CPU的IBM一拍而合,合作开發了第一代NVLink。

回顧NVLink技術的發展歷程:

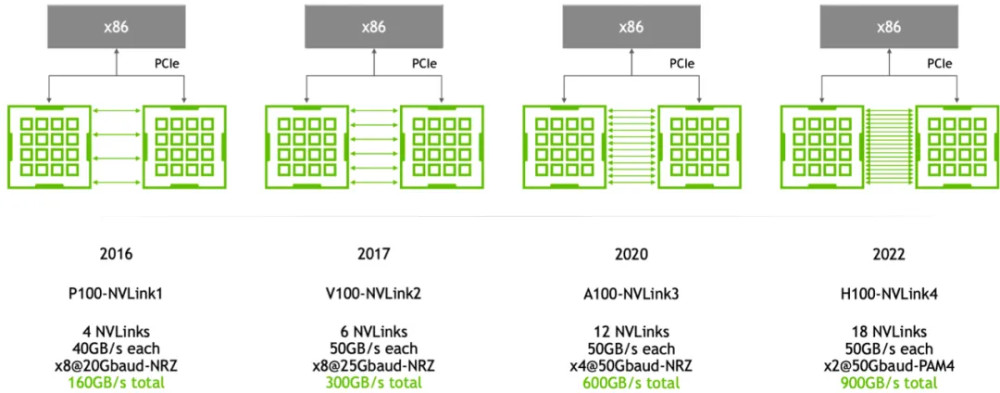

2014年,NVLink 1.0發布並在P100 GPU芯片之間實現,兩個GPU之間有四個NVLink,每個鏈路由八個通道組成,每個通道的速度爲20Gb/s,系統整體雙向帶寬爲160GB/s,是PCIe3 x16的五倍,這使得數據在CPU內存與GPU顯存之間的移動速度得到了大幅提升,從而讓GPU加速的應用能夠大幅提升運行速度。

伴隨着P100、V100等計算卡的推出,NVLink迎來了自己的高速發展。

2017年,英偉達推出了第二代NVLink,兩個V100 GPU芯片之間通過六個NVLink 2.0連接,每個鏈路也是由八個通道組成,每個通道的速度提升至25Gb/s,從而實現300GB/s的雙向系統帶寬,幾乎是NVLink1.0的兩倍。

同時,爲了實現八個GPU之間的完全互連,解決GPU之間通訊不均衡問題,英偉達還引入了NVSwitch技術。

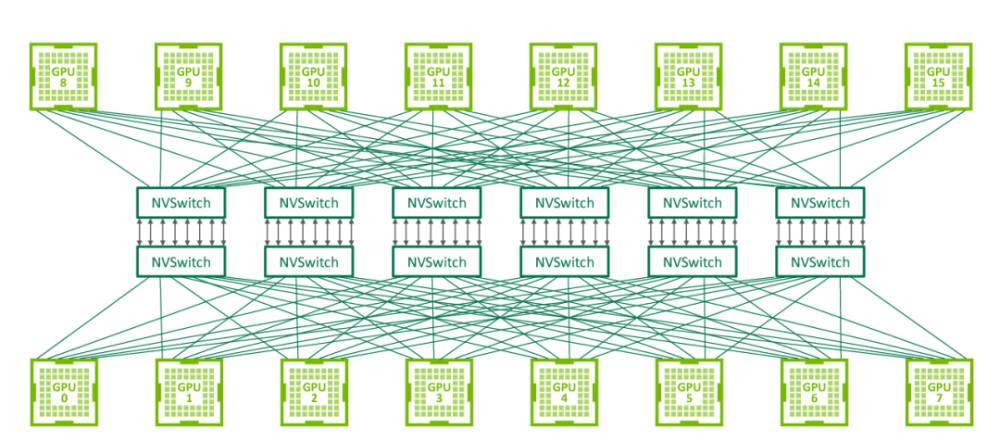

NVSwitch是英偉達在2018年發布的一項技術,旨在解決單服務器中多個GPU之間的全連接問題。NVSwitch允許單個服務器節點中多達16個GPU實現全互聯,這意味着每個GPU都可以與其他GPU直接通信,無需通過CPU或其他中介。

NVSwitch全連接拓撲(圖源:nextplatform)

NVSwitch1.0有18個端口,每個端口的帶寬爲50GB/s,總帶寬爲900GB/s。每個NVSwitch保留兩個用於連接CPU的端口。通過使用6個NVSwitch,可以在8個GPU V100芯片之間建立一個全連接的網絡。

2020年,推出NVLink 3.0技術。它通過12個NVLink連接連接兩個GPU A100芯片,每個鏈路由四個通道組成。每個通道以50Gb/s的速度運行,從而產生600GB/s的雙向系統帶寬,是NVLink2.0的兩倍。隨着NVLink數量的增加,NVSwitch上的端口數量也增加到36個,每個端口的運行速度爲50GB/s。

2022年,NVLink技術升級到第四代,允許兩個GPU H100芯片通過18條NVLink鏈路互連。每個鏈路由2個通道組成,每個通道支持100Gb/s(PAM4)的速度,從而使雙向總帶寬增加到900GB/s。NVSwitch也升級到了第三代,每個NVSwitch支持64個端口,每個端口的運行速度爲 50GB/s。

值得一提的是,在第四代NVLink發布時,英偉達正式將其稱爲NVLink-C2C ,此時NVLink已經升級爲板級互連技術,它能夠在單個封裝中將兩個處理器連接成一塊超級芯片。

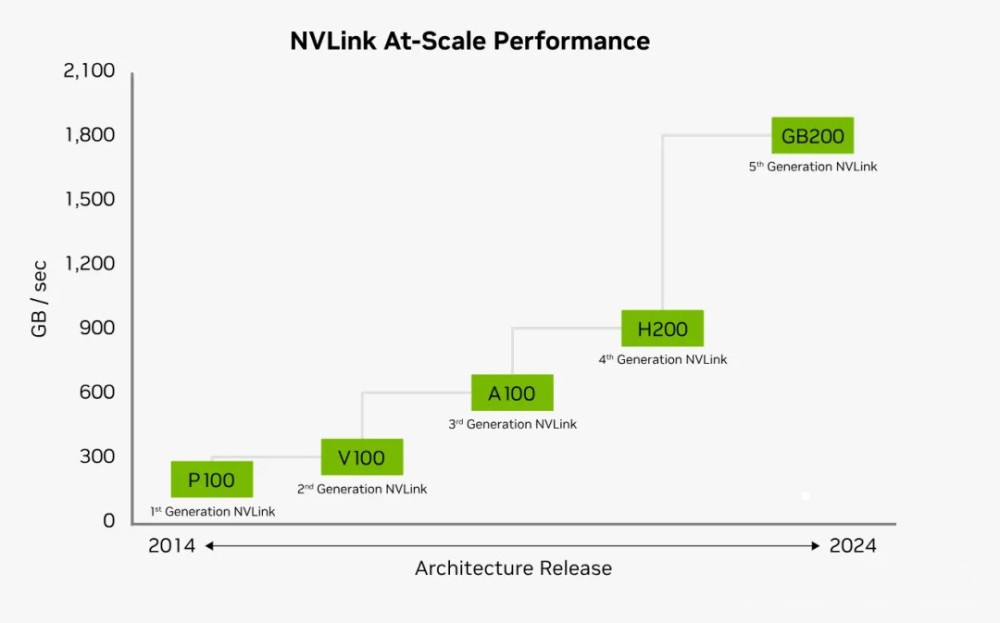

第一代到第四代NVLink演進脈絡(圖源:nextplatform)

2024年,隨着英偉達全新Blackwell架構的發布,NVLink 5.0也隨之而來。

NVLink 5.0以100GB/s的速度在處理器之間移動數據。每個GPU有18個NVLink連接,Blackwell GPU將爲其他GPU或Hopper CPU提供每秒1.8TB的總帶寬,這是NVLink 4.0帶寬的兩倍,是行業標准PCIe Gen5總线帶寬的14倍。NVSwitch也升級到了第四代,每個NVSwitch支持144個NVLink 端口,無阻塞交換容量爲14.4TB/s。

圖源:英偉達

從上圖可以看到,每一代NVLink的更新,其每個GPU的互聯帶寬都是在不斷的提升,其中NVLink之間能夠互聯的GPU數,也從第一代的4路到第四代/第五代的18路。每個NVLink鏈路的速度也由第一代的20Gb/s提升至目前的1800Gb/s。

此外,盡管擁有極高的帶寬,NVLink卻在每比特數據的傳輸上比PCIe節能得多。

NVLink和NVSwitch這兩項技術的引入,爲GPU集群和深度學習系統等應用場景帶來了更高的通信帶寬和更低的延遲,從而提升了系統的整體性能和效率。

隨着下一代AI算法等先進計算的需求不斷增長,可以期待NVLink的功能進一步增強。無論是帶寬的增加還是促進GPU之間更好合作的新功能,NVLink或其後繼者無疑仍將是滿足未來計算需求的核心。

可見,當競爭對手還在追趕英偉達GPU性能時,英偉達已經在發力整個數據中心的構架層創新,通過提供更快的芯片互聯,更強的算力調度能力,將GPU打包成綜合性能無人能敵的數據工廠,交付給全世界。

AMD加碼Infinity Fabric

AMD也推出了與英偉達NVLink相似的Infinity Fabric技術。

Infinity Fabric由兩部分組成:數據布线(Data Fabric)和控制布线(Control Fabric),數據布线用於處理器內部和處理器之間的數據傳輸;控制布线則負責處理器的功耗、時鐘和安全性等方面的管理,該技術支持芯片間、芯片對芯片以及節點對節點的數據傳輸。

Infinity Fabric的主要特點包括:

高效率:Infinity Fabric設計用於提供高效率的數據傳輸,支持多個設備之間的高速通信;

模塊化:Infinity Fabric支持AMD的Chiplet架構,允許不同功能的芯片模塊通過高速互連進行組合;

內存共享:Infinity Fabric支持CPU和GPU之間的內存共享,有助於提高異構計算效率;

擴展性:Infinity Fabric的設計允許它隨着技術進步和需求增長而擴展。

Infinity Fabric是AMD在其“Zen微架構”中引入的一個關鍵特性,旨在提高整體系統性能,特別是在多核心處理器和數據中心環境中。

圖源:AMD

據悉,AMD最新的AI加速器Instinct MI300X平台,就是通過第四代Infinity Fabric鏈路將8個完全連接的MI300X GPU OAM模塊集成到行業標准OCP設計中,爲低延遲AI處理提供高達1.5TB HBM3容量。第四代Infinity Fabric支持每通道高達32Gbps,每鏈路產生128GB/s的雙向帶寬。

不同於英偉達NVLink僅限於內部使用,AMD已經开始向合作夥伴开放其Infinity Fabric生態系統,完善生態布局。

芯片巨頭組團,向英偉達NVLink开战

盡管GPU互聯技術看上去種類多樣,但主要技術路线還是牢牢掌握在英偉達手中,業界一直期待有某種“超級”競爭對手聯盟來填補非Nvidia互聯技術或集群的空缺。

而這也正是UALink推出的重要原因,掀起對標英偉達NVLink的波瀾。

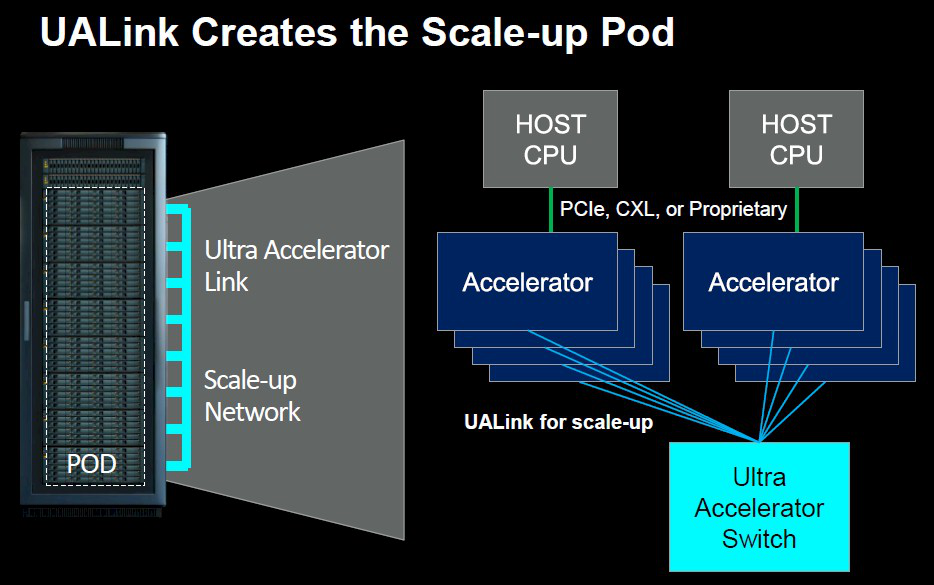

文章开頭提到,AMD、博通、思科、Google、惠普、英特爾、Meta和微軟在內的八家公司宣告,爲人工智能數據中心的網絡制定了新的互聯技術UALink(Ultra Accelerator Link)。通過爲AI加速器之間的通信建立一個开放標准,以挑战英偉達在AI加速器一家獨大的地位。

據消息披露,UALink提議的第一個標准版本UALink 1.0,將連接多達1024個GPU AI加速器,組成一個計算“集群”,共同完成大規模計算任務。

根據UALink推廣組的說法,基於包括AMD的Infinity Fabric在內的“开放標准”,UALink 1.0將允許AI加速器所附帶的內存之間的直接加載和存儲,並且與現有互連規範相比,總體上將提高速度,同時降低數據傳輸延遲。

圖源:nextplatform

據悉,UALink將在第三季度成立一個UALink聯盟,定義AI計算艙中加速器和交換機之間擴展通信的高速、低延遲互連,以監督UALink規範未來的發展。UALink 1.0將在同期向加入聯盟的公司提供,而具有更高帶寬的更新規範UALink 1.1,計劃在2024年第四季度推出。這些規範將支持多種傳輸,包括PCI-Express和以太網。

UALink聯盟旨在創建一個开放的行業標准,允許多家公司爲整個生態系統增加價值,從而避免技術壟斷。

該技術的潛在優勢在於讓業內所有人都有機會與英偉達保持同步,其不僅適用於大型企業,也爲行業中每個人打开了一扇門,讓他們不僅在規模上,而且在創新方面都能跟上英偉達的步伐。

多機互聯:

InfiniBand與以太網絡並存

03

此外,在分布式系統中,根據連接層級的不同可以分爲單卡、多卡、多機互聯,在大規模計算中,單機多卡場景下多使用GPU Diect、NVLink等高帶寬通信網絡技術,分布式場景下的多機之間的連接(即服務器互聯)通常採用RDMA網絡。

隨着大數據分析、AI計算等應用對算力需求巨大,上面提到的單機形態已經逐漸不能滿足用戶需求,多機多卡的計算成爲常態,多機間的通信是影響分布式訓練的一個重要指標。

當前業界常提到的多機之間GPU卡的通信技術,主要有RDMA、GPU Direct RDMA和InfiniBand等技術。

RDMA是一種繞過遠程主機而直接訪問其內存中數據的技術,解決網絡傳輸中數據處理延遲而產生的一種遠端內存直接訪問技術。

簡單理解,RDMA就像一個去掉中間商的技術,讓數據能夠快速獲取。不再在操作系統、CPU等環節浪費時間。

目前RDMA有三種不同的技術實現方式:Infiniband、RoCE、iWARP,後兩者是基於以太網的技術。

長期以來,以太網一直是計算機網絡的主力,例如英特爾的Gaudi系列AI處理器在芯片上集成了幾十個100Gb以太網連接;相比之下,英偉達通過收購Mellanox獨佔了高性能InfiniBand互連市場。

InfiniBand是一種开放標准的網絡互連技術,具有高帶寬、低延遲、高可靠性的特點,在英偉達的AI工廠和超級電腦中扮演着至關重要的角色。

InfiniBand在人工智能等數據密集型任務中通常優於以太網。據Dell'Oro估計,約90%的AI部署都是使用的InfiniBand,而不是以太網。這些部署將英偉達的網絡收入推至每年100億美元。

英特爾,押注以太網

英特爾的Gaudi AI芯片則一直沿用傳統的以太網互聯技術。

據了解,Gaudi 2每個芯片使用了24個100Gb以太網鏈路;Gaudi 3將這些鏈路的帶寬增加了一倍,使用了24個200Gbps以太網RDMA NIC,使芯片的外部以太網I/O總帶寬達到8.4TB/秒。

前不久,英特爾還宣布正在开發一款用於超以太網聯盟(UEC)兼容網絡的AI NIC ASIC以及一款AI NIC小芯片,這些創新的AI高速互聯技術將用於其未來的XPU和Gaudi 3處理器。這些創新旨在革新可大規模縱向和橫向擴展的AI高速互聯技術。

超以太網聯盟(UCE),是一個由英特爾、AMD、HPE、Arista、Broadcom、思科、Meta和微軟爲打破英偉達壟斷而共同創建的組織。UCE認爲,通過調整以太網的架構,可以讓以下一代高速太網的性能像InfiniBand網絡一樣好,並更具成本與开放性優勢,從而讓更多的企業加入進來。

一直以來,英特爾都希望通過採用純以太網交換機來贏得那些不想投資InfiniBand等專有互連技術的客戶。

雖然InfiniBand在很多情況下表現都不錯,但它也有缺點,比如只能在特定範圍內使用(例如InfiniBand適合那些運行少量非常大的工作負載(例如GPT3或數字孿生)的用戶,但在更加動態的超大規模和雲環境中,以太網通常是首選),而且成本也不低,將整個網絡升級到InfiniBand需要大量投資。相比之下,以太網因爲兼容性強,成本適中,以及能夠勝任大多數工作負載,所以在網絡技術領域裏一直很受歡迎,建立了一個龐大的“以太網生態”。

AMD也表示將重點支持以太網,特別是超以太網聯盟。雖然Infinity Fabric提供了GPU之間的一致互連,但AMD正在推廣以太網作爲其首選的GPU到GPU網絡。

綜合來說,高性能遠距離傳輸的战場裏,如今僅剩InfiniBand和下一代高速以太網兩大陣營,雙方各有優劣勢。

據Dell'Oro預計,在可預見的未來InfiniBand將保持在AI交換領域的領先地位,但在雲和超大規模數據中心的推動下,以太網將取得大幅增長,預計到2027年將佔據約20%的市場份額。

互聯技術未來創新趨勢

04

不可否認,上述這些互聯技術都已是目前最好的選擇。但能夠預見到是,隨着未來計算數據的爆炸式增長、神經網絡復雜性不斷增加,以及AI技術的加速演進,對更高帶寬的需求還在繼續增長。

當前這些互聯技術將不可避免的存在性能瓶頸。

例如英偉達的NVLink雖然速度快,但功耗也相當高;AMD的Infinity Fabric適合於芯片內部連接,對於芯片之間的互聯效率並不理想等。

對此,光互聯憑借高帶寬、低功耗等優勢,幾乎成爲未來AI互聯技術公認的發展方向。

在光互聯之路上,谷歌、博通、Marvell、思科以及Celestial AI、Ayar Labs、Lightmatter、Coherent、曦智科技等新老廠商都在不斷發力,相繼取得了一系列成果。

在衆多廠商的參與下,互聯技術未來將會迎來快速發展。尤其是圍繞光電共封裝和硅光子中繼層技術的光互連,正在成爲AI領域的熱門賽道。

結語

05

大模型時代,算力就是生產力。

大模型的背後意味着巨大的計算資源,模型大小和訓練數據大小成爲決定模型能力的關鍵因素。當前,市場的主力玩家們利用數萬個GPU構建大型人工智能集群,以訓練LLM。

在此趨勢下,分布式通信技術正以前所未有的速度推動着人工智能的進步。

從PCIe到NVLink、Infinity Fabric再到InfiniBand、以太網和UALink,這些技術通過高帶寬、低延遲的數據傳輸,實現了GPU或AI服務器之間的高速互聯,在提升深度學習模型的訓練效率和計算性能方面發揮了至關重要的作用。

在AI技術的飛速發展中,互聯技術作爲AI時代的橋梁,也正在經歷前所未有的創新與變革。

免責聲明:

1、本文內容爲芯潮IC原創,內容及觀點僅供參考,不構成任何投資建議;文中所引用信息均來自市場公开資料,我司對所引信息的准確性和完整性不作任何保證。

2、本文未經許可,不得翻版、復制、刊登、發表或引用。如需轉載,請聯系我們。

原文標題 : GPU性能提升1000倍背後,英偉達掀翻行業的另一把“鐮刀”

標題:GPU性能提升1000倍背後,英偉達掀翻行業的另一把“鐮刀”

地址:https://www.utechfun.com/post/389314.html