當全球還在文字產生文字,以及文字產生圖片時,OpenAI 就推出影片產生模型 Sora。簡單講,是用文字指令或靜態影像產生長達 1 分鐘影片的擴散模型,且可含精細複雜場景、生動角色表情及複雜鏡頭運動──它做到市面模型還做不到的事。

而Sora如何做到的?《品玩》曾第一時間據僅有資訊判斷:

簡單理解,就是語言模型夠強大後,泛化能力直接學習圖像資料和模式,還可直接用學來的圖片產生模型最能理解的方式,下指令給使用引擎等強大成熟的影片產生技術的視覺模型模組,最終產生我們看到的真實「理解」物理世界的影片。

之後OpenAI公布Sora技術報告《》,印證了《品玩》推斷。接下來就從報告解讀Sora的技術。

用大語言模型思路理解影片

Sora設計靈感來自大語言模型,因核心功能之一是透過程式碼將多種文字形式統一。OpenAI為了訓練Sora,也將各類視覺資料轉化為統一表示法。

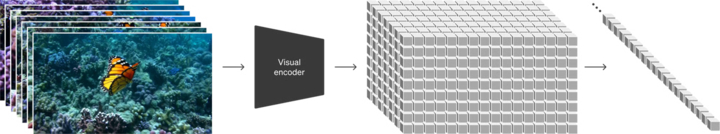

正式了解Sora前,先解釋「塊」(patches)概念,有點類似大語言模型的token,「塊」指將影像或視訊影格分割成一系列小區塊,是模型處理和理解原始資料的基本單元。

對影片模型而言,區塊不僅含局部空間資訊,還有時間軸連續變化資訊。模型可透過學習「塊」的關係捕捉運動、色彩變化等複雜視覺特徵,並重建新序列,有助模型理解和產生連貫動作與場景變化,使影片內容品質優秀。

OpenAI又在塊的基礎上,壓縮到低階潛在空間,再分解為「時空區塊」(spacetime patches)。

(Source:)

潛在空間是三年前出現的概念,指高階資料經過某種數學變換(如編碼器或降維技術)後映射至低階空間,每點通常對應原始高階資料的潛在表示或抽象特徵向量。但最佳化強大擴散模型往往需要消耗數百個GPU日計算資源,且因序列評估性質,推理成本較高。本質上來講,潛在空間就是能在降低複雜性和保留細節間達到近乎最優的平衡點,大大提升視覺。

時空塊則是指從視訊幀序列提取、有固定大小和形狀的空間:時間區域。相較塊,時空塊強調連續性,模型可透過時空塊觀察影片內容隨著時間和空間變化的規律。

為了製造時空塊,OpenAI訓練神經網路,降低視覺資料維度,稱為影片壓縮網路(Video compression network),接受原始影片輸入,並輸出時間和空間都壓縮過的潛在表示。Sora在壓縮後潛在空間訓練和產生新影片,OpenAI也訓練對應解碼器模型,將潛在向量映射回畫素空間。

剛才提到「塊」非常接近token,那塊作用也應該和token差不多。對壓縮輸入影片,OpenAI直接提取一系列塊當成Transformer token用,然後這些時空塊會再編碼並傳給Transformer網路學習全局自注意力。最後用Transformer的強大能力處理並產生不同屬性的影片內容。

此方案同樣適用圖片,因可視為僅一幀的影片。基於區塊的表示法使Sora能訓練不同解析度、時長和寬高比的影像。推理階段可透過適當大小網格排列隨機初始化區塊以控制產生影片的尺寸。

Sora模型介紹頁面雖然提到都是透過文字產生影片,但Sora也能接受其他類輸入,如圖片或影片,可達圖片產生影片、影片產生影片,使Sora能執行廣泛影像編輯,如製作完美循環播放影片、為靜態圖像添加動畫效果、向前或向後延展影片時間軸等。

實現物理世界「湧現」

長期訓練時OpenAI發現sora模型逐漸擁有新能力,稱為「3D一致性」,指Sora能產生動態視角影片,視角移動與旋轉後,人物及場景元素在3D空間仍可保持一致運動狀態。

這可能對人類來說沒什麼,但對人工智慧來說相當厲害。人工智慧理解3D物理世界的方式跟人類不一樣,是拓樸結構理解。這裡的拓樸結構不是電腦拓樸結構,而是拓樸學的拓樸結構。拓樸結構是幾何或空間的抽象描述,描述集合元素間的連接方式和空間屬性,不考慮特定度量或形狀,關注空間的點與點連結關係及空間整體形狀,而不是真實尺寸或角度等細節。

除此之外,既然影片視角發生變化,那對應紋理映射也要改變。Sora的真實感非常強,換句話說,紋理映射至拓樸結構就得非常準確,3D一致性能力使Sora能模擬現實世界人物、動物和環境某些方面。

讓人興奮帶點害怕的消息是,這些屬性並非透過為3D、物體等添加明確歸納偏壓而產生,純粹是規模效應。也就是說,是Sora自己根據訓練內容,判斷現實世界某些物理客觀規律,某種程度上,人類如果只是肉眼觀察,也很難達到這境界。

影片模型另一項重大挑戰,是在產生長影片時保持時間連貫,Sora也能有效模擬短程和長程依賴關係。如人物、動物或物體被遮蔽或離開畫面,Sora仍能保持這些元素存在視線外,等到視角轉換到能看到的時候,再將這些內容展現出來。同樣的,它能單一樣本產生同角色多個鏡頭,並整支影片都保持外觀一致。

這點沒什麼,因Sora是從Transformer模型孕育而來,Transformer本身就能透過全域自注意力機制等技術達成高連續性,Sora不過從影片闡述連續性而已。OpenAI得出結論:影片模型是建立通用世界模擬器的康莊大道。

甚至Sora目前能力表明,它能透過觀察和學習了解物理規律。

不過Sora若當成模擬器還有限制。OpenAI主頁列舉常見失效模式,如長時間採樣可能不連貫,物體異常等。從現有結果看,還無法準確模擬許多基本物理規律,如玻璃破碎及喫東西。物體狀態變化並不總是能正確模擬,這說明許多現實物理規則沒辦法透過訓練推斷。

(Source:)

上圖為報告核心資訊,OpenAI一如既往於模型和細節方面保持Close,不過又不停提到「大力出奇蹟」。

報告提到:大規模訓練時影片模型展現出許多有趣的能力,使Sora能模擬現實世界人類、動物和環境某些面向,沒有任何針對3D、物體等明確歸納偏見,純粹是規模效應現象。OpenAI顯然把Sora描述成一直堅持的Scaling law的又一次勝利──沒有多純粹原創的技術,很多早已存在,卻比所有人都篤定走下去,並用大量資源及規模驗證。

(本文由 授權轉載;首圖來源:)

延伸閱讀:

標題:揭密 Sora:用大語言模型理解影片,實現物理世界「湧現」

地址:https://www.utechfun.com/post/334007.html