從理論到實踐,大語言模型 LLM 完全體會長成什麼樣子?

很多人會說是基於自然語言深刻理解,但這點OpenAI GPT系列已做得很好。也有人討論AI Agent實踐可能性,但也沒有脫離自然語言範疇。生成式AI有兩方面,大語言模型是其一,著重理解人類語言,更廣泛的AIGC應用指以擴散模型為代表的跨模態轉換能力,也就是文生圖、文生影片等。

若結合兩者?許多人眼中,這就是下一代GPT,或說GPT完全體。最近出現在論文預印網arXiv的新加坡國立大學計算機學院引起人們注意,因設計出NExT-GPT模型試圖全面模態轉換。

(Source:,下同)

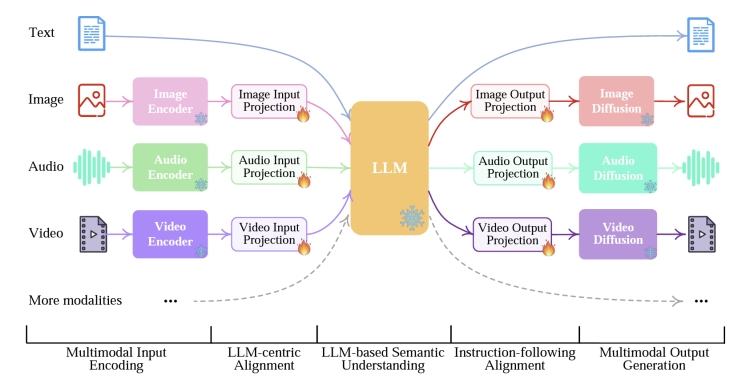

從上圖可見,NExT-GPT模型輸入和輸出端都能產生文字、圖片、音訊和視訊等多種形式,輸出端除了文字均使用對應不同模組的擴散模型。輸入和輸出轉換靠大模型執行。NExT-GPT模型樣式其實不僅符合人們試圖把生成式AI兩股力量:大語言模型和擴散模型結合的趨勢,甚至某種程度也符合人類直覺:大腦正是靠多模組自由轉換和互動理解認識世界。

所謂多模組轉換與大語言模型結合,並不是簡單用提示詞幫兩者「搭橋」,而是真正把多模組數據(向量)與語言數據結合,過程暢通後,等於大模型不僅學習理解人類語言,還能擴大至更多模組,成功的話將讓AI飛上天。

NExT-GPT結構一覽:兩個突破點

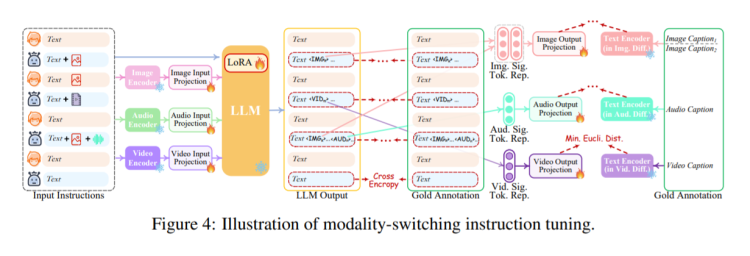

據說Google和OpenAI GPT5都在進行類似研究。之前先來看看NExT-GPT模型怎麼做到。NExT-GPT模型是把大模型與多模組搭配器及擴散模型解碼器連起來,僅投影層調整1%參數。論文創新處在創建名為MosIT的模組切換調整指令,以及專門針對跨模組轉換的資料庫。

NExT-GPT由三層組成,第一層是各種成熟編碼器編碼各種模組輸入,然後透過投影層映射成大語言模型能理解形式。第二層是開源大語言模型負責推理。大語言模型不僅會產生文本,還會產生獨特標記,指令解碼層輸出什麼模組內容。第三層將指令訊號經投影,對應不同編碼器產生內容。

為了降低成本,NExT-GPT利用現成編碼器和解碼器,最大限度減輕不同模組轉換時的「雜訊」,NExT-GPT利用ImageBind,是跨模組統一編碼器,這樣NExT-GPT不需管理太多異構模組編碼器,可統一將不同模組投影到大語言模型。

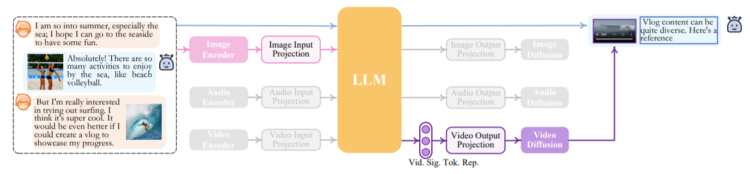

輸出階段,NExT-GPT使用各種成熟模型,包括影像產生Stable Diffusion,視訊產生Zeroscope,以及音訊合成AudioLDM。下圖是論文推理過程,可看到文字模式和訊號標記決定模組如何辨識、觸發及產生,灰色部分是沒有觸發的模組選項。

這涉及不同模組語義理解問題,因此對齊不可少。不過結構較清晰,NExT-GPT對齊很好達成。作者設計三層耦合結構,編碼端以大模型為中心對齊,解碼端則與指令對齊。對齊放棄讓擴散模型與大語言模型執行完整對齊過程,僅用文本條件編碼器,最小化大模型模式訊號標記與擴散模型文本的距離後,對齊僅基於純粹文字,因此量級很輕,大概1%參數需調整。

考慮到需讓NExT-GPT具備準確跨模組生成和推理能力,論文還引入MosIT,也就是Modality-switching Instruction Tuning模式切換指令微調,訓練基於5千個高品質樣本組成的資料庫。

訓練過程當然複雜,就不細說了,總之MosIT可重構輸入和輸出文字,讓NExT-GPT理解文字、圖像、視訊和音訊各種組合的複雜指令,十分接近人類理解和推理模式。

完全體要來了嗎?

目前NExT-GPT還具有許多的弱點,作者在論文中也提到了不少,例如非常容易想到的,四種模態對於真正的多模態完全體大模型來說種類還是有點太少,訓練MosIT的數據集的數量同樣有限。作者也努力透過不同規模大語言模型讓NExT-GPT適應更多場景。

另一個棘手問題更現實。儘管NExT-GPT展現出多模組能力的強大未來,但以擴散模型為代表的AIGC能力水準依然有限,影響整個NExT-GPT的表現。總體多模組AI有非常誘人的前景,因和應用場景及用戶需求更緊密吻合,大模型賽道目前熱度略下降,多模組AI給人巨大的想像空間。

NExT-GPT為點到點的多模組大模型,已具備多模組AI雛形,論文參數調整對齊及使用MosIT推理能力強化思路讓人印象深刻,甚至可說是邁向完全體AI的道路,已經有人踏出了第一步。

(本文由 授權轉載;首圖來源:)

標題:有人幫忙 OpenAI 做出 GPT-5 了?

地址:https://www.utechfun.com/post/265406.html