近日,在計算機圖形學頂會SIGGRAPH 2023現場,英偉達再度釋放深夜“炸彈”,大模型專用芯片迎來升級版本。

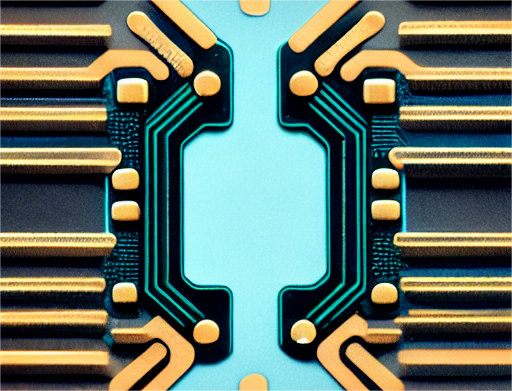

英偉達在會上發布了新一代GH200 Grace Hopper平台,該平台依托於搭載全球首款搭載HBM3e處理器的新型Grace Hopper超級芯片——GH200,專爲處理大語言模型、推薦系統、矢量數據庫等全球最復雜的生成式AI工作負載而構建。

據悉,GH200芯片將成爲世界上第一個配備HBM3e(High Bandwidth Memory 3e)內存的GPU芯片。

與當前一代產品相比,最新版本的GH200超級芯片內存容量增加了3.5倍,帶寬增加了3倍;相比最熱門的H100芯片,其內存增加1.7倍,傳輸頻寬增加1.5倍。

在當前生成式AI不斷激增的需求下,GH200超級芯片的推出,進一步吹響了AI算力之战的號角。

性能更高的GH200芯片

據介紹,GH200 Grace Hopper平台的HBM3e內存比當前HBM3快50%,可提供總計10TB/s的帶寬。這使得新平台能夠運行比上一版本大3.5倍的模型,同時憑借快3倍的內存帶寬提升性能。

同時,該平台採用雙配置,包括一個擁有144個Arm Neoverse內核、8 petaflops的AI性能和282GB最新HBM3e內存技術的單個服務器。

英偉達創始人兼首席執行官黃仁勳表示:“爲了滿足對生成式 AI不斷激增的需求,數據中心需要能夠滿足特定需求的加速計算平台。全新GH200 Grace Hopper超級芯片平台以出色的內存技術和帶寬,提高了吞吐量,在不影響性能的情況下可連接多GPU以整合性能,並且具有可以輕松部署到整個數據中心的服務器設計。”

據英偉達公布信息,新平台可以通過 NVIDIA NVLink™ 與其他超級芯片連接,使它們能夠協同工作,從而部署當下大型生成式AI模型。這種高速、一致性技術使GPU可以完全訪問CPU 內存,在雙配置中可提供總計1.2TB的快速內存。

值得注意的是,新平台採用的新款超級芯片GH200與此前發布的H100相比,二者使用同樣的GPU,但GH200將同時配備高達141G的內存和72核ARM中央處理器,每秒5TB帶寬,內存增加了1.7倍,帶寬增加了1.5倍。

新平台和芯片的加持,也讓大模型訓練的成本得到有效降低。黃仁勳表示,一台服務器可以同時裝載兩個GH200超級芯片,大型語言模型的推理成本將會大幅降低。

據介紹,投資800萬美元Grace Hopper,就相當於8800個價值1億美元的x86 GPU,意味着成本降低12倍,能耗降低20倍。

英偉達稱,GH200已於5月全面投產,基於GH200 Grace Hopper平台的新系統將於2024年第二季度交付。

不過一個關鍵的問題是,英偉達沒有透露超級芯片GH200的價格,這對計算成本高昂的大模型來說尤爲重要,H100系列目前售價約爲4萬美元。

爲什么內存對大模型重要?

事實上,GH200超級芯片本身並不是一個新產品,而是今年5月在中國台北Computex展上發布的GH200芯片的更新版。

英偉達超大規模和高性能計算副總裁兼總經理伊恩·巴克(Ian Buck)表示:“我們對這款新的GH200感到非常興奮。HBM3e不僅增加了GPU的容量和內存量,而且速度也更快。”

但爲什么GPU內存這么重要?

這是因爲隨着支撐生成式人工智能應用程序的基礎AI模型尺寸的增加,爲了能夠在不連接獨立芯片和系統的情況下運行,大模型需要更大的內存量,以避免性能下降。

擁有更大的內存允許模型保留在單個GPU上,並且不需要多個系統或多個GPU來運行,而額外的內存只會提高 GPU的性能。

目前即使使用英偉達最頂級的H100芯片,有些模型也必須在其他GPU中“分解”模型才能運行。

據英偉達介紹,最新版本GH200配備141GB的HBM3e內存,旨在處理“世界上最復雜的生成式人工智能工作負載,涵蓋大型語言模型、推薦系統和矢量數據庫”。

對AI領域的影響

英偉達的GH200超級芯片和DGX GH200超級計算機是AI領域的重大突破,它們爲大規模生成式AI工作負載提供了前所未有的性能和內存空間,使得訓練千億甚至萬億參數的巨型模型成爲可能。

這些模型可以在自然語言處理、計算機視覺、推薦系統、圖形分析等領域實現更高的精度和效率,爲人類解決更復雜的問題提供了強大的工具。

在多位AI從業者看來,當前大模型的訓練需求過於迫切,對性能的要求也很高,而GPU的適配和生態轉移都需要很長時間,因此目前大家都優先選擇英偉達,和其他廠商的測試驗證也在進行中。

一場新的算力之战已經拉开帷幕,如果說算力是一個江湖,那么此刻英偉達就是一名絕世高手。

它身懷加速計算的絕技,尤其在AI战場上一騎絕塵,似乎每一次都能精准地踏在浪潮的節奏上。從遊戲PC市場、到深度學習的崛起、到雲計算的普及、再到生成式AI的降臨,英偉達的技術所向披靡。

回頭看,英偉達早已超越了GPU本身的概念,AI成爲最大的標籤,算力的絕世武功撐起了新的萬億帝國。

2022年,英偉達推出了多款重磅產品,分別是基於全新Hopper架構的H100 GPU、CPU和GPU的合體Grace Hopper、兩個CPU組合的Grace CPU Superchip,CPU的產品在2023年上市。

其中,設計GPU新架構Hopper時,英偉達增添了一個Transformer引擎,專門爲Transformer算法做了硬件優化,加快AI計算的效率。

一位國內芯片從業者直言:“H100出來,其實就是一個新時代了,Grace-Hopper再一個組合,加上高配的互聯,完全不給活路,英偉達贏家通喫,AMD、Intel繼續苦追。”

同時他也表示:“目前國內一些企業還是在盯着CNN做優化,英偉達已經有Transformer引擎,然後AIGC火熱,恰好能做支持。這個眼光,只能佩服他們的科學家們對這個領域深刻的認識。”

一位學術界人士也分析道:“從H100上,包括專用的Transformer引擎以及對FP8格式的支持,可以看到計算硬件在向應用定制的方向前進。Grace CPU說明了整合異構計算系統的重要性。單純的加速器優化和設計已經不能夠滿足現在對於計算系統的算力和能效比的要求,需要各個部分的協同優化和設計。”

他還表示,Grace CPU通過提高通信帶寬和在CPU和GPU之間建立一致(coherent)的內存模型來解決運算中的瓶頸,這也和學界(近存計算,存內計算)與業界(CXL,CCI等等系統互聯協議)一直在關注的方向是一致的。

總而言之,在GPU和CPU的各種排列組合中,英偉達又將算力提升到了新高度。正如黃仁勳所言:“我們正在重新發明計算機,加速計算和人工智能標志着計算正在被重新定義。”

黃仁勳在採訪中還提到,數據中心需要用的CPU越來越少,不再是傳統上購买數百萬個CPU,而是轉而購买數百萬個GPU。換言之,在他看來,AI算力江湖已經是GPU的主場。

英偉達的野心

事實上,隨着ChatGPT引發AI大模型需求熱潮,作爲加速計算領導者,英偉達今年以來股價累計漲幅已超過210%,近三個月內漲幅就達56%,過去7年股價增長超40倍,目前市值衝破1.1萬億美元。

公开數據顯示,英偉達佔據全球80%以上的GPU服務器市場份額,同時擁有全球91.4%的企業GPU市場份額。

據投資者服務公司穆迪今年5月份發布的一份研究報告,英偉達在未來幾個季度將實現“無與倫比”的收入增長,其數據中心業務的收入將超過競爭對手英特爾和AMD的總和。

但摩根士丹利策略分析師斯坦利(Edward Stanley)在最新報告中稱,根據歷史背景,英偉達的股價飆升處於“後期”階段,摩根士丹利認爲這標志着 AI 行業的“泡沫”。

GPU持續緊缺下,如今英偉達產品價格已同比上漲超30%,英偉達A800單卡現貨近13萬元一顆,eBay上H100售價高達4.5萬美元。

同時,OpenAI的GPT-4大模型需要至少2.5萬張英偉達A100 GPU芯片,而該公司目前至少已擁有1000萬顆GPU芯片。

正如黃仁勳常說的,“你GPU买得越多,你越省錢”。主要原因是新的GPU產品能顯著提升加速計算,比CPU性能更強、算力更大、功耗更低。

但英偉達的布局還不止於此。

一個現實問題是,高性能的算力也意味着高昂的價格。大模型訓練成本動輒成千上百萬美元,並不是所有公司都能承受。

而英偉達同時提出了雲服務的解決方案NVIDIA AI foundations,黃仁勳表示要做“AI界的台積電”。台積電大大降低了芯片設計公司生產門檻,英偉達也要做代工廠的角色,通過和大模型廠商、雲廠商合作提供高性價比的雲服務。

在幫助下遊企業降低大模型訓練成本的同時,英偉達還在逐步參與到上遊的產業鏈升級中。今年,英偉達牽手台積電、ASML、新思,發布了計算光刻庫cuLitho。

計算光刻是在芯片設計和制造領域的關鍵步驟,也是最大的計算負載之一。計算光刻庫的技術突破就在於,可以通過部署有大量GPU的DGX AI計算系統對計算光刻進行加速,使其達到原有的基於CPU的計算速度的幾十倍,同時降低計算過程的總能耗。

這將有助於晶圓廠縮短原型周期時間、提高產量、減少碳排放,爲2nm及更先進的工藝奠定基礎,並爲曲线掩模、高數值孔徑極紫外、亞原子級光刻膠模型等新技術節點所需的新型解決方案和創新技術提供更多可能性。

在多位產業界人士看來,雖然短期內不會影響到下遊的應用方面,但是這些上遊的研發和升級將長期影響產業的發展,累積形成代際差。

“英偉達在GPU架構的迭代上,一直都有屬於自己的發展路徑,這幾年的發展,也讓英偉達躍居AI算力芯片領域的領導者,也因爲領先,所以英偉達會思考如何做更多元的布局與行業內的深度合作,這樣更能了解行業的需求,比方和台積電等合作便是很好的例子”,某芯片行業專家表示。

當然,英特爾和AMD都已經吹響反攻的號角。

7月,英特爾面向中國市場推出了AI芯片Habana Gaudi 2;6月,AMD推出AI芯片Instinct MI 300X,兩者都直接對標英偉達100系列。

目前,在數據中心市場,英偉達和Intel、AMD形成三足鼎立之勢。但隨着GH200的正式發布,Grace CPU正式登台爭角,最應該感到如芒在背的應該是Intel、AMD。雖說大家都知道GH200遲早發布,但等真正發布了,還是有所觸動。

圍繞着算力的權力遊戲還將繼續。

相關閱讀

爭奪算力話語權,雲計算廠商迎來自研芯片“覺醒時刻”

AMD成功收購賽靈思,英偉達無緣ARM,芯片界巨型收購潮走向尾聲?

新一輪科技革命吹響號角,Chiplet或成AI芯片關鍵“破局”點

AI大模型背後,竟是驚人的碳排放

“吞金獸”ChatGPT背後:AI算力告急!

【科技雲報道原創】

轉載請注明“科技雲報道”並附本文鏈接

原文標題 : 算力之战,英偉達再度釋放AI“炸彈”

標題:算力之战,英偉達再度釋放AI“炸彈”

地址:https://www.utechfun.com/post/249696.html