人類距離第一個AGI的出現已經越來越近了!

馬斯克在今年早些時候預測,AGI可能會在2026年投入使用。DeepMind聯合創始人、首席AGI科學家Shane Legg在一次訪談中認爲,2028年,人類有50%的概率开發出第一個AGI。然而百度CEO李彥宏的觀點則更加審慎,他認爲AGI還需要10年以上的時間才能出現。

自1956年達特茅斯會議提出“人工智能”這一概念以來,實現人類水平的智能一直是AI領域的聖杯。去年上半年,有主流研究者提出,大語言模型已經表現出“通用人工智能的火花”(sparksof AGI)。這似乎表明,AGI已經從哲學猜想變成了將來的未來。然而,關於AGI的觀點衆說紛紜,大語言模型也常有愚蠢行爲出現,這些都引發了對AGI的質疑。

在此背景下,我們離實現真正的AGI還有多遠?如何預防AGI帶來的潛在風險?

AGI,未到的黎明

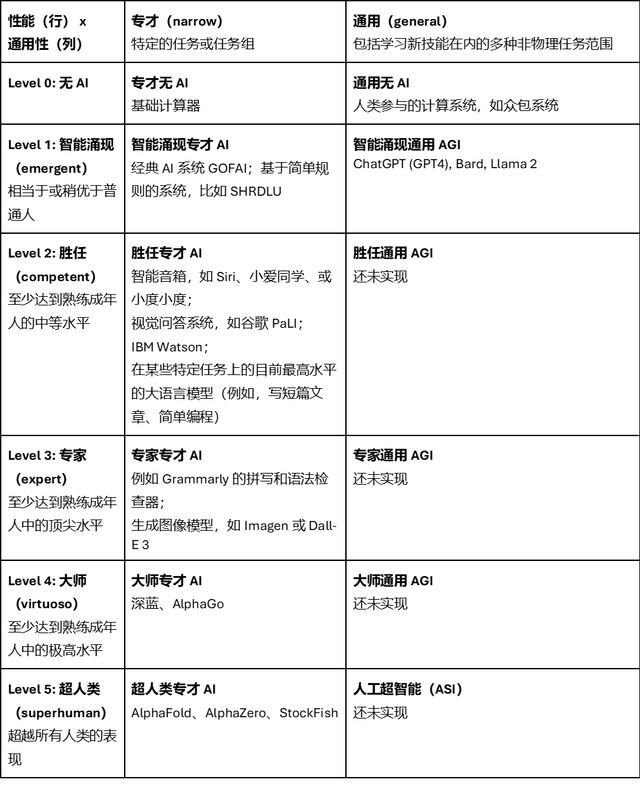

從性能強度和通用性兩個維度,可以將人類和AI的關系劃分爲6個階段:無AI、智能湧現、勝任、專家、大師、超人類。而現在大語言模型的出現,正屬於第一個AGI的階段:AGI雛形。

AGI(Artificial General Intelligence),即通用人工智能,其目標是實現人類般的通用智能,這意味着AI可以像人類一樣理解任意通用任務,並以人類的智力水平執行完成。基本上,除了“自我意識”的生成,AGI就是人類對人工智能的終極夢想了。

AGI是要讓智能體像人一樣,不僅能夠獨立感知環境、進行思考、作出決策、學習新技能、執行任務,還能夠與人類或其他智能體進行有效的協作。同時,智能體能夠理解人類的情感,並且遵循社會倫理和道德規範。

一個完整的AGI需要具備三個基本特徵:第一,必須能完成無限的任務,而不是只能完成人定義的有限幾個任務。第二,要在場景中自主發現任務,這是通常所說的要做到“眼裏有活兒”。第三,要有自主的價值來驅動,而不是被動的被數據所驅動。

同時,AGI還需要解決一些關鍵的技術問題,比如構建智能體的認知架構,讓智能體由價值驅動,在現實世界中進行有效的行動,能夠與社會環境進行互動,使智能體決策過程透明可解釋,以及建立和人類之間的信任關系等。

以OpenAI的ChatGPT、谷歌Bard、Meta的Llama爲代表的大模型,已經在通用性上展示出了AGI的潛力。因爲大語言模型已經能完成範圍相當廣的各類任務,而且表現出了像學習新技能這樣的“元認知”能力。

相比大模型的“鸚鵡範式”,AGI是以“小數據,大任務”爲架構的“烏鴉範式”,智能體表現爲具有自主的智能,能夠自主感知、認知、推理、學習和執行,不依賴於大數據,基於無標注數據進行無監督學習,並且智能系統低功耗。就像烏鴉喝水這一行爲,看似簡單,卻屬於自主推理行爲,是由價值與因果驅動的高級智能,也是AI的未來發展趨勢。

如果單從AI的性能維度上看,“窄AI(Narrow AI)”類型的AI已經達到了完全超越人類認知的水平。以AlphaFold、AlphaZero爲代表的專業領域AI,在特定領域已經能發現人類智力無法發現的新事物了,此類被成爲“超人類窄AI”。而在某些領域,AI能達到90%的人類水平,比如文書糾正AIGrammarly,DALL·E 2,Imagen等生圖AI,這被稱爲“專家級窄AI”。在特定領域,能達到普通人的平均水平,比如Siri,谷助手這類普通智能助理,其被稱爲“普通窄AI”。

所謂“窄AI”,是指那些特別擅長處理單一任務或者特定範圍內工作的系統。在大多數情況下,它們在特定領域中的表現遠優於人類。不過一旦它們遇到的問題超過了適用空間,效果則急轉直下。換言之,它們無法將自己掌握的知識從一個領域轉移到另一個領域。

盡管窄AI無法全面執行需要人類智能的任務,但在特定場景中仍然非常實用,而且已經在諸多應用之內發揮着自己的作用。谷歌搜索查詢現在可以利用窄AI算法回答問題,窄AI系統會在YouTube及Netflix中推薦用戶可能感興趣的視頻,並在Spotify中按喜好整理出周推音樂列表。

而在窄AI已經覆蓋的能力維度上,AGI都還沒有出現對應的實例,因爲目前還沒有出現真正意義上的AGI,對於AGI的定義,人類也還沒有達到統一的認知。

誰會是AGI的起點?

從信息時代走向智能時代,“語言”成爲那把开啓全新時代的鑰匙。著名的作家兼哲學家路德維希·維特根斯坦在其《邏輯哲學論》一書中提到:“我的語言的界限,意味着我的世界的界限。”

對人類而言,承載世界的知識、思考、溝通和文化靠的是語言。語言本身的發明代表着每多一個詞匯就讓世界多了一個認知維度,詞匯之間建立的邏輯關系和表達代表了人類對世界完整的建模。這個模型不是在圖像裏面,而是通過語言進行承載,所以語言邊界就是世界邊界。AI核心就是把現實世界的現象翻譯成爲數學模型,通過語言讓機器充分理解現實世界和數據的關系。

如今,人們已經走出了原來物理學靠一個公式解釋世界的方法,更多是靠海量數據在不同層次單獨建模,上層建模就是由大量的數據驅動。語言模型如此,生命建模也是如此,2021年最偉大的成就就是DeepMind的AlphaFord系統,針對基因到蛋白質的三維結構建模,通過這個模型預測基因被轉錄或者表達爲蛋白質以後擁有的形態,也是全世界轟動的生命領域的突破,靠的也是數據和AI的驅動。

雖然大模型已經取得了一些驚人的進展,但如果比較AGI的三個特徵,就會發現大模型還不符合AGI的要求。

首先,大模型在處理任務方面的能力有限,它們只能處理文本領域的任務,無法與物理和社會環境進行互動。這意味着像ChatGPT這樣的模型不能真正“理解”語言的含義,因爲它們沒有身體來體驗物理空間。

其次,大模型也不是自主的,它們需要人類來具體定義好每一個任務,就像一只“鸚鵡”,只能模仿被訓練過的話語。真正自主的智能應該類似於“烏鴉智能”,能夠自主完成比現如今AI更加智能的任務,當下的AI系統還不具備這種潛能。

第三,雖然ChatGPT已經在不同的文本數據語料庫上進行了大規模訓練,包括隱含人類價值觀的文本,但它並不具備理解人類價值或與人類價值保持一致的能力,即缺乏所謂的道德指南針。

但這並不妨礙科技巨頭對於大模型的推崇。OpenAI、谷歌在內的科技巨頭,都將大模型視爲邁向AGI的關鍵一步。OpenAI CEO Sam Altman就曾多次表示,GPT模型是朝着AGI方向發展的重要突破。

不過,Meta人工智能首席科學家楊立昆(Yann LeCun)認爲,目前的大模型路线無法通往AGI,且非常危險。

他指出,現有的大模型盡管在自然語言處理、對話交互、文本創作等領域表現出色,但其仍只是一種“統計建模”技術,通過學習數據中的統計規律來完成相關任務,本質上並非具備真正的“理解”和“推理”能力。

他認爲,“世界模型”更接近真正的智能,而非只學習數據的統計特徵。以人類的學習過程爲例,孩童在成長過程中,更多是通過觀察、交互和實踐來認知這個世界,而非被單純“注入”知識。而LeCun的“世界模型”路线,則是試圖通過對視頻、音頻等媒體的模擬與補全,讓AI也經歷這樣一個自主學習的過程。

他也承認,實現“世界模型”並非易事,這一雄心勃勃的目標可能需要耗時10年才能實現。

將風險控制在可控範圍內

對於AGI所帶來的風險,圖靈是最早提出警告的人之一。他在1951年說道:“一旦機器开始思考,很快就能超越我們。因此,在某個時候,我們應該期望機器能夠被掌控。”因爲當一個比人類更強大的智能體出現時,人類很難維持權力,特別是當這些智能體具有不正確或不完整的目標時。

如果還有人認爲現在考慮這些風險是危言聳聽,那么如何回答這樣一個問題:你如何在比人類更強大的智能體面前永遠保持權力?此外,在AI領域,還有一些人試圖回避這個問題,否認AGI的可實現性,卻沒有提供任何證據。

OpenAI CEO Sam Altman在其文章《Planning for AGI and Beyond》裏,探討了AGI對社會、技術和倫理的潛在影響,並強調了慎重規劃和負責任的發展的必要性。

文章指出,通過增加資源豐富度、推動全球經濟增長,以及助力新科學知識的發現,AGI有潛力極大地提升人類生活質量。這不僅是智力的巨大增幅,更是對人類創造力和想象力的極大擴展。

然而,AGI的出現也可能帶來嚴重的濫用風險、意外極端事件的可能以及對社會結構的劇烈動蕩。因此,OpenAI提倡在發展AGI時,AGI开發者以及全社會都必須找到正確的方法來實現和利用這一技術,確保其與人類核心價值觀保持一致,並公平地分享其帶來的好處。

此外,OpenAI認爲,從長遠來看,AGI的出現僅僅是智力發展的一個節點,而AI的進步可能會在未來相當長一段時間內繼續保持。OpenAI提出了一個安全的AGI發展愿景,即在較短時間內以較慢的速度過渡到AGI,以便社會有時間適應和調整。

盡管未來不可預知,但OpenAI表達了他們最關心的幾個原則:希望AGI能最大限度地促進人類在宇宙中的繁榮;希望AGI帶來的好處、訪問權和治理能夠被廣泛且公平地分享,並成功應對巨大風險。

爲此,OpenAI倡導在短期內進行漸進式過渡、繼續創造越來越符合目標的模型,並在長期進行全球範圍的對話,討論如何治理這些系統、如何公平分配它們產生的好處,以及如何公平分享訪問權。在極高的風險和回報下,人類需要團結起來,讓AGI在未來世界以一種對人類最有益的方式綻放。

對於如何預防AGI給人類帶來威脅,可以逐步放开AGI的能力空間和價值空間,一开始把它關在“籠子”裏,慢慢打开權限。對於AGI,可以先其適用場合和行動空間限制在特定區域內,隨着人們對機器的信任的增加,確認AGI安全可控後,再逐步給予更大的空間。另外,應該進一步促進算法決策過程的透明度。如果能夠清晰了解AGI的認知架構,從而知道其是如何工作的,就能更好地控制它。

人類對於AGI的探索和思考才剛剛开始,我們還有很長的路要走。AGI的進步不僅代表了技術創新,更是對未來人機交互方式的重新想象。隨着我們逐步走向AGI未知領域,穩健和有序的發展顯得更加重要,我們必須高度警醒AGI所帶來的問題,並充分重視AGI所創造的機會。兩千多年前,蘇格拉底說“認識你自己”,今天在AGI技術發展的倒逼下,人類需要“重新認識你自己”。

原文標題 : AGI漸行漸近,該加速還是要踩剎車?

標題:AGI漸行漸近,該加速還是要踩剎車?

地址:https://www.utechfun.com/post/377327.html