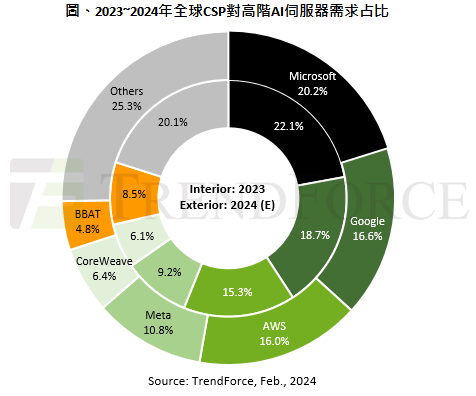

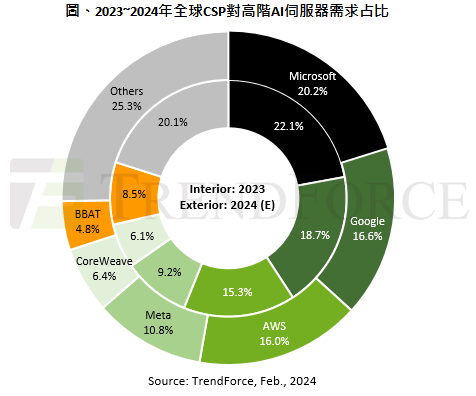

導讀 TrendForce 最新預估,以 2024 年全球主要雲端服務業者(CSP)對高階 AI 伺服器(含搭載 NVIDIA、AMD 或其他高階 ASIC 晶片等)需求量觀察,美系四大 CSP 業者微軟...

TrendForce 最新預估,以 2024 年全球主要雲端服務業者(CSP)對高階 AI 伺服器(含搭載 NVIDIA、AMD 或其他高階 ASIC 晶片等)需求量觀察,美系四大 CSP 業者微軟、Google、AWS、Meta 各家佔全球需求比重分別達 20.2%、16.6%、16% 及 10.8%,合計超過六成,居全球領先位置。又以搭載 NVIDIA GPU 的 AI 伺服器機種佔大宗。

受美禁令影響,NVIDIA後續發展仍有挑戰

NVIDIA近期整體營收來源以資料中心業務為關鍵,主因GPU伺服器佔整體AI市場比重高達六至七成,惟後續仍須留意三大狀況,可能使NVIDIA發展受限。一,受美國禁令箝制,中國政府更致力AI晶片自主,華為仍被NVIDIA視為可敬對手。NVIDIA因應禁令推出的H20等中國特規方案,性價比可能不及H100或H800等,中國客戶採用度可能較保守,影響NVIDIA市佔率。

二,具規模及成本考量下,美系大型CSP業者除Google、AWS外,微軟、Meta等亦有逐年擴大採自研ASIC趨勢。三,AMD同業競爭,AMD採高性價比策略,對抗NVIDIA同級品,AMD價格僅60%~70%,甚至代表性或具規模客戶能以更低價策略方式搶進市場,2024年尤以微軟最積極採納AMD高階GPU MI300方案業者。

NVIDIA為維持領先,將更致力拓展多元組合產品線

NVIDIA面臨潛在隱憂,亦更積極加速拓展多元產品線,以因應不同客戶群。今年起汰換A100,以價格更高的H100系列為主軸。除H100外,第二季末開始小量出貨搭載更高HBM3e規格的H200。另NVIDIA價格將更積極採差別訂價,H100採部分折價策略,H200應維持H100原價格水位,以提供更高性價比,穩固雲端CSP客戶。NVIDIA將採用NRE(Non-recurring engineering Expense)模式,與Meta、Google、AWS及OpenAI等廠商展開洽談,目標擴及電信、車用及電競客戶。

此外,NVIDIA下半年將推出新B100產品,相較H系列效能可望再提升,HBM記憶體容量高H200約35%~40%,以因應更高效能HPC或加速LLM AI訓練需求。中低階產品除L40S針對企業客戶做邊緣端較小型AI模型訓練或AI推論外,另規劃以L4取代T4為雲端或邊緣AI推論應用。

為避免2023年GPU供應不足問題,NVIDIA亦積極參與CoWoS及HBM等擴建產能需求,第二季相關原廠產能逐步開出後,原交付Lead Time平均約40週也可減半,逐步去除下遊供應鏈因GPU短缺使AI伺服器供應進度受阻問題。

(首圖來源:)

關鍵字: , , ,

標題:2024 年北美四大雲端服務業者對高階 AI 伺服器需求量逾六成

地址:https://www.utechfun.com/post/338008.html

鄭重聲明:本文版權歸原作者所有,轉載文章僅為傳播信息之目的,不構成任何投資建議,如有侵權行為,請第一時間聯絡我們修改或刪除,多謝。