導讀 即使我們步入 2023 年最後階段,生成式 AI 模型發展迅速,絲毫沒有停下步伐,近日 Google Gemini 模型出盡風頭,事實上微軟本身也有 AI 模型的開發成果要與大眾分享。 微軟研究院(...

即使我們步入 2023 年最後階段,生成式 AI 模型發展迅速,絲毫沒有停下步伐,近日 Google Gemini 模型出盡風頭,事實上微軟本身也有 AI 模型的開發成果要與大眾分享。

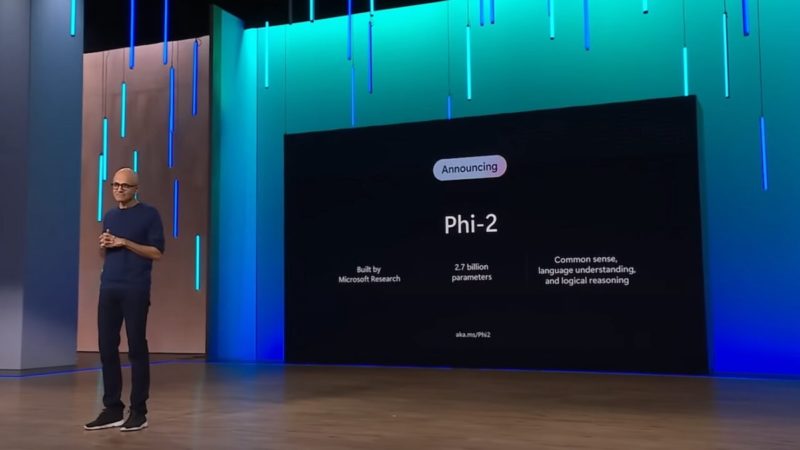

微軟研究院(Microsoft Research)12 日推出 Phi-2 小型語言模型(small language models,SLMs),具有出色的推理和語言理解能力,可做為 AI 生成文字的應用程式,規模小到可搭載在筆電或行動裝置上。

延續 Phi-1、Phi-1.5 分別擁有 13 億參數,Phi-2 擁有 27 億參數,在多項基準測試取得卓越性能,勝過其他更大的模型如 Meta Llama 2-7B、Mistral-7B。

研究人員在微軟研究院部落格文章指出,Phi-2 以 96 個 NVIDIA A100 GPU,花了 14 天完成訓練。儘管 Phi-2 比起 32 億參數訓練而成的 Gemini Nano 2 少了 5 億參數,但性能可優於 ,在偏誤、資料毒性(toxicity)等面向也比 更少。

從微軟提出測試結果可見,儘管 Phi-2 大小只有 Gemini Ultra 一小部分,但它能夠正確回答問題,並使用相同提示糾正學生。

不過,Phi-2 存在很大局限,因為根據 Microsoft Research 制定的許可,它只能用於研究目的,不能應用在商業用途,對 Phi-2 感興趣的開發者和企業恐怕無緣以 Phi-2 打造消費市場想要的 AI 應用程式。

(首圖來源:)

關鍵字: , , , , , , ,

標題:微軟開發 Phi-2 2.7B 模型,輕巧高性能優於 Gemini Nano 2

地址:https://www.utechfun.com/post/303498.html