生成式人工智能在互聯網行業掀起了一波浪潮,大模型也帶來了數據中心行業又一次高速發展的機會。相關產業協同迭代,液冷將迎來關鍵的一年。

一位從事數據中心建設的專家向《銀杏科技》表示,目前國內數據中心液

隨着大模型應用的快速增長,國內部分液冷方案供應商今年上半年銷售額較去年全年增長了100%,預計全年銷售額較去年增長將超過300%。數據中心規模提升,讓業內普遍認爲液冷將在未來幾年內迅速成爲數據中心行業的絕對主導。

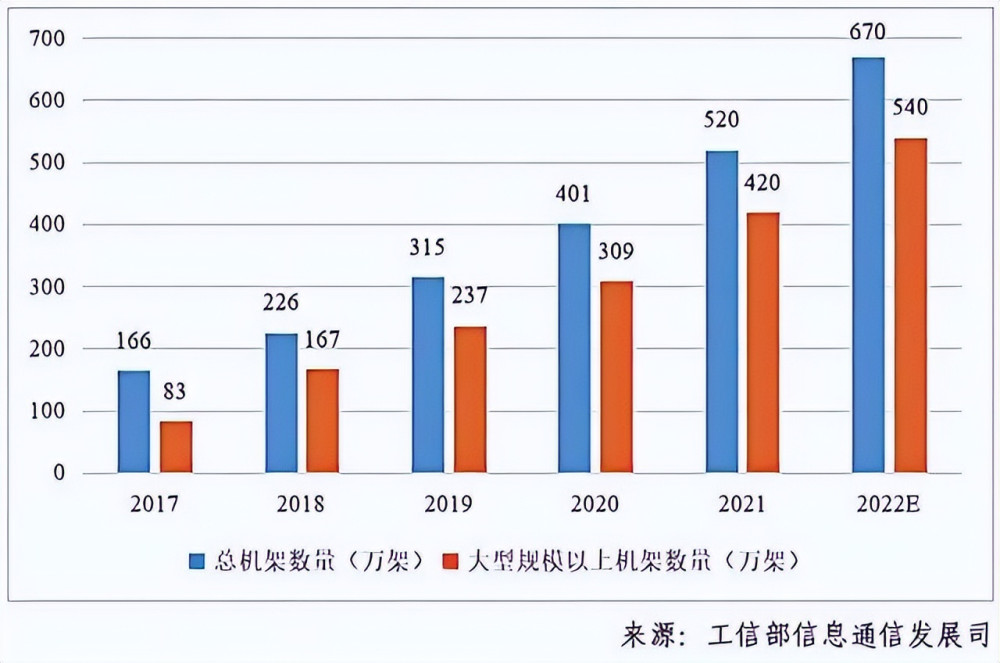

據《中國通信院》公布的數據顯示,去年我國數據中心規模穩步增長,按照標准機架2.5kW來統計,2022年我國數據中心機架規模達到670萬架,近五年的年復合增長率超過30%。其中大型以上數據中心增長更爲迅速,2022年底規模達540

外部環境的變遷也讓市場對液冷的需求日盛。控制碳排放的硬性要求之外,隨着全球平均氣溫紀錄被不斷刷新、高溫成爲常態,數據中心也需要處理高溫對其正常運轉的妨礙。

2022年7月,受到全球熱浪的影響,亞馬遜公司在倫敦的一座數據中心由於高溫而導致宕機,一周後,谷歌和Oracle在英國托管的雲服務和服務器也由於冷卻問題而停機。同年9月,位於加州的推特數據中心也因45攝氏度高溫停擺。

2023年夏季,當創紀錄的高溫再次席卷全球,行業也在不斷推出更有效的降溫方式以應對新的挑战,液冷數據中心逐漸成爲標配。

高溫襲擊數據中心

數據中心,尤其是科技公司新建的大型數據中心,往往並不扎堆在一线城市,而是分布在內蒙古、貴州、甘肅、寧夏等省區。集中在這些地區的原因和氣溫有關:高溫會降低其運行效率,提高運行成本,平均氣溫越低的地區越受數據中心青睞。

數據中心工程師陳鋒表示,數據中心的溫度需要控制在22攝氏度左右。最高性能的處理器通常會帶來高頻和多核特性,較低的溫度能夠使具備動態頻率調節能力的CPU、GPU等運算設備能夠以較高頻率穩定運行,設備的運行壽命也會得到提升。

因此,解決最高性能處理器的散熱問題,就意味着服務器生產力的提升。

相反,一旦機房溫度過高就會導致設備宕機。這是電子設備的物理特性決定的,機房設備中有很多電子元件,在工作時會產生大量的熱量。如果不能及時散熱,就會影響機房性能。通信設備遵循“10攝氏度法則”,即溫度每升高10攝氏度,設備的可靠性就會下降25%。

“磁盤所處的環境溫度如果高於70攝氏度就會开始出現損壞,當溫度持續高於100攝氏度時就會完全損壞,” 數據中心工程師陳鋒表示,“機房設備裏的電容在高溫環境下會使電介質溶液當中的水分蒸發增大,降低容量,縮短壽命。”

因此,數據中心需要大量制冷設備和電力對機房進行制冷。連續的高溫天氣容易導致制冷設備超負荷運轉,最終發生故障,從而導致數據中心癱瘓。

高溫天氣對供電系統也是一個考驗,供電壓力巨大的情況下可能會發生突發性斷電,影響設備性能,甚至損壞設備。高溫天氣還會讓機房內的空氣變得幹燥,產生靜電,影響設備工作甚至引發火災。

對於數據中心來說,高溫無疑是最大的敵人之一。2021年我國數據中心耗電量爲2166億kWh,佔社會總耗電量的2.6%,相當於1.3個上海市的總社會用電量,而其中用於散熱的能耗佔比超過40%,更是佔到了非IT能耗的80%。

因此,天氣涼爽的地區成爲了數據中心行業的心頭好。內蒙古自治區最大的數據中心集群所在地和林格爾年平均最高氣溫約15攝氏度,年平均氣溫爲3.5至8攝氏度;貴州省最大數據中心核心區所在的貴安新區,年平均最高氣溫約18攝氏度,年平均氣溫爲15攝氏度。

作爲我國北方和南方最大的數據中心所在地,和林格爾和貴陽都可以稱得上是涼爽,也因此格外受到數據中心行業的青睞。

進入液冷時代

雖然低溫有着足夠的吸引力,但並非所有數據中心都可以搬遷到這些地區。

高溫天氣的常態化、碳排放要求、能源價格的上漲也讓行業不斷尋找新的突破口。種種條件限制下,液冷成爲了近年來新建設數據中心的最佳方案。

從事數據中心建設的田文靖告訴《銀杏科技》,傳統數據中心一般選擇直接降低機房內的氣溫,也就是利用空氣作爲冷卻介質。空調降溫的效率較低,高密度數據中心中冷卻系統的功率常常會超過100kW,噪聲超過95分貝,工作人員必須戴降噪設備才能進入機房工作。

此外,當數據中心中假設了大量服務器時,房間內會出現明顯的溫度分層情況:熱空氣會聚集在房間上部,冷空氣則聚集在腳底,這會讓同一個機架上不同高度的設備獲得不同的降溫效果,影響設備的運行。

液冷數據中心的原理與空調非常類似,都是利用比熱容較大的液體將設備運轉產生的熱量轉移到室外,根據設備與液體不同的接觸方式可以分爲冷板式、噴淋式、浸沒式等,使用的液體也包含礦物油、氟化液等種類。

在建設過程當中,液冷數據中心的建設與維護成本普遍較風冷數據中心更高。田文靖表示,液冷數據中心需要更精細的管理。冷卻系統管理不善可能會導致冷卻液腐蝕、沉積、微生物生長,最終使數據中心冷卻效率下降,甚至可能出現宕機、損壞設備的結果。因此,液冷數據中心的維護成本也較風冷數據中心更高。

但這些都無法掩蓋液冷數據中心最大的優勢——節能。相比以空氣介質,冷卻液的導熱系數是空氣的6倍,熱容是空氣的1000倍,因此,液冷可以讓冷卻液的傳熱次數更少,容量衰減更小,冷卻效率更高。

液體冷卻的傳熱比空氣冷卻的傳熱系數高數百倍,所需的實施空間也更小。數據中心50%-80%的散熱都可以通過液體轉移到外部冷卻塔,減少冷卻塔的使用,最終降低PUE。

PUE指全年數據中心總能耗與IT設備能耗的比值,越接近1,意味着數據中心用於散熱的能源消耗越小,數據中心就越省電。風冷數據中心平均PUE約爲1.3,液冷數據中心PUE往往更低。

田文靖透露,阿裏雲數據中心去年進行測試的浸沒式液冷系統,最低能夠達到年均PUE1.09;京東雲數據中心在2021年換用冷板液冷後,PUE從1.3降低到了1.1,反映在電量上,一個14kW的機櫃一年可以節省31000多度電,產生的經濟效益和環境效益足以抵消液冷中心的額外建設與維護成本。

新環境、新挑战、新機遇

液冷相對於風冷數據中心有着無法替代的優勢,其間包含的商業價值不容忽視。

市場分析機構預計,到2026年,液冷數據中心市場的初始估值從2018年的14.3億美元增至1205億美元,年化復合增長率達30.45%。

對於數據中心需求更高的通信行業也將液冷的普及化提上了日程。在技術上,不少廠商都在數年前开始提前布局液冷技術,中科曙光、華爲、阿裏、聯想、浪潮等國內企業對液冷技術均有儲備,近年來更是不斷加大在液冷技術研發方面的投入。

三大通信運營商也積極擁抱液冷。

2023年6月,移動、聯通、電信三大運營商聯合發布《電信運營商液冷技術白皮書》,宣布將從今年起开展技術驗證,驗證液冷技術性能,降低PUE,儲備規劃、建設與維護等技術能力,最終在2025年开展規模應用。

相對於海外企業,我國自研液冷技術並不落後,而在應用層面則擁有更多商業實踐案例,總體競爭力上已經處於領先地位。

但作爲新興市場,液冷行業也存在着缺乏統一標准、產品仍在迭代的問題。

與有着完善行業標准的風冷設備不同,由於液冷方案中機櫃與服務器深度耦合,根據不同的液冷方案和中下遊供應商,服務器與機櫃相結合的方式、接頭尺寸、冷卻液規格等零部件和設備也各有不同,互不兼容,嚴重幹擾了行業的發展。

行業頭部科技企業也意識到了這個問題,2021年4月,中國信通院牽頭,阿裏巴巴、百度、騰訊、美團、京東、中國電信、中國移動、3M等企業共同發布了5項數據中心液冷行業標准;中科曙光、英特爾等方案提供商也提出了各自的液

總體來看,處於市場競爭早期階段的液冷行業依然缺乏統一標准。

此外,近些年數據中心行業蓬勃發展,各種全新的降溫技術也在不斷出現,液冷設備及其周邊系統的架構也在不斷演進當中,甚至有部分方案已採用耐高溫服務器,從根源上進一步降低散熱需求,簡化冷源架構。

面對不斷演進的數據中心建設方案,液冷初期投資高、全生命周期成本高就成爲了液冷數據中心建設時不得不考慮的關鍵因素。

雖然液冷行業仍在發展早期階段,但其間蕴含的潛力已不容忽視。作爲技術迭代最關鍵的基礎設施之一,液冷數據中心的發展不僅會縱向滲透到不同行業,也會橫向與人工智能、邊緣計算和5G其他技術相結合,支持其他技術落地的同時,也在實際應用中完善自身體系。

大模型帶動相關產業協同發展,也要求產業鏈上下完成技術迭代,進入新工業範式。液冷的爆發可作爲一個提示:機遇湧現之際,市場需要更多想象力。

原文標題 : 高溫挑战科技公司數據中心,液冷將成市場主導

標題:高溫挑战科技公司數據中心,液冷將成市場主導

地址:https://www.utechfun.com/post/249291.html