最近,兩大知識平台开始“反擊”大模型。

一是知網。就是引發學術界震動、开啓“天臨元年”的那個知網,要求祕塔AI搜索終止對他們內容的搜索和鏈接。

二是知乎。網友發現在微軟必應搜索、谷歌搜索的結果中,知乎內容的標題和正文都可能是亂碼,極大可能是爲了避免內容被用來訓練AI模型。

這兩大平台區別於其他互聯網社區的一大特點,就是知識內容豐富、質量較高。

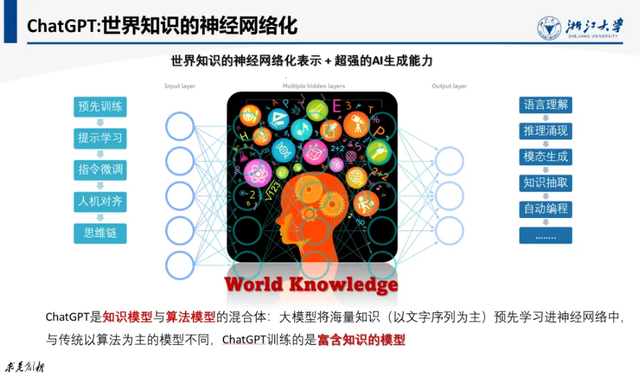

對於大模型來說,“知識密度”是一個非常關鍵的指標,就像集成電路領域的“先進制程”一樣,如果說高制程芯片能夠在同樣面積上集成更多的晶體管,那么“知識密度高”的大模型,能夠在同樣的參數空間內學習並存儲更多的知識,從而更好地完成特定領域的任務。

半導體領域的“先進制程”封鎖,一直是拿捏中國芯片的有效手段。

那么,頭部知識平台對大模型採取“關門政策”,會影響到大模型及AI產品的先進性嗎?

我們的觀點如標題所示,大模型是不會被“知識圍城”而封鎖的。

比起結論,更值得進一步探討的是,既然大模型訓練對平台內容並沒有高度依賴,模廠和平台的矛盾是從何而起呢?

很多讀者都聽說過AI三要素,是數據、算力、算法。知識處於什么地位呢?憑什么大模型知識密度,具有半導體“先進制程”一樣的重要性呢?

清華大學張鈸院士說過,當前大模型存在難以逾越的天花板,“推動AI的創新應用與產業化,四個要素肯定都要發揮知識、數據、算法、算力,但是我們最主張的,就必須重視知識的作用,所以我們把知識放在第一位”。

可能有人又會問,院士說得就一定對嗎?當然不一定。我們還可以來看看一线的從業者,又是怎么想的。

我聽過某AI創業公司,在交付產品時,發現即便是基於GPT4-Turbo這樣性能領先的基座模型,AI也對很多問題答不上來。因爲有些場景會用到一些隱性知識,這些知識是下一步推理所必需的,但模型經常get不到。

比如生成一道菜譜,其中提到了“加辣椒”,但辣椒有點辣(隱性知識),就需要詢問用戶“喜不喜歡喫辣”,人類廚師早就了解這個基礎知識,但讓AI主動意識到並詢問就很難。

這是因爲缺少“通識知識”。

某金融券商想用大模型來替代人類理財師,發現大模型給出的理財觀點和建議很泛泛,是一些常識性內容,而用戶在決策時,需要的是人類專家那樣犀利的洞見。

一位金融從業者說,有些場景,大模型fine tuning還不如傳統的小模型,怎么把業務知識注入大模型中,做了各種嘗試也沒有特別好的方法,只能把飄在上面的問題數據,收集來達標給LLM,希望它下次不要再犯錯網絡。

而另一個創業公司發現,如果從小處着手,將LLM與行業知識融合,可以獲得97%以上的准確率,基本能達到行業客戶的驗收標准。實際上,很多AI創業公司的大模型ToB項目,都是幫助企業構建定制化知識庫(KB系統)。

領域知識,則是關乎大模型處理復雜專項任務、收獲商業成功的第二道壁壘。

所以,很多模廠都希望模型通過持續學習,來不斷吸收新知識,這又帶來了新的問題——修改核心參數,這可能影響到模型的原有性能,有可能直接崩掉,不work了,這是業務的大敵。

咋辦呢?還是得靠知識。

一方面,原本知識密度就高的大模型,相當於人類具備很強的通識基礎,提前了解了很多背景知識,所以泛化能力很強,可以在面對新領域、陌生任務時,快速學習、舉一反三。所以,知識密度可以讓大模型具備跨領域、自學習的能力,通過“知識回路”就能學會新知識了。這就減少了人工幹預,從而降低了故障率。

另外,高效、精准的知識編輯,可以對大模型中的知識進行新增、擦除等操作,就可以用很小的代價,實現模型的迭代升級。讓模廠在保持模型先進性的同時,也不影響到現有業務的持續性。對於業務不能中斷的金融、政務、電力、工廠等行業客戶,簡直不要太有吸引力。

此外,一些實際業務中,不希望大模型在生成時說出來的話,比如一些隱私信息,或者有害有毒內容、政治偏見等,都需要知識編輯技術來進行“祛毒”,精准地識別毒性區域並擦除有毒內容,真正做到給大模型“洗腦”。

由此可見,知識是AI商業化全流程都必須關注的。業界一度有着“得知識者得天下”的風向。有模廠提出了大模型知識的“摩爾定律”,認爲大模型的知識密度,應該每隔8個月就翻一倍,同等知識量的模型參數量減半。

那反過來想一想,失知識者豈不是要失天下了?

知識平台,是人類知識匯聚的重要渠道,OpenAI、谷歌等海外AI公司都與優質媒體內容平台有商業化合作,用授權內容來訓練自家模型。

既然如此,爲什么我們會說,大模型其實並不擔心平台的“知識封鎖”呢?

因爲人類知識平台,不再是模型不得不進的“圍城”。

如果說原始數據是“草”,而知識是牛奶,那么傳統知識獲取,是讓機器“喝的是奶,產的也是奶”。就像20世紀的專家系統,根據一個或者多個專家提供的知識和經驗,通過模擬專家的思維過程,讓機器能夠解決問題。

這種情況下,實現機器智能就必須依賴由人類領域專家,以及專家知識庫。要“進城”獲取知識,必須給平台“城主”交過路費。

但大模型不一樣的地方,一是“不是必須喝奶,喫草也行”,可以直接從原始數據中挖掘知識、抽取知識。DeepMind聯合創始人哈薩比斯曾經設想過,未來的大模型可以直接從與客觀世界的感知交互過程中,利用深度學習算法來總結知識,並直接用於決策。

二是“不依賴人產奶,自己也行”,通過數據驅動的大規模自動化的知識獲取,反哺模型。

ChatGPT、GPT4都具備較強的知識圖譜建構能力,按照要求抽取知識,正確率可以達到88%,這種“生產效率”可比人類寫論文、在問答平台“謝邀,剛下飛機,答一下”,要快得多。

更進一步,業界還在研究能夠大規模編碼和處理各種知識表示結構的大型知識模型(Large Knowledge Model)。從LLM到LKM,對現有人類知識的依賴越來越低了。

所以,是否收錄基於人類知識的平台內容,其實對大模型訓練來說,影響已經很小了。

“喫的是草,吐的是奶”的模型,可以在大數據的曠野上生存,並不一定要進知識平台這座“圍城”,“關門”也就關門吧。

所以我們看到的後續就是,祕塔AI搜索在收到知網的函件之後,表示“學術”版塊僅收錄了論文的文獻摘要和題錄,並未收錄文章內容本身。而且還主動“斷鏈”,不再收錄知網文獻的題錄及摘要數據,轉而收錄其他中英文權威知識庫的文獻題錄及摘要數據。類似的,被知乎以亂碼幹擾的谷歌搜索、微軟必應搜索,模型能力依然領先。

那么,知識平台的反應,難道是過度反應、虛空索敵嗎?平台究竟想“鎖”住什么,恐怕才是值得關注的真問題。

首先,沒必要利用人類知識來訓練模型,並不是說大模型廠商就一定不會侵權。

目前,全球模廠都面臨高質量語料匱乏的隱憂,數據焦渴之下,在未授權的情況下,用到有知識產權的數據是可能發生的。

在某次採訪中,OpenAI的CTO就對“視頻訓練數據是否來自YouTube等公开網站”等問題避而不談。此前,《紐約時報》曾因商談“內容付費”沒有成效,將OpenAI和微軟告上法庭,指控他們未經授權就使用該機構的數百萬篇文章來訓練AI模型。

而前不久,微軟就與學術出版商Taylor & Francis籤署了一項價值1000萬美元的協議,允許微軟訪問其數據來改進AI系統。

由此可見,雖然AI領域的知識產權問題仍然有很多盲區,但與知識平台達成版權合作,應該被模廠及其客戶,納入AI合規和持續性經營的考量中。

此外,即使侵權問題並不存在,但價值衝擊也會發生。

具體來說,AI搜索等新一代AI產品,對知識平台的衝擊有兩方面:

一是流量價值衝擊。盡管祕塔AI搜索聲明中提到,向用戶提供的是知網的學術文獻題錄及摘要數據,用戶要進一步瀏覽正文,要通過來源鏈接跳轉至網站獲取。但搜索引擎將觸角伸到網站,用戶就會減少訪問與站內搜索,從而影響平台的流量和潛在收益,類似於微信此前阻止百度搜索到公衆號內容一樣。

二是知識價值衝擊。基於大模型的AI搜索具備總結、生成等能力,而由於模型可能存在“過擬合”問題,也就是AI自己“腦補”,最終可能輸出給用戶的內容與原文高度一致,沒直接侵權但勝似侵權。

此前就有很多小說作者發現,模型生成的故事大綱與走向與自己寫的高度類似,懷疑雲文檔被用來訓練AI模型,但極有可能是AI跟人類作者“撞腦”了。

大模型經濟的核心價值,是知識的創造與分發。

一位朋友說,“以前有問題,我會上網問知乎,但有些問題我不想讓公衆知道,以後我就問基礎大模型+領域知識+AI Agent打造的專業bot,一次到位”。Perplexity CEO曾明確說過,“我們想成爲世界上最以知識爲中心的公司”,祕塔AI搜索經常被比作中國的Perplexity。

可以看到,即使沒有侵權糾紛,AI企業及產品,也與知識平台,在商業層面形成了直接的替代和競爭關系。

失知識者失天下,從這個角度來說,的確成立。

大模型在數據曠野上狂飆突進,知識平台能否靠“關門上鎖”來守住核心價值呢?或許大家心中已經有答案。

解鎖關鍵信息

知識平台封鎖,鎖不住AI獲取知識的腳步

原文標題 : 大模型沒有“知識圍城”

標題:大模型沒有“知識圍城”

地址:https://www.utechfun.com/post/414966.html