2023年,AI風潮席卷全球,所有人都驚嘆於CHATGPT的出現,很多人日常的生活與工作,都因AI的普及與出現,得到了衆多便捷的工具,無論是AI智能聊天機器人,還是圖形、代碼上的AI快速生成,都對我們有着一定程度的影響。

而NVIDIA前不久推出的CHATWith RTX,則是一款可以本地部署的專屬AI聊天機器人,在你的電腦上就能實現AI功能,通過與大語言模型連接,用檢索增強生成(RAG)、NVIDIATensorRT-LLM軟件及NVIDIARTX加速技術,即可實現與自己專屬的聊天機器人對話。

當然,每個人的CHATWith RTX都是不同的,主要區別與你給AI投放的資料,通過移入自己的文檔、筆記、視頻或其他數據,CHATWith RTX會通過檢索資料內容,快速給予你合適的答案,哪怕是資料不相關的內容,AI也會回答你相對合適的答案。

那我們首先先來簡單試驗下這個CHATWithRTX,首先是安裝問題,軟件安裝包NVIDIA官網便有得下,但安裝過程還是需要下載,且需要一定的科學上網環境,才可完成安裝,在安裝完成後,需要保持網絡環境开啓軟件即可體驗CHATWith RTX。

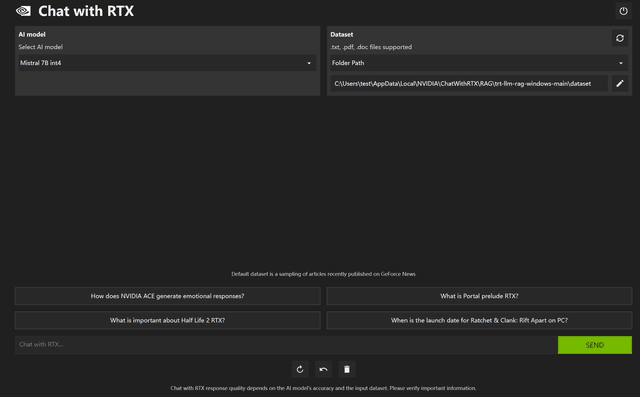

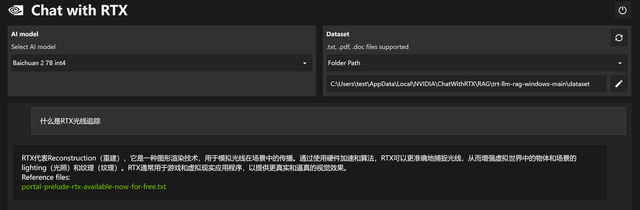

打开CHATWithRTX,可以發現左上角顯示默認採用mistral大模型,右上角則可以選擇資料來源(數據集),目前可選的只有文件夾、油管視頻以及模型本身的,文件支持txt、pdf、doc,只要放在目標目錄下即可(子文件夾也行)。

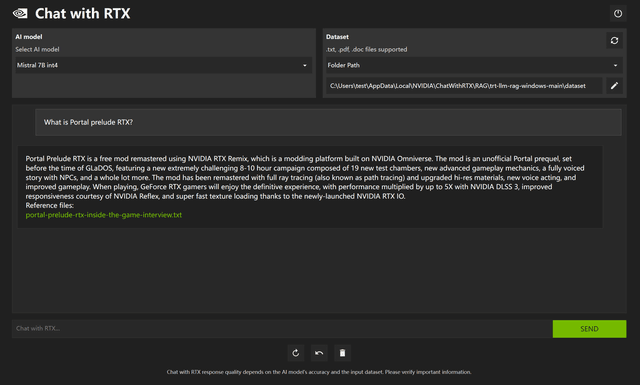

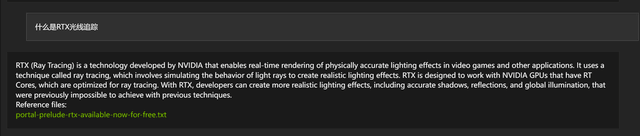

在默認文件夾中,有着NVIDIA各項技術的文檔,那么根據下方提供的問題,首先提問什么是傳送門:序曲RTX版,CHATWith RTX會根據文檔中傳送門的內容,經過大語言模型分析,並給你提供出答案,如果在大量文章中檢索需要的內容,那么CHATWith RTX絕對是快捷方便的工具。

目前CHATWith RTX默認的語言只能使用英文回答,若使用中文提問,也可以得出正確的回答,但依舊是以英文的形式,若想加入中文回答,則需爲CHATWith RTX加入新的中文模型,這過程稍許復雜,並需要科學上網,詳情可參考以下B站視頻鏈接嘗試添加。

https://www.bilibili.com/video/BV1DK421b7JX/

那么我們依據上面視頻內容,添加了百川的大預言模型後,即可做到中文提問中文回答,資料依舊是文件夾裏提供的英文資料,但是不同的是,回答方式改爲了中文,更方便國內用戶使用。

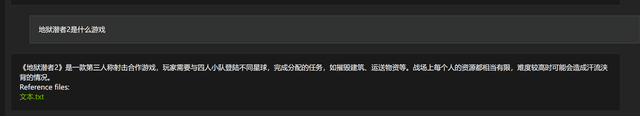

在文件夾中加入過往的文章,重新加載文件夾內容後,即可完成相關內容的檢索,輸入後會快速檢索內容並進行總結描述。

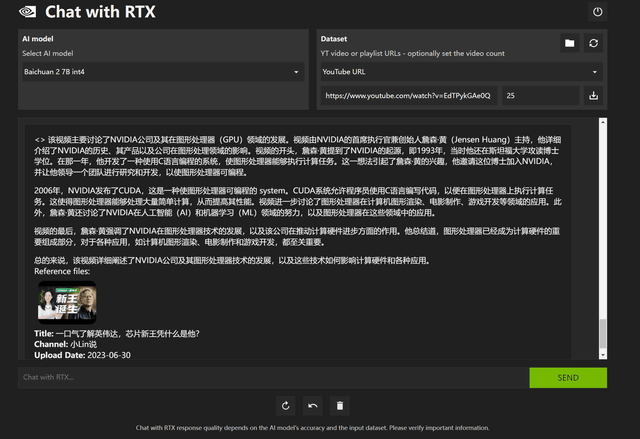

除了文件夾內容檢索外,目前還支持油管視頻檢索,要求CHATWith RTX詳細的介紹該視頻內容,經過一段時間分析,就能將視頻解析個大概,當然有些部分的准確程度不一定很高,但還是處於可以看的水准。

可以看到,目前CHATWithRTX可以快速分析文檔和視頻,配合合適的大語言模型,可以給予准確率不錯的答案,而且由於是本地部署,回答的內容和提供的資料都沒有外泄的可能,在安全性上還是可靠的。不過目前還只是個demo測試版,並且Google後續還會利用NVIDIATensorRT-LLM,優化自家的开放語言模型,以便支持NVIDIAAI平台,相信之後的內容與生態會越來越豐富。

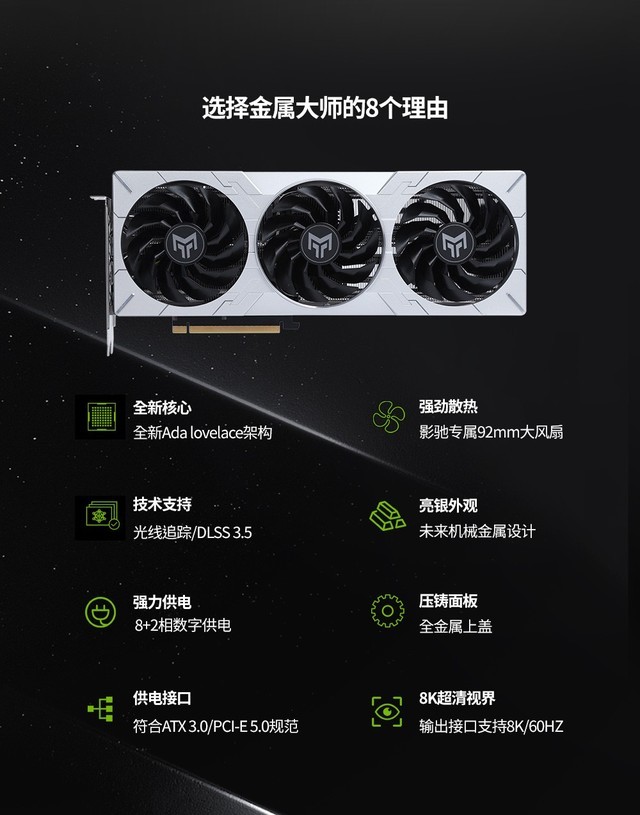

目前想使用NVIDIACHAT With RTX的用戶,需要RTX30、RTX40系顯卡,其他顯卡暫不支持,所以想使用CHATWith RTX的朋友,可以考慮下影馳RTX4070 SUPER金屬大師OC顯卡。

影馳RTX4070SUPER金屬大師OC採用了無燈光設計,外觀主要採用金屬灰,並擁有很強的金屬質感,配合高效的散熱器,可以做到高性能、低溫度、低噪音,無論是遊戲還是AI,都能在高負載下穩定運行,是你研究AI路上的好幫手,喜歡的朋友歡迎來影馳官方商城購入哦~

標題:CHAT With RTX初體驗,本地部署AI的好幫手

地址:https://www.utechfun.com/post/339410.html